Nvidia spint garen door de enorme AI-hype die vandaag iedereen doet investeren in GPU-acceleratoren.

OpenAI stak het vuur aan de lont vorig jaar met de lancering van ChatGPT, het iPhone-moment van AI volgens Nvidia CEO Jensen Huang. Wat volgde was een lawine aan AI-aankondigingen van zowat elk bedrijf dat met IT bezig is. Al die zaken vereisen heel wat rekenkracht die op een GPU gebeuren dankzij de enorme parallelle rekenkracht van die architectuur vergeleken met de CPU.

Nvidia kan niet aan de vraag voldoen vandaag en probeert bij chipfabrikant TSMC om het aantal bestellingen gevoelig de hoogte in te duwen. Op dit ogenblik liggen de prijzen gemiddeld 40 procent hoger dan de adviesprijs en worden er zeker nog tot eind dit jaar tekorten verwacht.

China wil meer GPU’s

Volgens DigiTimes trekt China ook sterk aan de mouw van Nvidia. De AI-hype dwingt bedrijven zoals Baidu om massaal chips aan te kopen. Door de handelsoorlog tussen de VS en China mag Nvidia zijn A100 en H100-GPU’s niet verkopen, maar de fabrikant biedt aangepaste versies aan onder de noemer A800 en H800.

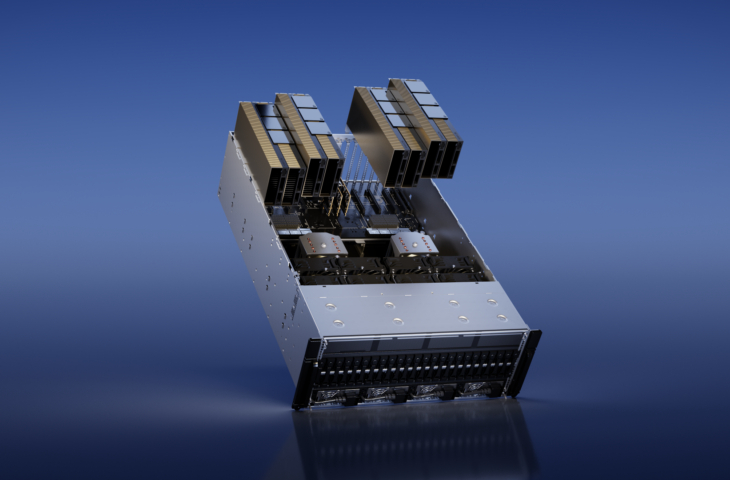

De Nvidia A100-GPU is het ‘oudere’ model en wordt op het 7 nanometerproces gebakken. De nieuwste H100-GPU maakt gebruik van het gloednieuwe 4 nanometerproces. Het spreekt voor zich dat bedrijven vandaag vooral azen op de H100-GPU en DGX H100-servers van Nvidia waar H100-GPU’s in zitten.

lees ook

Nvidia H100-GPU’s kosten al meer dan 40.000 dollar in het wild

Verschuiving van productie

Volgens Wccftech geeft Nvidia eerst prioriteit aan niet-Chinese technologiepartners. Dat betekent dat de standaard levertijd van drie maanden in China ondertussen is opgelopen tot zes maanden of langer.

Daartegenover staat dat de GPU’s voor gamers vandaag niet als zoete broodjes over de toonbank vliegen. De kunstmatige bubbel die cryptominers hebben gecreëerd zorgt vandaag nog altijd voor te hoge prijzen, wat de vraag drukt. Nvidia zou naar verluidt een deel van die productiecapaciteit hebben geschoven naar meer datacenter-GPU’s om de grote vraag daar te ondersteunen.

Microsoft liet eerder al weten dat OpenAI zijn GPT-modellen traint op een HPC-cluster in Azure met tienduizenden GPU’s. Pas bleek nog dat ook Elon Musk opnieuw in de AI-wereld wil stappen. Daartoe richtte hij een nieuw bedrijf op en kocht hij de nodige hardware: opnieuw zo’n 10.000 GPU’s.