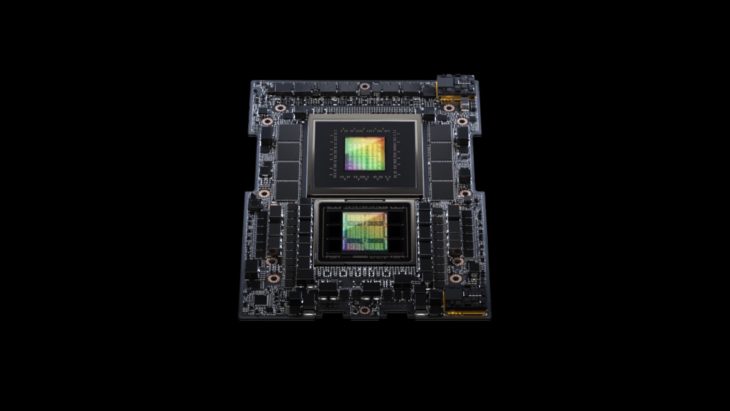

De Nvidia GH200, de Grace Hopper Superchip, krijgt een boost in geheugensnelheid en een ruimer platform met 3,5x meer capaciteit.

Nvidia gooit dit jaar hoge ogen met de bijzonder krachtige Grace Hopper Superchip. Alle details daarrond kan je hier uitgebreid lezen. De krachtige AI-chip koppelt een ARM-chip met de krachtige GPU van Nvidia, de H100. Het is een natte droom voor generatieve AI-workloads en het brengt ook flink wat geld op voor Nvidia, dat de vraag amper kan volgen. Een losse Nvidia H100 GPU kost vandaag al gemiddeld 40.000 dollar.

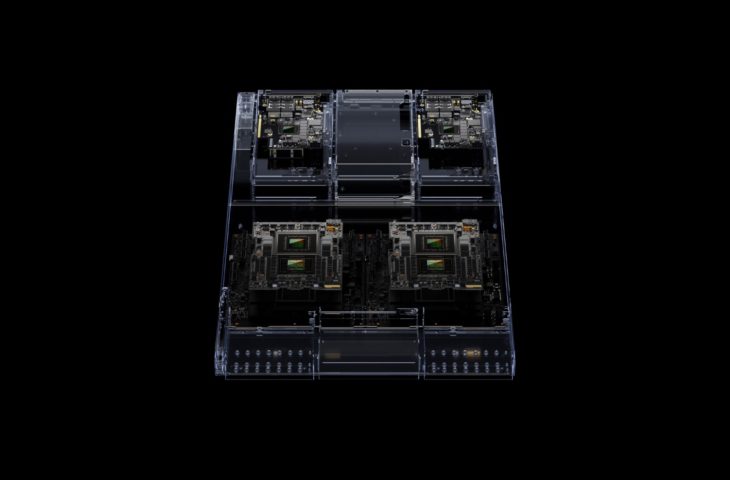

De Nvidia NH200 is niet nieuw, maar het platform waarop de fabrikant twee zo’n chips bundelt, is dat wel. Hiermee focust Nvidia op complexe generatieve AI-workloads zoals LLM’s en vector databases. Er zijn tal van configuraties beschikbaar. Het topmodel bevat 144 Arm Neoverse-kernen, 8 petaflops aan AI-prestaties en een hallucinante 282 GB aan HBM3e-geheugen.

HBM3e als primeur

In samenwerking met SK Hynix mag Nvidia als eerste aan de slag met HBM3e. Dankzij onder andere het kleinere 10 nanometer-proces is deze nieuwe versie zo’n 50 procent sneller dan HBM3 die traditioneel op een Nvidia GH200 zit. Die hogere snelheid is belangrijk voor LLM’s en neurale netwerken algemeen, omdat hun architectuur dat optimaal kan gebruiken.

In een dubbele configuratie op het nieuwe GH200 Grace Hopper Superchip platform claimt Nvidia dat de geheugencapaciteit tot 3,5 keer hoger ligt en drie keer meer bandbreedte biedt dan de huidige generatie. In totaal levert HBM3e 10 TB/s aan gecombineerde bandbreedte.

Snelle supercluster

Het nieuwe platform vormt ook de basis van een datacentersysteem dat het Grace Hopper Compute Tray noemt. Elk systeem combineert een enkele GH200 samen met Nvidia’s BlueField-3 en ConnectX-7 chips. Die laatste twee chips zijn bedoeld om netwerktrafiek van en naar de server te versnellen. BlueField-3 kan ook een beperkt aantal compute-taken op zich nemen.

In totaal kunnen tot 256 Grace Hopper Compute Tray-modules worden gekoppeld in één cluster. Volgens Nvidia CEO Jensen Huang kan zo’n cluster 1 exaflop aan AI-prestaties leveren.