Nvidia-CEO Jensen Huang geeft toe dat instances met Nvidia-hardware duur zijn in absolute cijfers, maar stelt dat ze die kost waard zijn. Wanneer je AI-modellen gaat trainen met Nvidia’s raamwerk, zou het prijskaartje al helemaal interessant worden.

Nvidia maakt geen processors, maar wel GPU’s en accelerators. Houd dat in je achterhoofd wanneer je naar Jensen Huang luistert. Nvidia’s CEO legt op de Snowflake Summit in Las Vegas uit dat CPU’s afgedaan hebben. “Opschalen met alleen CPU’s gaat gewoon niet meer”, zegt hij. “Investeer je meer in alleen processors, dan koop je nauwelijks extra rekenkracht.”

Grootste innovatie ooit

Volgens Huang is het duidelijk dat CPU-ontwikkeling aan zijn laatste hoofdstuk bezig is en komt die evolutie op een cruciaal moment. “AI is de grootste innovatie in de computerwereld die we ooit hebben gezien”, denkt hij. “Een computer kan voortaan software schrijven voor zichzelf, dat is ongezien.”

De doorbraak van AI komt er net nu de CPU volgens Huang is uitgeteld, maar dat is niet erg. AI-workloads werken immers anders dan traditionele workloads en vereisen accelerators. “Je moet iedere workload accelereren die je kan”, benadrukt hij.

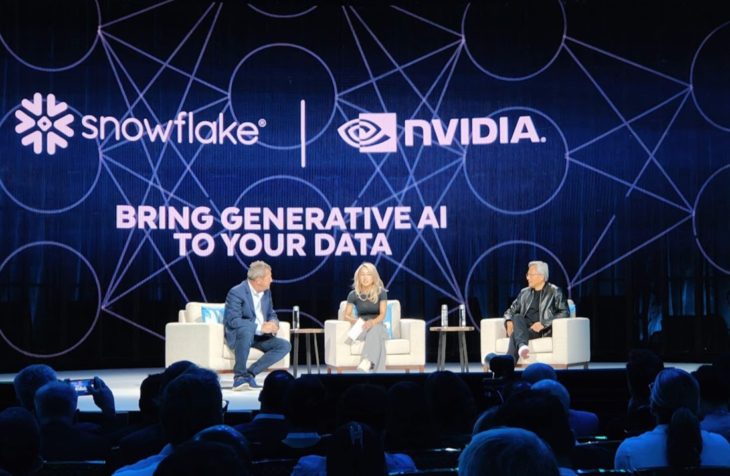

Hoe accelereer je volgens Huang? Met Nvidia natuurlijk. “Je moet alles overal op Nvidia kunnen draaien.” Met dat in het achterhoofd is Huang aanwezig op de Snowflake-top, waar hij een nieuwe samenwerking tussen de twee bedrijven in de verf zet. De toekomst is dus AI, ondersteund door Nvidia-GPU’s.

Niet gratis

“Maar dat is niet gratis”, laat Snowflake-CEO Frank Slootman zich ontvallen. Huang geeft toe dat Nvidia ook centen wil voor z’n hardware. “Cloud-instances met onze accelerators zijn steevast de duurste in het arsenaal van hyperscalers”, bevestigt hij. “In absolute cijfers is de kost het hoogst.

Maar als je dan kijkt hoeveel workloads die instances kunnen verwerken, verandert het verhaal. Gekeken naar de prijs per workload bieden Nvidia-instances de beste TCO (Total Cost of Ownership) van allemaal.

Vers van de schoolbanken

Wanneer je Nvidia’s hele stack gebruikt, wordt het verhaal helemaal interessant. Huang verduidelijkt. “Met NeMo kan je fundamentele AI-modellen trainen met je eigen data. Die fundamentele modellen zijn vooraf al getraind door ons op supercomputers. Daar investeerden we tientallen miljoenen euro’s in. De fijnere training achteraf kost slechts een fractie.”

Hij vergelijkt fundamentele modellen met talentvolle schoolverlaters. “Een fundamenteel model is als een slimme werknemer die pas afstudeerde. Hoe intelligent die ook is, je zal altijd moeten investeren in onboarding om hem of haar mee te krijgen in je bedrijf.”

Die onboarding neemt de vorm aan van verdere training van een fundamenteel model op eigen data. Dat kost volgens Huang inderdaad geld, maar in feite maar een fractie van de totale kost van wat het eindresultaat waar is.

Begraaf de CPU nog niet

Huang verantwoord de meerprijs van Nvidia hard- en software met duidelijke argumenten. Hij heeft een punt, al mist het betoog wel wat nuance. Zo toont concurrent AMD duidelijk dat de CPU nog lang niet is uitgeteld en nieuwe innovaties wel degelijk voor prestatieboosts zorgen.

Bovendien kennen AI-workloads een grote boom, maar zijn de meeste bedrijfsworkloads wereldwijd nog erg traditioneel. Die accelereren gaat niet zomaar, al hebben ze wel baat aan snellere en efficiëntere processors.

In de context van AI maakt Huang dan wel weer een sterke case voor Nvidia, zowel wat de kracht van acceleratie betreft, als de waarde van ene fundamenteel AI-model binnen het NeMo-raamwerk.