[ADV] De kracht van een server voor rekenwerk was lange tijd afkomstig van de CPU aan de binnenkant. Vandaag wordt een ander component belangrijker: voor hedendaagse workloads zwaait de GPU de plak.

De CPU is niet meer het hart van de moderne server. Of tenminste, niet meer alleen. In servers voor rekenworkloads zoals machine learning en AI-training speelt de processor geen doorslaggevende rol meer. De chip moet natuurlijk krachtig genoeg zijn, maar het nieuwe brein van de server is de GPU. Dat betekent niet dat processors plots niet meer belangrijk zijn. Niet alle workloads hebben baat bij GPU-acceleratie. Opslagservers of VDI-systemen zweren nog wel bij CPU-rekenkracht en dat zal nog wel even zo blijven. Het zijn vooral modernere workloads die het serverlandschap veranderen.

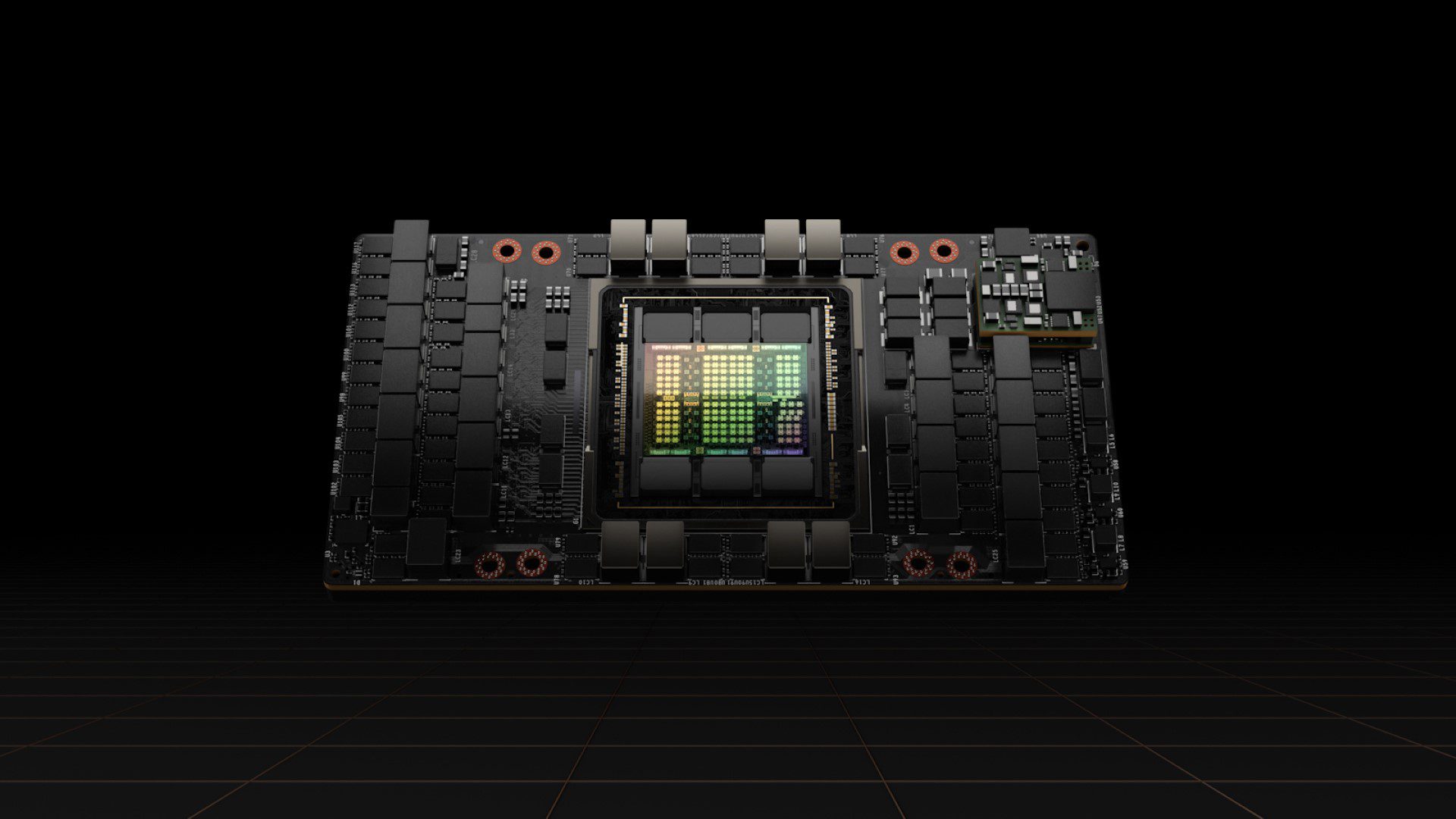

NVIDIA A100

NVIDIA heeft de markt daarvoor vrijwel eigenhandig gecreëerd. Het bedrijf startte nederig als een specialist in grafische kaarten voor gamers, maar is vandaag dé naam wanneer we over AI spreken. De klinkende naam vandaag is de A100. Die GPU lanceerde NVIDIA midden 2020 al. De chip is gebaseerd op de Ampere-architectuur maar is ondanks de leeftijd nog steeds bliksemsnel.

Sterker nog: NVIDIA kondigde pas een opvolger aan in de vorm van de Hopper H100 maar gaf terzelfdertijd mee dat de prestaties van de A100 voor bepaalde workloads intussen zes keer beter zijn dan bij de lancering twee jaar geleden. Dat illustreert niet alleen hoe software samen met de hardware verder ontwikkelt, maar ook hoe performant de architectuur zelf is.

Servers gericht op GPU’s

De A100 en zijn afgeleide chips winnen zo alsmaar aan belang in de servermarkt. Zeker in HPC-systemen gericht op AI-gerelateerde workloads, worden ze onontbeerlijk. Het is dan ook goed nieuws dat het aanbod van servers met de chips aan boord sterk stijgt. Aan de bovenkant van het spectrum zijn er toestellen zoals de Gigabyte G492-ZD2. Dat toestel biedt plaats voor acht NVIDIA HGX A100’s. Die worden bijgestaan door AMD Epyc Rome of Milan-chips in een dual socket-configuratie. De nadruk ligt echter op de A100-GPU’s.

Een dergelijk systeem is geschikt om enorme datasets te analyseren, modellen te bouwen en complexe simulaties te draaien. De CPU’s staan ten dienste van de GPU’s, waar het niet zo lang geleden nog andersom was.

Doordat de GPU gradueert van accelerator naar centraal component, is er plaats voor nieuwe accelerators. Ook daar speelt NVIDIA handig op in met zijn Data Processing Units of DPU’s. Die nemen data- en netwerkgerelateerde taken over van de rest van het systeem. Minder overhead betekent meer pk’s voor nuttig werk, en meer efficiëntie.

Een variant voor iedereen

GPU’s sijpelen intussen door van echte HPC-servers naar steeds meer mainstreamhardware. Bedrijven groot en klein kunnen immers profiteren van versnelde analytics-workloads en dat weerspiegelt het aanbod. Net zoals een dual socket-server niet voor iedereen nodig is, hoeft niet iedere onderneming in een server met acht NVIDIA HGX A100-GPU’s te investeren.

Zo zien we meer toegankelijke servers zoals de Gigabyte G292-Z20 met plaats voor acht kaarten of de R282-Z96, die plaats biedt aan drie GPU’s via PCIe. Ook die systemen hebben een stevige processor nodig, maar de chip uit de AMD Epyc 7003-reeks staat vooral ten dienste van de GPU-rekenkracht.

Koel en vochtig bewaren

Al dat geweld heeft echter zijn keerzijde. Meer, krachtiger en compacter zijn de mantra’s van de industrie en dat genereert warmte. Een server bevat immers niet gewoon één of twee krachtige CPU’s, maar ook verschillende GPU’s met een TDP dat per component even hoog of hoger ligt.

Fabrikanten gaan daarom aan de slag met nieuwe waterkoelingstechnieken met de ambitie om servers compatibel te maken. Tijdens ons bezoek aan de ISC High Performance-beurs in Hamburg kwamen twee zaken prominent in beeld: de GPU’s van NVIDIA langs de ene kant en waterkoeling langs de andere. Beide trends gaat hand in hand.

lees ook

Nieuwe servers, nieuwe koeling: van een frisse bries aan de edge tot kopje onder in een oliebad

Voor de toekomst kan je uitkijken naar immersiekoeling, waarbij een server wordt ondergedompeld in een niet-elektriciteitsgeleidende vloeistof. Dergelijke oplossingen bestaan al, maar er is nog werk aan de winkel. Je kan immers niet zomaar de ventilatoren van een GPU-server trekken en het ding in een vloeistofbak kiepen. De hele warmtecirculatie verandert en dat op soms onverwachte manieren. Fabrikanten proberen nu die dynamieken in kaart te brengen om zo servers te certifiëren voor immersiekoeling.

NVIDIA centraal

De trein heeft het station hoe dan ook verlaten. Machine learning en analytics zijn niet langer grote woorden voor grote ondernemingen. Iedereen kan ermee aan de slag en de juiste hardware staat ter beschikking. Dat vereist een initiële investering, aangezien je met een CPU-server voor dit type workload niet ver zal komen.

Het koelingsprobleem volgt op de voet. Investeer je vandaag, dan zal dat waarschijnlijk in een traditionele luchtgekoelde oplossing zijn. Immersiekoeling staat echter om de hoek. Op termijn heeft die technologie de capaciteit om complexere, krachtigere en warmere servers toch efficiënter te koelen, zodat de datacenters van morgen duurzamer worden.

In het midden van die evolutie vinden we niet de processors van AMD of Intel, maar de GPU’s van NVIDIA. Dat zal de komende jaren nog duidelijker worden, aangezien de fabrikant werkt aan zijn eigen CPU om de GPU’s bij te staan. Zo naderen we een tijdperk waarin servers enkel en alleen powered by NVIDIA zijn.

Dit is een commerciële bijdrage in samenwerking met Gigabyte en NVIDIA. Klik hier voor meer informatie over de GPU-servers van Gigabyte.