Nvidia introduceert nieuwe GPU’s die geoptimaliseerd zijn om eerder ontwikkelde AI-modellen op een efficiënte manier te gebruiken. Dat is met de razendsnelle democratisering van complexe AI-functionaliteit broodnodig volgens het bedrijf.

Training van nieuwe AI-modellen vergt enorm veel GPU’s, en dan moet je de dingen nog in gebruik nemen. Microsoft alleen al ondersteunde OpenAI in het trainingsproces van zijn GPT-model met een AI-supercomputer in de cloud die bestaat uit tienduizenden GPU’s. Om de functionaliteit van GPT-4 nu effectief naar gebruikers te brengen in de vorm van producten, zal Microsoft nogeens honderdduizenden GPU’s uitrollen over al zijn verschillende datacenterregio’s, weet Nvidia. “En dat is maar één klant.”

Een getraind AI-model gebruiken, dat heet inferentie. Inferentie is een stuk minder GPU-intensief dan training, maar gebeurt op veel grotere schaal. Wanneer duizenden mensen tegelijk met ChatGPT praten, dan zijn dat duizenden inferentie-workloads die gelijktijdig moeten draaien. Nu AI-functionaliteit op grote schaal beschikbaar komt, is er volgens Nvidia nood aan hardware om die ambitie te ondersteunen.

Nvidia L4

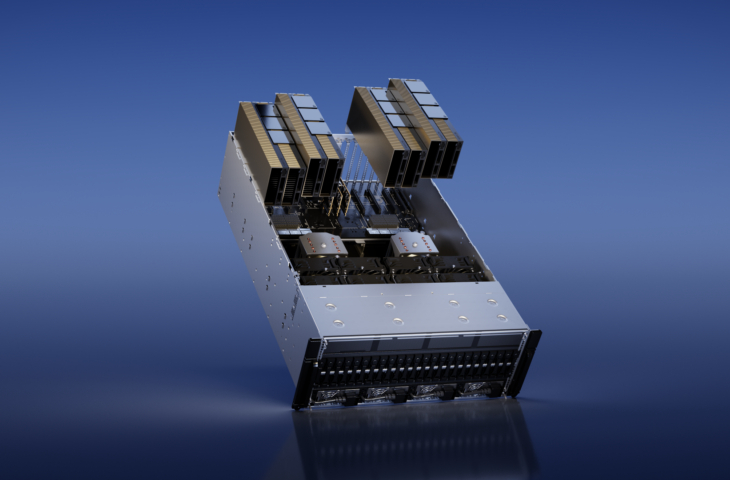

Op GTC 2023 introduceert CEO Jensen Huang daarom de Nvidia L4 en de Nvidia H100 LVL. De Nvidia L4 is een accelerator speciaal ontwikkeld om efficiënt inferentie uit te voeren op videostreams. De GPU neemt slechts één slot in beslag en is zo best compact. Daardoor past die in iedere server, klinkt het enthousiast.

De GOU zou AI-video zo’n 120 keer vlotter verwerken dan servers met enkel CPU’s. Verder is de chip vier keer sneller dan de vorige generatie van Nvidia-accelerators. Voor generatieve AI-workloads gericht op beeldcreatie is dat 2,7 keer efficiënter. Google zal servers met de kaart in early access aanbieden in zijn cloud en ook klassieke fabrikanten hebben al hardware op de planning staan.

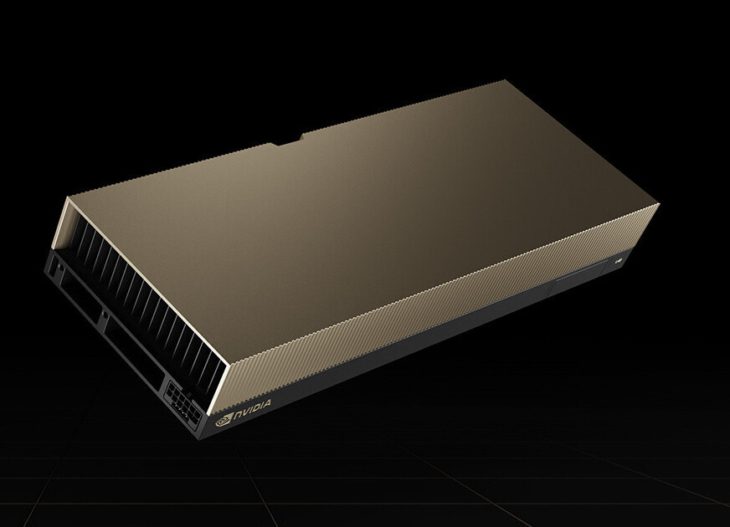

Nvidia H100 NVL

De Nvidia H100 NVL is een Hopper-gebaseerde inferentie-accelerator geoptimaliseerd voor Large Language Model (LLM)-inferentie, zoals praten met ChatGPT. Waar de L4 een relatief bescheiden component is, mogen we de H100 NVL gerust een krachtpatser noemen. Het ding combineert twee GPU-chips met 188 GB HBM3-geheugen, geconnecteerd via NVLink.

De doorvoercapaciteit van dit nieuwe product moet zo’n twaalf keer groter zijn dan bij de Nvidia HGX A100. Vergeleken met de klassieke Nvidia H100 PCIe is de H100 NVL zo’n, 2,5 keer krachtiger. Over beschikbaarheid weten we nog niets.

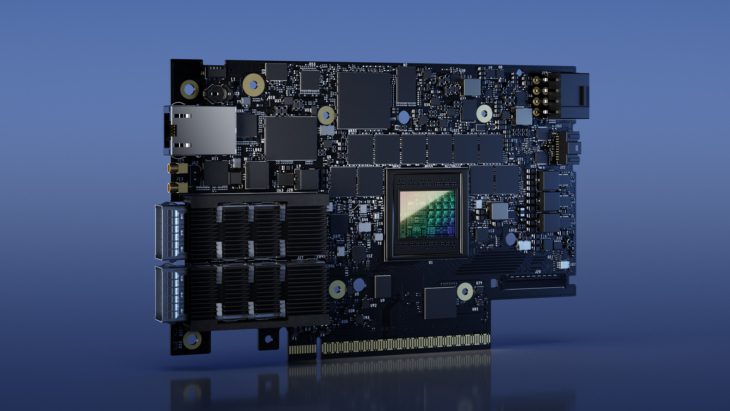

Nvidia laat in de marge nog weten dat zijn BlueField-3-DPU ook in productie is. Die is niet gericht op AI-workloads an sich, maar accelereert de netwerkcomponent van servers en zorgt zo voor optimalisering.