De krachtigste GPU uit de stal van Nvidia, de Hopper H100, is vanaf oktober breed beschikbaar bij tal van aanbieders binnen de cloud en on-premises.

Na de aankondiging in maart is de Nvidia H100-GPU vanaf oktober eindelijk beschikbaar. De chip moet de krachtigste accelerator worden voor AI-workloads in datacenters. Die claim werd extra kracht bij gezet door de recente indrukwekkende resultaten in de MLPerf-benchmarktests.

De cijfers tonen aan dat de Nvidia H100 zo’n 4,5 keer beter presteert dan de ‘oude’ Nvidia A100, die vandaag nog steeds bekend staat als een absolute krachtpatser. De nieuwe accelerator verbetert de prestaties in alle testsituaties. Deze eerste onafhankelijke resultaten tonen aan dat Nvidia zijn leiderspositie nog niet meteen kwijt is.

Meer rekenkracht is altijd belangrijk, maar Nvidia wijst ook naar de veel betere energie-efficiëntie van Hopper. Vergeleken met de vorige Ampère topchip (Nvidia A100) is de H100 tot 3,5 keer efficiënter. De fabrikant wijst ook naar een driemaal lagere TCO omdat je vijf keer minder server nodes nodig hebt dan de vorige generatie.

On-premises en in de cloud

Vanaf volgende maand kan je Hopper configureren in oplossingen van Dell Technologies, HPE, Lenovo en Supermicro. Nvidia biedt ook eigen oplossingen aan in de vorm van eigen DGX-systemen.

Bij een machine wordt een licentie van vijf jaar meegeleverd voor de Nvidia AI Enterprise softwaresuite. Hiermee kan je AI-workflows ontwikkelen en optimaliseren en krijgen organisaties toegang tot AI-frameworks en tools om AI-toepassingen te bouwen.

Wie af en toe modellen op een Nvidia H100-machine wil draaien, kan terecht bij AWS, Google Cloud, Microsoft Azure en Oracle Cloud. Deze platformen zullen als eerste de Hopper-chips aanbieden.

Monsterchip

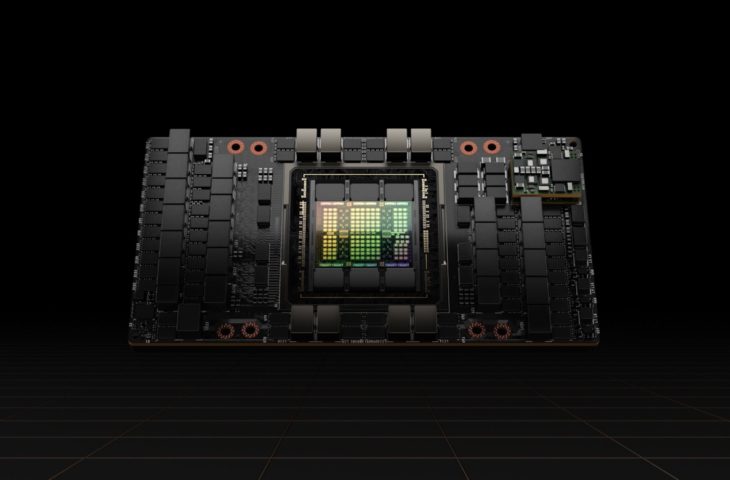

De Nvidia Hopper H100 moet opnieuw ’s werelds krachtigste accelerator zijn. Nvidia perst 80 miljard transistors op de chip met de hulp van TSMC’s ultramoderne 4 nm-bakproces. De GPU ondersteunt PCIe Gen 5 en gebruikt als allereerste chip ter wereld HBM3-geheugen, goed voor een geheugenbandbreedte van 3 TB/s. Nvidia voorziet 80 GB per chip. Wat klassieke rekenkracht betreft, is de Nvidia H100 drie keer sneller dan de Nvidia A100. De chip heeft een rekenkracht van 2.000 TFlops (FP16). Voor al die rekenkracht heeft de H100 een TDP van 700 watt.

Om machine learning met transformer-modellen zoals Megatron te faciliteren, heeft de H100 een nieuwe transformer-engine aan boord. Die verhoogt de efficiëntie en snelheid van de training van natural language-modellen met factor zes zonder in te boeten op nauwkeurigheid.

Lees alles over de Nvidia H100-chip in onze uitgebreide analyse.