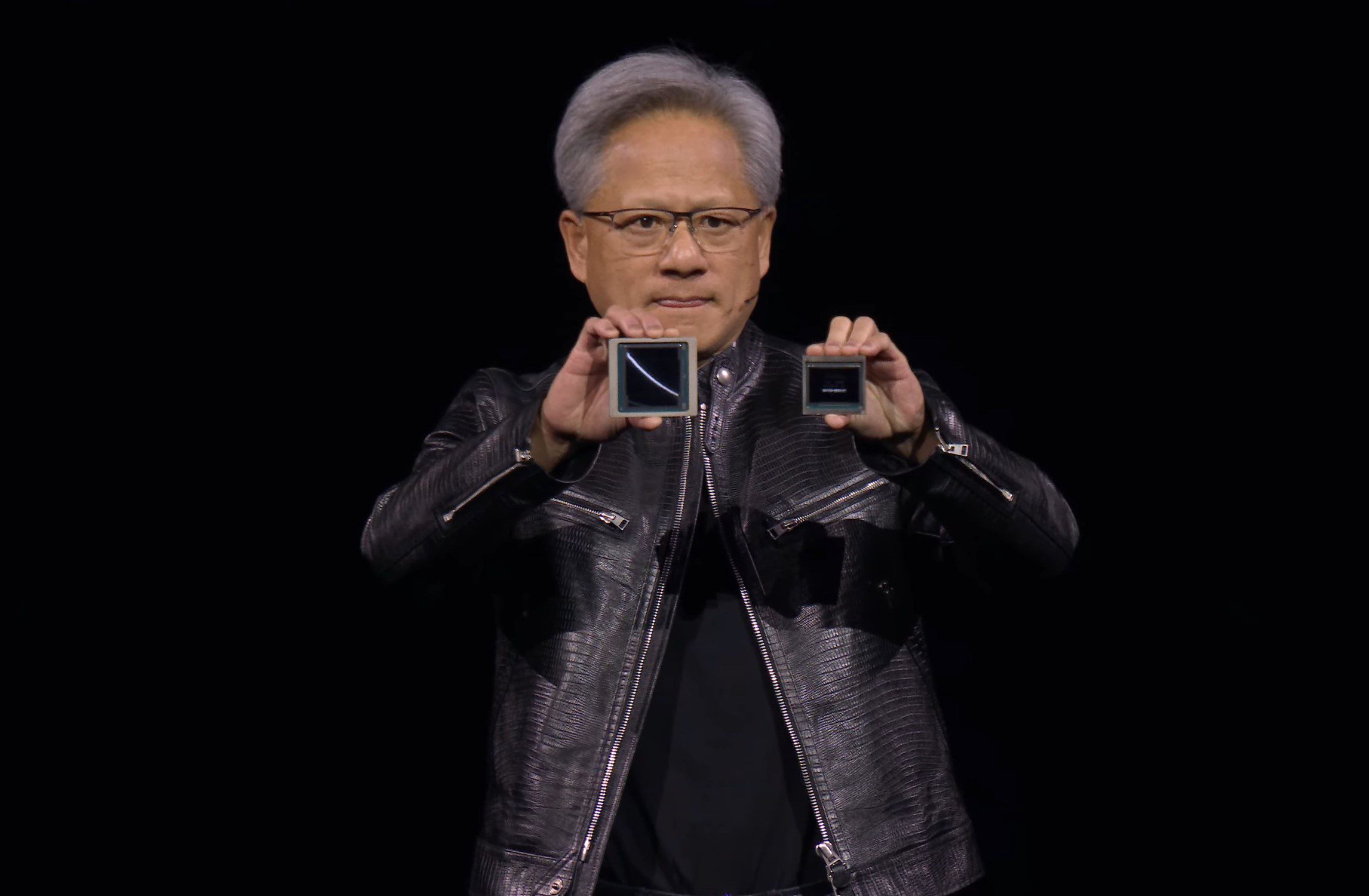

Nvidia lanceert de nieuwste generatie GPU-technologie. Onder de noemer Blackwell brengt het drie chips uit: Nvidia B200, B100 en GB200

De opvolger van de Nvidia H100 Hopper-chips is bekend. Onder de naam Blackwell onthult Nvidia het volgende hebbeding in de AI-wereld. De hardware van de fabrikant is gegeerd in de huidige hype rond generatieve AI. Nvidia H100-chips hebben vandaag nog altijd lange levertijden omdat onder andere hyperscalers tienduizenden GPU’s aankopen om HPC-clusters te bouwen.

Vandaag zet Nvidia een nieuw punt aan de horizon met Blackwell. Het introduceert drie varianten: B100, B200 en GB200. Elk van deze chips gebruiken dezelfde architectuur, maar verschillen in hun toepassingsgebied.

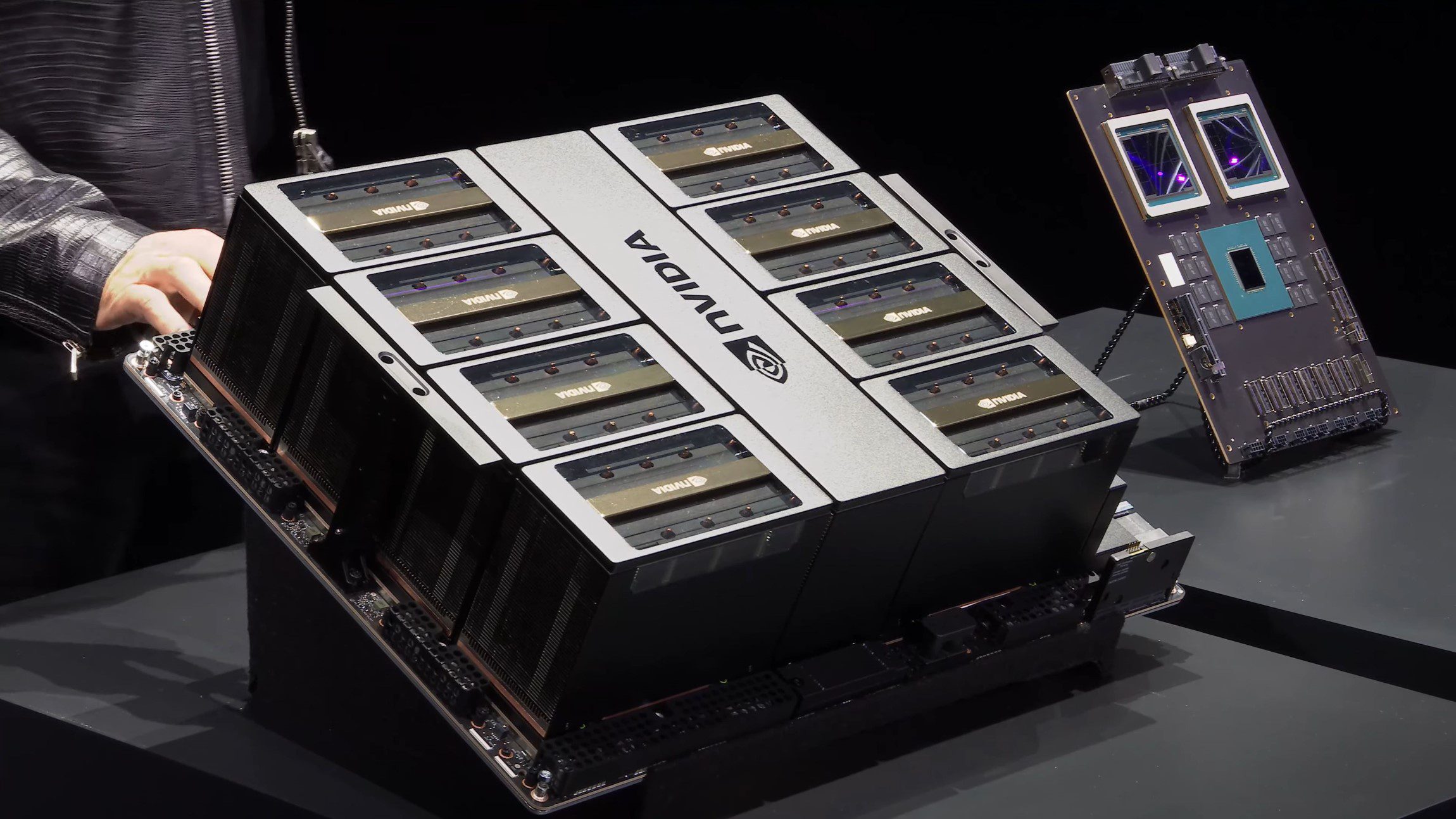

- Nvidia B100: bruikbaar in huidige systemen waar ook al Nvidia H100-chips in zitten. Kunnen luchtgekoeld aan 700 watt tot 7 petaFLOPS leveren aan FP8, wat efficiënter is dan de huidige H100-reeks.

- Nvidia B200: Het topmodel dat tot 10 petaFLOPS kan leveren aan FP8, mits waterkoeling. De chip heeft een piekverbruik van 1.200 watt. Luchtgekoeld ligt de limiet op 1.000 watt en kan de chip tot 9 petaFLOPS aan FP8 leveren.

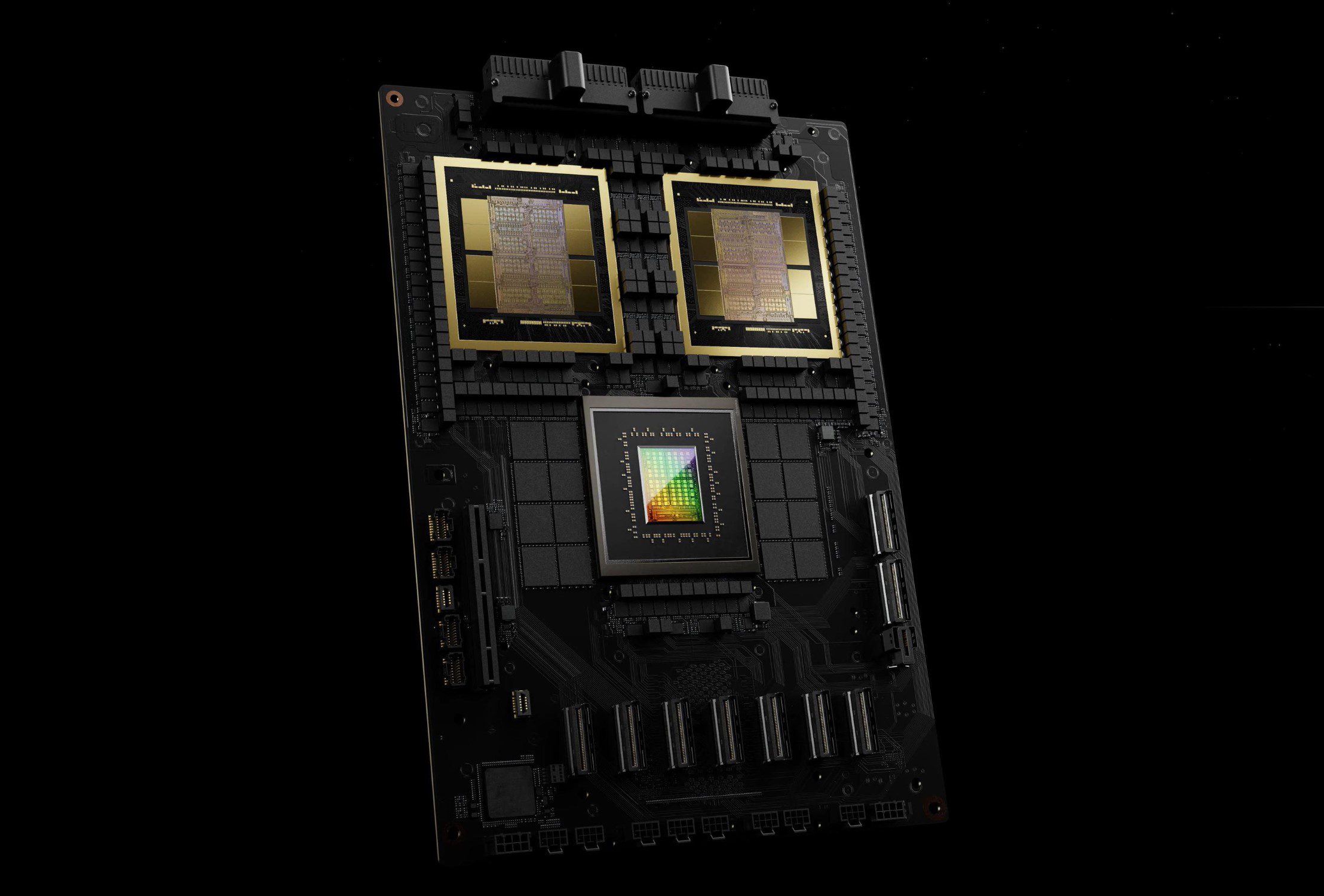

- Nvidia GB200: De ‘Superchip’ volgens Nvidia met twee B200-chips op één systeem, gekoppeld aan een 72-core Grace CPU die eerder al in de Nvidia GH200 zat. Rekening houdend dat die Grace ARM-chip op 300 watt piekt, zou Nvidia GB200 potentieel tot 2.700 watt kunnen verbruiken. Het spreekt voor zich dat deze opstelling enkel met waterkoeling bruikbaar is. GB200 levert tot 20 petaFLOPS aan FP8.

Twee chips aan elkaar geplakt

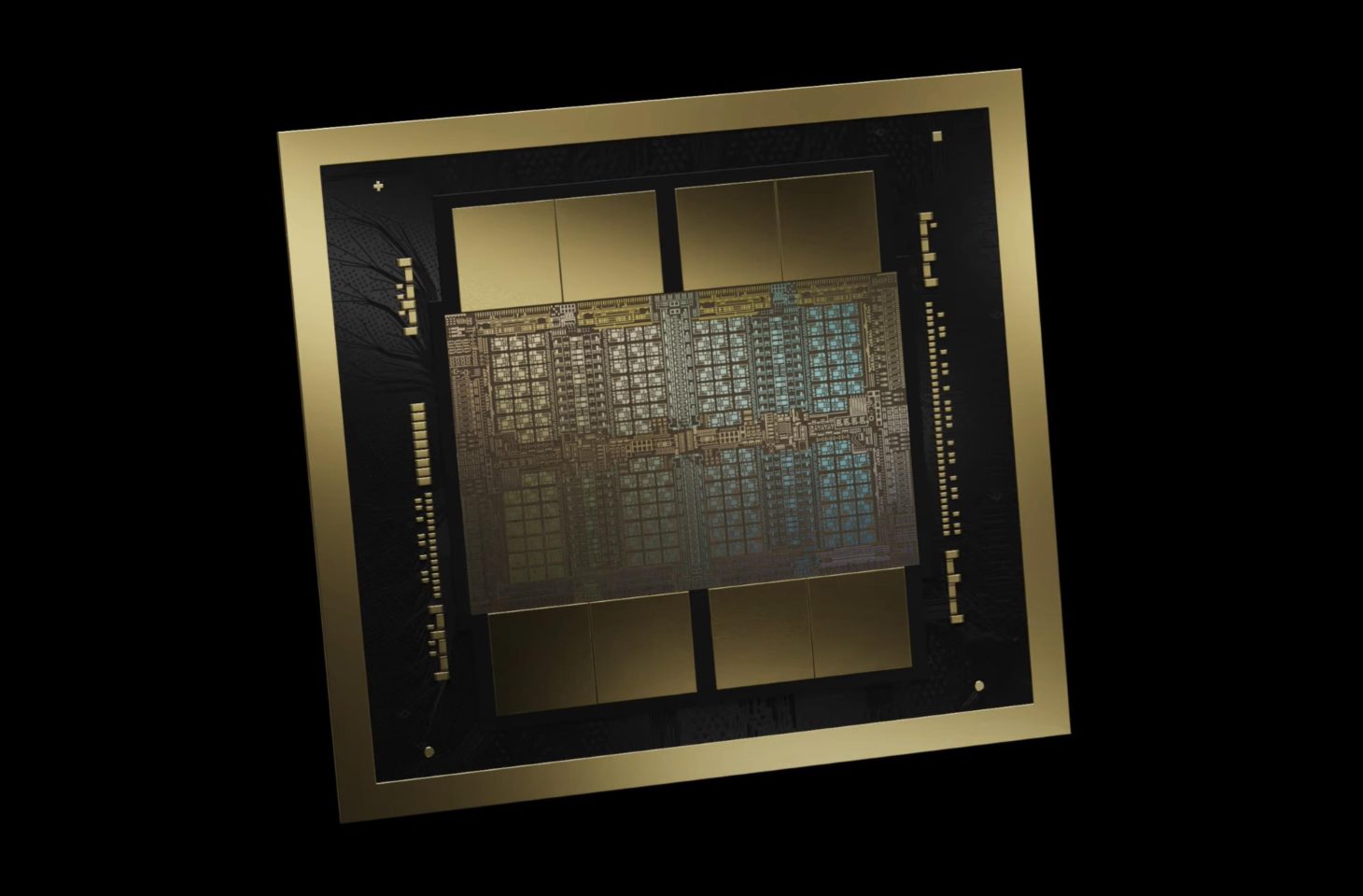

Voor het eerst in jaren maakt Nvidia niet gebruik van een procesverkleining om een nieuwe chip te lanceren. Blackwell wordt op hetzelfde 4 nanometerproces gebakken als Hopper. Toch kan Nvidia meer transistors per die persen, 104 miljard tegenover 80 miljard in de Nvidia H100.

Desondanks verdubbelt Nvidia de prestaties vergeleken met het vorige topmodel. Het realiseert dat door twee dies tegen elkaar te ‘plakken’. Voor het eerst omarmt het hiermee het chiplet-model dat AMD en Intel al langer gebruiken. Dat moet ook wel: hoe groter de chip, hoe groter het risico op fouten bij het bakken bij chipfabrieken zoals TSMC. Bovendien hou je ook minder chips over op een ronde wafer.

Nvidia B200 heeft dus 208 miljard transistoren aan boord. Via een eigen ontwikkelde connectie tussen beide dies, NV-High Bandwith Interface (NV-HBI) is er 10 TB/s aan bandbreedte beschikbaar.

Elke die wordt geflankeerd door vier torens (24 GB per module) aan snel HBM3E-geheugen. Dit betekent dat de Nvidia B200 in totaal acht modules heeft, goed voor 8.192 bit geheugenbus. De chip heeft 192 GB HBM3E beschikbaar, goed voor een geaggregeerde geheugenbandbreedte van 8 TB/s.

Wat betekent dit in de praktijk?

Kijken we naar de cijfers, dan doet Blackwell het 2,5 keer beter dan Hopper binnen FP8. Nvidia heeft echter veel ambitieuzere doelstellingen. Het verwacht dat de B200 tot vier keer beter presteert in trainingsprestaties. Nog belangrijker: een enorme 30x-boost in inference-prestaties, terwijl het dat 25x energiezuiniger doet.

Dat laatste is heel belangrijk voor Nvidia om ook daar zijn stempel te drukken. Om AI te trainen (bv. LLM’s), staat Nvidia aan de top en heeft het met AMD MI300 en Intel Gaudi 2 beperkte concurrentie. Inference, een interactie met zo’n LLM zoals je een vraag stelt aan ChatGPT, daarin is veel meer concurrentie.

Door een grote stap voorwaarts te zetten in efficiëntie en prestaties met Blackwell, wil Nvidia ook daar duidelijk maken dat het een belangrijke partij blijft.

Nvidia deelt vandaag al een deel van de prestaties van Blackwell. De fabrikant legt nog niet alle details op tafel. Zo is het nog onduidelijk op welke frequentie de GPU-kernen draaien en hoeveel het er zijn.

Het enige waar Nvidia moet inboeten, is in FP64-prestaties. Hoe hoger het cijfer achter de FP, hoe preciezer het resultaat. Daarom dat AMD heel wat supercomputer-contracten binnenhaalt met zijn MI300-chip (163 teraFLOPS in FP64). Opvallend is dat Blackwell (40 teraFLOPS) in FP64 minder goed scoort dan Hopper (67 teraFLOPS).

Waarom ineens FP4?

Een van de belangrijkste aankondigingen van Hopper is was ondersteuning voor FP8. Omdat transformatoren niet al hun parameters met hoge precisie (FP16) hoeven te verwerken, had Nvidia ondersteuning toegevoegd voor het mengen van die bewerkingen met bewerkingen met lagere precisie (FP8). FP8 vermindert de geheugenbehoefte en verbetert de doorvoer gevoelig.

Dit in combinatie met de lancering van taalmodel GPT-3 en de bijhorende dienst ChatGPT zorgde voor een revolutie en legde Nvidia geen windeieren.

Met Blackwell herhaalt Nvidia dit opnieuw en gaat het tot FP4. Hoe hoger het cijfer, hoe accurater het resultaat. Na FP16 bleek dat FP8 voor heel wat zaken ruim goed genoeg is. FP4 is opnieuw een stap lager. De marketingafdeling van Nvidia heeft niets liever: dubbel zoveel petaFLOPS tonen. Of FP4 ook in de praktijk bruikbaar genoeg is, valt af te wachten.

Nu direct kopen of wachten?

Moet iedereen nu snel zijn bestelling annuleren van hardware met ‘oude’ Nvidia H100-chips aan boord? Nee, omdat je mogelijk al in de rij staat aan te schuiven en nog maanden moet wachten tot de hardware is geleverd. Zelfs nieuwe bestellingen voor H100-systemen zijn vandaag nog relevant om te plaatsen.

Meer nog: de Nvidia H200-chips, een H100-variant met HBM3E-geheugen, wordt ook pas in de tweede jaarhelft van dit jaar geleverd.

Het is onduidelijk wanneer Blackwell in grote volumes van de band zal rollen. Nvidia meldt aan The Register dat de B100, B200 en GB200 in de tweede jaarhelft wordt verscheept, maar zwijgt over het volume. Het lijkt ons daarom niet onrealistisch dat Blackwell pas vanaf 2025 in een hoog volume van de band zal rollen.

Hou ook rekening dat hyperscalers en gespecialiseerde organisaties zoals OpenAI en Meta in de rij zullen staan om tienduizenden fonkelnieuwe Blackwell GPU’s te bestellen voor hun systemen. Dat duwt de beschikbaarheid van de nieuwe chips mogelijk nog verder naar achter in 2025. Aan het tempo dat AI zich ontwikkelt vandaag, lijkt wachten niet de beste strategie.