AWS en Nvidia breiden hun samenwerking uit ter ere van re:Invent 2023. De nieuwste GPU’s van Nvidia komen als eerste naar de AWS-cloud, samen met onderliggende diensten voor het trainen van LLM’s.

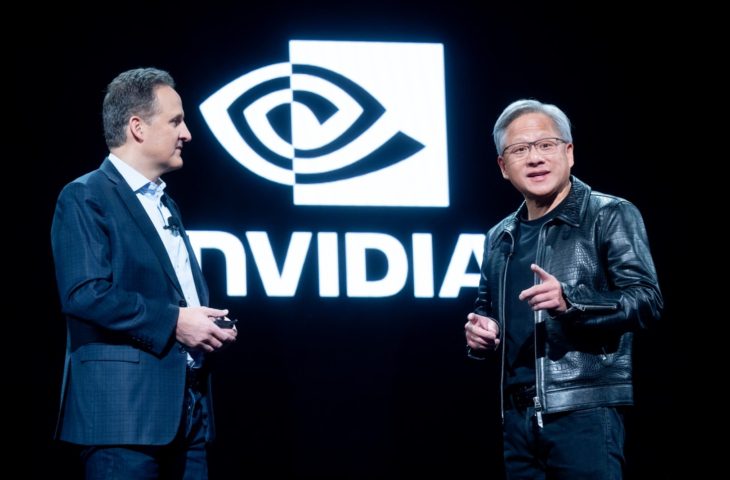

AWS zette zijn vriendschap met Nvidia in de verf tijdens re:Invent 2023 door Jensen Huang uit te nodigen, tegenwoordig een graag geziene gast op technologiebeurzen. De Nvidia-baas kwam hoogstpersoonlijk aankondigen dat AWS de primeur krijgt om zijn nieuwste GPU’s te mogen aanbieden via de cloud. Dat is de Nvidia L40S, maar ook de nieuwe blikvanger uit het GPU-portfolio GH200 Hopper.

Het is leuk om over de nieuwste en meest krachtige GPU’s te beschikken, maar dat is slechts een deel van AI-puzzel. Zonder een stevige infrastructuur kunnen die GPU’s nu eenmaal niet draaien. AWS gaat daarom ‘ultraclusters’ opzetten waar klanten tot duizenden Nvidia-GPU’s tegelijk kunnen schalen. Bedrijven kunnen daarmee hun eigen AI-supercomputers ontwikkelen. Welke proporties dit kan aannemen, tonen AWS en Nvidia zelf in ‘Project Ceiba’, een supercomputer die meer dan 16.000 GH200’s telt, goed voor 65 exaflops aan rekenkracht.

Microservice voor AI

Nu je supercomputer klaar is voor gebruik, is het tijd om je AI-modellen te gaan trainen. Ook hier vinden Nvidia en AWS elkaar. AWS voegt, als eerste der grote cloudproviders, Nvidia’s DGX Cloud-dienst om AI-modellen te trainen toe aan zijn ecosysteem. DGX Cloud biedt voldoende capaciteit om modellen tot een biljoen parameters onder te brengen. Daarbovenop komen nog nieuwe EC2-instances op maat van Nvidia-GPU’s.

lees ook

ChatGPT-concurrent Amazon Q algemeen beschikbaar

We hebben nu al een supercomputer en de benodigde capaciteit in huis. Het belangrijkste ingrediënt ontbreekt nog: data. AI-modellen hebben data nodig: kwaliteit is daarbij even belangrijk als kwantiteit. Je kan het al raden, ook hier hebben Nvidia en AWS wat op gevonden. Nvidia breidt zijn NeMo-platform uit met NeMo Retriever, een ‘AI-microservice’ binnen de AWS-cloud.

Deze microservice voegt een vleugje retrieval augmented generation (RAG) toe aan je nieuw ontworpen LLM. Dit is een technische term om aan te duiden dat de data die je gebruikt hebt afkomstig is van betrouwbare, externe bronnen. Volgens Huang is de combinatie van generatieve AI met RAG het perfecte recept om ‘killer apps’ te ontwikkelen. NeMo Retriever zal worden aangeboden via de applicatiemarktplaats van AWS.