Nvidia kondigde op de GTDC 2024 Nvidia NIM aan, waarmee ontwikkelaars eenvoudig AI-modellen kunnen implementeren in hun bedrijfsomgeving.

Nvidia lanceerde op GTC 2024 Nvidia NIM, een nieuw softwareplatform waarbij generatieve AI-modellen eenvoudiger in ontwikkelingsomgevingen geïmplementeerd kunnen worden. Het is ontworpen om de kloof te verkleinen tussen enerzijds de complexe wereld van AI-ontwikkelingen, anderzijds de operationele behoeften van bedrijfsomgevingen.

AI-containers

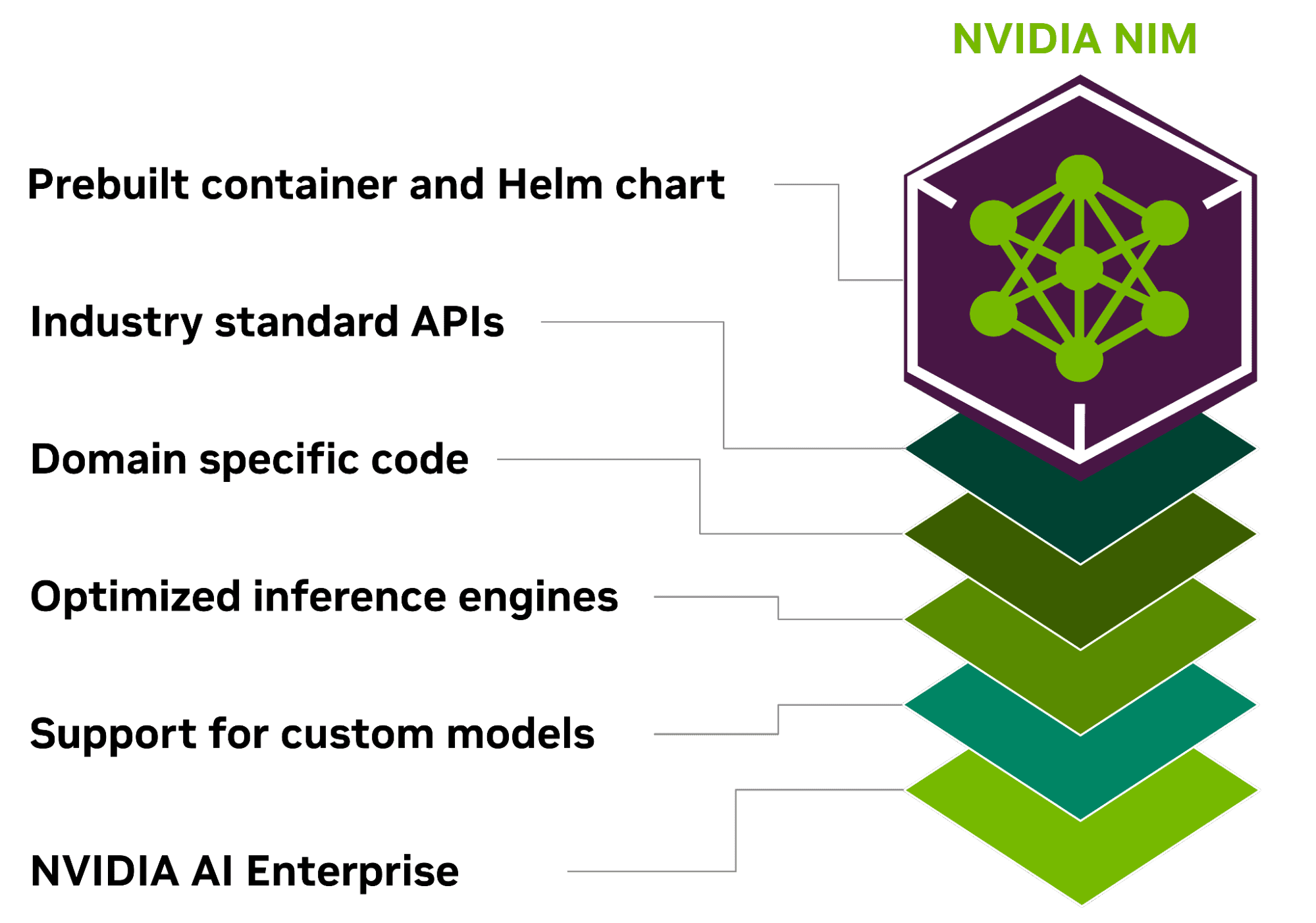

Nvidia omschrijft NIM als “een reeks geoptimaliseerde cloud-native microservices die zijn ontworpen om de time-to-market te verkorten en de implementatie van generatieve AI-modellen overal te vereenvoudigen, op cloud-, datacenter- en GPU-versnelde werkstations.”

NIM omvat het softwarewerk dat Nvidia gedaan heeft rond inferentie en optimalisatie van modellen. Vervolgens wordt die capaciteit toegankelijk gemaakt door een bepaald model te combineren met een geoptimaliseerde inferencing-engine. Die gaat vervolgens alles in een container verpakken waardoor het als microservice toegankelijk wordt.

Normaal zou het ontwikkelaars weken tot maanden kosten om soortgelijke containers te op te zetten, in het beste geval wanneer er AI-talent in het bedrijf aanwezig is. Met NIM biedt Nvidia kant-en-klare AI-containers waarin de hardware als fundamentele laag gebruikt wordt en de microservices als kernsofwarelaag toegevoegd worden.

Ondersteuning NIM

NIM ondersteunt diverse AI-modellen zoals communitymodellen, Nvidia AI Foundation-modellen en aangepaste modellen geleverd door Nvidia-partners, en dit voor gebruiksscenario’s in meerdere domeinen. Hieronder vallen grote taalmodellen, visuele taalmodellen, maar ook modellen voor spraak, afbeeldingen, video, 3D en veel meer.

lees ook

Nvidia dropt met Blackwell-GPU 1.200 watt-bom op de AI-wereld

Ontwikkelaars die de nieuwste generatieve AI-modellen willen testen, kunnen dat doen met behulp van door Nvidia beheerde cloud-API’s uit de Nvidia API-catalogus. Een andere optie is om de modellen zelf te hosten door NIM te downloaden en met Kubernetes te implementeren.