Generatieve AI is geboren in de cloud, maar of het daar volwassen zal worden, is lang niet zeker. On-prem vendoren zien hun kans om een graantje mee te pikken. Waar draait GenAI het best voor jouw bedrijf?

De GenAI-hype is inmiddels zijn tweede jaar ingegaan en het einde lijkt nog lang niet zicht. In 2024 zal generatieve AI van een experimenteel speeltje groeien tot een technologie die echte waarde biedt voor bedrijven. Daar zijn zowat alle spelers uit de techindustrie het toch unaniem over eens. 65 procent van de bedrijven is vandaag actief bezig met GenAI, concludeert McKinsey na een globale rondvraag.

Bedrijven bereiden zich volop voor om een tandje bij te steken met de integratie van GenAI in hun dagelijkse processen, maar er blijven barrières bestaan. Een van de vragen waar veel bedrijven nog geen pasklaar antwoord op hebben, is hoe ze de technologie gaan implementeren. Die ‘hoe’-vraag is evengoed een ‘waar’-vraag: waar zal GenAI draaien, on-prem of in de cloud?

Geboren in de cloud

GenAI is de volgende stap in de evolutie van artificiële intelligentie, die al meerdere decennia overstrijkt. Zogenaamde ‘klassieke AI’ is geprogrammeerd om in één specifieke taak goed te zijn, zoals het verwerken van grote datasets. Generatieve AI onderscheidt zich door zijn creatieve geest om op basis van een vraag in natuurlijke taal zelf content te produceren, van tekst tot beeld.

lees ook

Niet alle AI is generatief en gelukkig maar

Die veelzijdigheid van GenAI is mogelijk door de complexiteit van de achterliggende modellen. LLM’s zoals GPT-4 hebben terabytes aan data doorploegd om te leren patronen en structuren in ongestructureerde gegevens te vinden. Het vermogen van een model om dat te doen, wordt uitgedrukt in het aantal parameters, waarbij meer vaak beter is. GPT-3.5 telt bijvoorbeeld 350 miljoen parameters, de opvolger GPT-4 meer dan een miljard.

LLM’s worden groter en groter om betere output te produceren. Daar staat letterlijk een flinke prijs tegenover: het grootbrengen van LLM’s vereist stevige en dure middelen. De meest krachtige GPU’s van Nvidia kosten tienduizenden euro’s per stuk en datacenters moeten alsmaar uitbreiden om de groei van AI-modellen te ondersteunen, om over de energiefactuur nog maar te zwijgen.

Het prijskaartje van GenAI loopt zo makkelijk tot in de miljarden dollars op. Er zijn maar weinig bedrijven die de kosten kunnen of willen dragen. Het is geen toevallige evolutie dat de meest krachtige GenAI-toepassingen rechtstreeks of onrechtstreeks in handen zijn van de grote hyperscalers.

De wieg van GenAI staat dus in de publieke cloud. Via de cloud kunnen die grote, complexe modellen eenvoudig worden beschikbaar gesteld aan een groot publiek. Meer als een laptop of smartphone met internetverbinding heb je niet nodig om ChatGPT te gebruiken.

Datadilemma

Ondanks de eenvoudige toegang tot GenAI-hulpmiddelen, staat menig bedrijfsleider op de rem, stelt Boston Consulting Group vast. De vrees komt voornamelijk voort uit onbegrip over hoe de technologie werkt en waar AI zijn kennis vandaan haalt. Er wordt getwijfeld aan de kwaliteit van de output van AI-systemen.

Die bedenkingen zijn niet onterecht: GenAI maakt fouten, hoeveel parameters een model ook telt. Zogenaamde ‘hallucinaties’ zijn vaak het gevolg van fouten of vertekeningen in de trainingsdata, waardoor het LLM tot antwoorden komt die inaccuraat tot zelfs totale onzin zijn. Dit wordt problematisch als gebruikers alles wat GenAI hen zegt of toont voor waar aannemen.

lees ook

Hoe fouten opsporen in LLM’s? Nog een LLM gebruiken

De polyvalentie van GenAI-systemen is een sterkte, maar in specifieke gebruikssituaties heb je soms net gerichte kennis nodig. Een LLM is dan niet altijd de beste oplossing. Veel modellen kunnen daarom gefinetuned worden om de output beter te focussen op bepaalde use cases.

Daar wringt dan weer aan ander schoentje: modellen finetunen vereist het delen van data met de modellen. Bedrijfsleiders zijn er niet altijd happig op om interne bedrijfsdata naar de cloud te sturen, zeker als modellen die data herproduceren naar andere gebruikers. Met een betaald abonnement kan je dat (grotendeels) oplossen, maar zou het niet handiger zijn als het AI-model bij jouw bedrijf over de vloer komt en daar blijft?

Verhuizen naar on-prem

Het datadilemma rond GenAI biedt kansen voor bedrijven die on-prem IT nog wél liefde willen geven. Bedrijven zoals Dell, Nutanix en HPE ontwikkelden oplossingen om GenAI-modellen op een ‘cloud-achtige manier’ op on-prem infrastructuur te draaien, met Nvidia die overal wel ergens met een (dikke) neus tussen zit. Dergelijke oplossingen vereisen vaak de aanschaf van servers met één of meerdere Nvidia-GPU’s.

Waarom GenAI zich ook thuis zou voelen in een on-prem omgeving, legt Han Tan, COO Hybrid Cloud bij HPE, ons uit tijdens HPE Discover. “Het is een misvatting dat AI in de publieke cloud moet zitten. Als je eenmaal de modellen uitvoert, moet je ze finetunen met de eigen data en die zitten bij veel organisaties on-prem. AI zal uiteindelijk naar de data moeten toekomen.”

Fujitsu lanceerde recent met Private GPT een GenAI-tool die bestemd is voor on-prem. Tijdens een live demo haalt Chief Data Officer Udo Würtz ook het data-argument als belangrijkste reden aan om GenAI zoveel mogelijk on-prem te houden. “AI biedt een geweldige opportuniteit om kennis te delen binnen de organisatie, maar dan moet die wel binnen de organisatie blijven. Private GPT beschermt je intellectuele eigendom doordat data het datacenter niet verlaten.”

lees ook

Geen vertrouwen in AI zonder betrouwbare data: de AI-strategie van Fujitsu onder de loep

Testrit

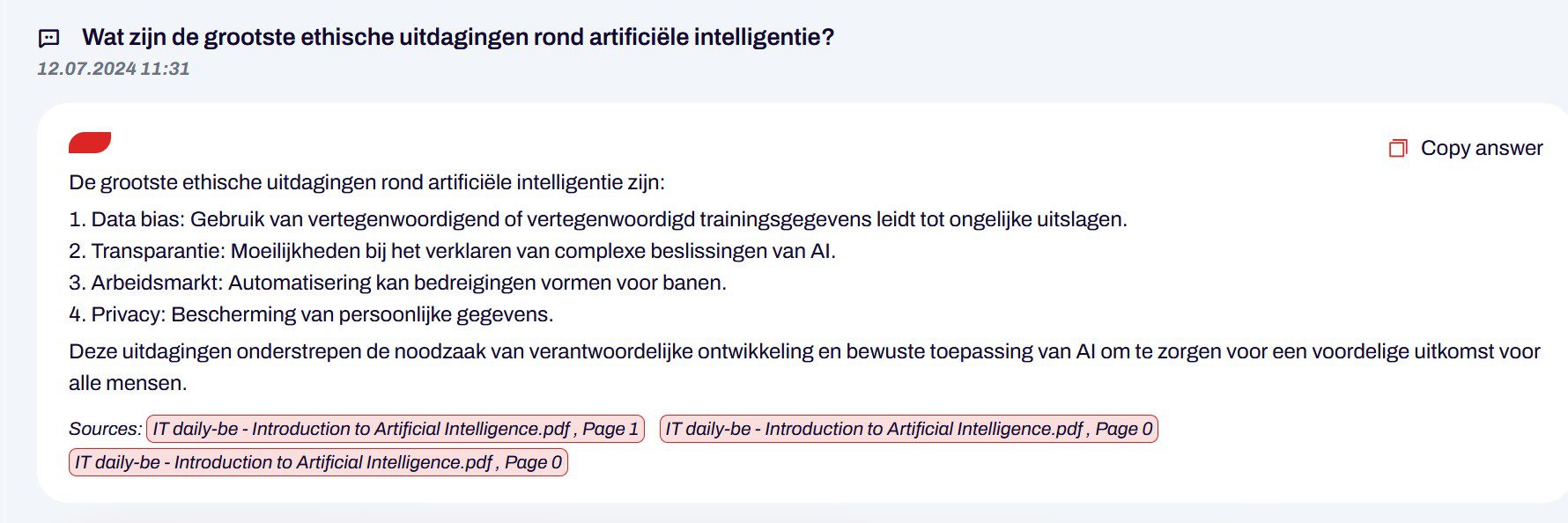

Bedrijven kunnen bij Fujitsu een ‘testrit’ van Private GPT aanvragen. Würtz neemt ons mee op zo’n testrit. In de Private GPT-oplossing verzorgt Fujitsu de software- en applicatielaag, die vervolgens wordt geïnstalleerd op de infrastructuur van de klant.

Er is natuurlijk ook een model nodig: hiervoor is de keuze gevallen op het opensourcemodel Mixtral 8x7B, ontwikkeld en getraind door Mistral. “Het bijzondere aan dit model is dat het uit acht ‘experten’ bestaat. Voor jouw specifieke vraag duidt het model twee ‘experten’ aan en combineert het de output om tot het beste antwoord te komen”, verklaart Würtz de keuze.

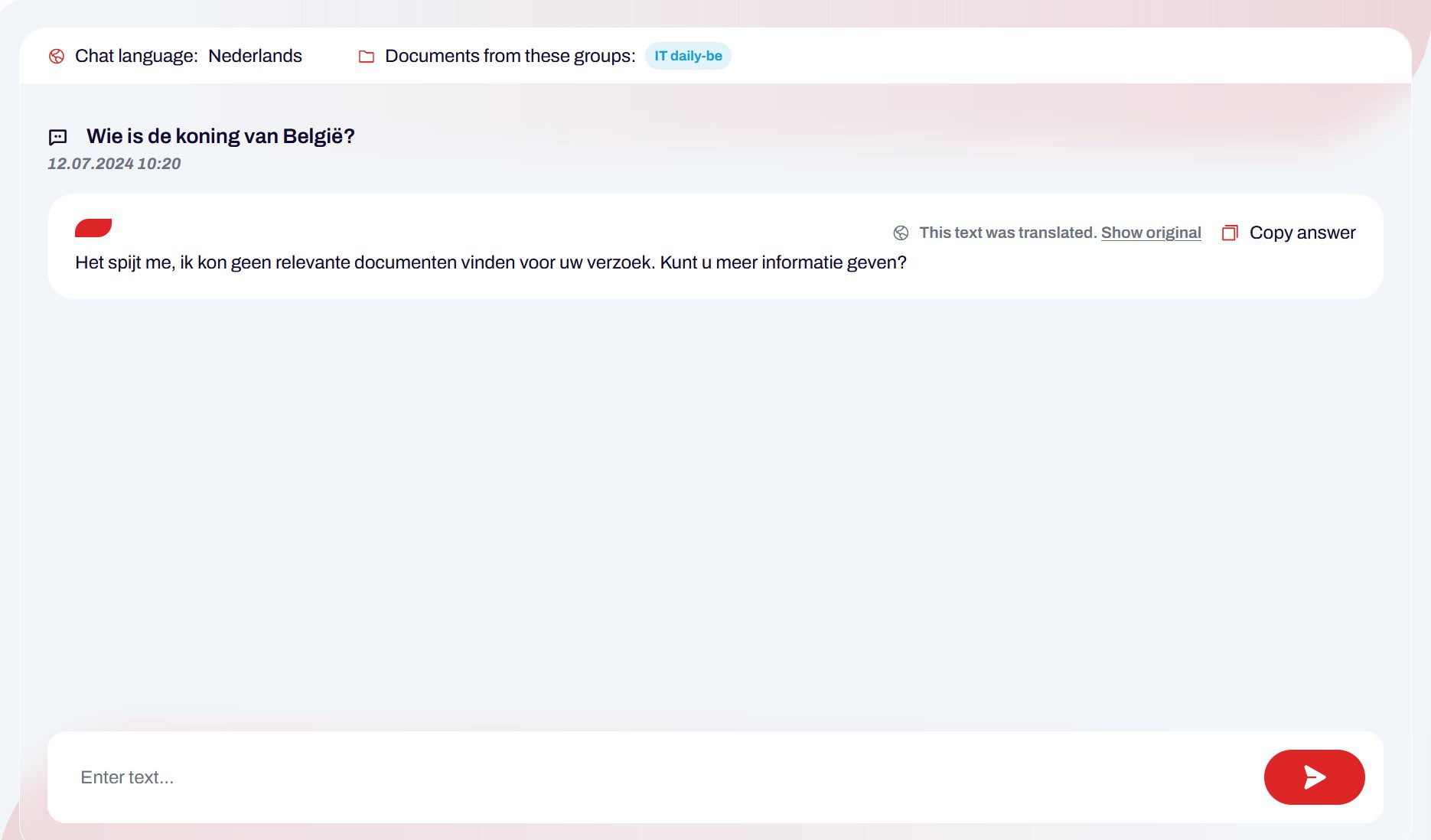

De interface van Private GPT wijkt niet ver af van publieke GenAI-chatbots zoals ChatGPT. Private GPT kan enkel informatie halen uit documenten die je met het model deelt. Ieder document kan nog worden toegewezen aan een bepaalde gebruikersgroep, voor als je bestanden binnen een team wilt houden. Chatten kan in verschillende talen, waaronder het Nederlands, en het model wisselt ook moeiteloos tussen talen.

Ben je op zoek naar antwoorden op algemene kennisvragen, dan ben je bij Private GPT niet aan het juiste adres. Het model hangt niet rechtstreeks aan het internet en kan dus geen bijkomende informatie voor je opzoeken. Private GPT kent zijn beperkingen en geeft eerlijk toe wanneer het een vraag niet kan beantwoorden, om hallucinaties te vermijden. De applicatie is bedoeld voor de analyse van interne documenten in een gecontroleerde omgeving.

On-prem of in de cloud?

Zowel on-prem als cloudgebaseerde AI hebben hun voordelen en beperkingen. Voor sensitieve data klinkt on-prem als de geprefereerde oplossing. De cloud biedt dan weer een uitweg voor bedrijven die niet over de benodigde rekenkracht beschikken om complexe AI-modellen te huisvesten. Wat de beste optie voor jouw bedrijf is, zal afhangen van de beschikbare middelen en waar je de technologie voor wilt inzetten.

AI biedt een geweldige opportuniteit om kennis te delen binnen de organisatie, maar die kennis moet wel binnen de organisatie blijven.

Udo Würtz, CDO Fujitsu