Na jaren van blabla is het tijd voor boemboem: Nvidia’s Grace Hopper-‘superchip’ rolt eindelijk in grote volumes van de band. De chip is een belangrijk onderdeel van Nvidia’s strategie in de toekomst.

In de lente van 2021 stelde Nvidia tijdens de GPU Technology Conference de Grace-chip voor: een zelfgebouwde ARM-processor op maat van het datacenter. Al snel werd duidelijk dat Grace niet bedoeld was om exclusief op zichzelf te staan. De hoofdmissie van de CPU is om samen met een Nvidia-GPU op één ‘superchip’ te leven. Een snelle verbinding tussen GPU en CPU en gedeeld geheugen moet zo’n chip uitermate geschikt maken voor AI-workloads. Al meer dan een jaar praat Nvidia met veel enthousiasme over die Grace Hopper-superchip.

Specificaties

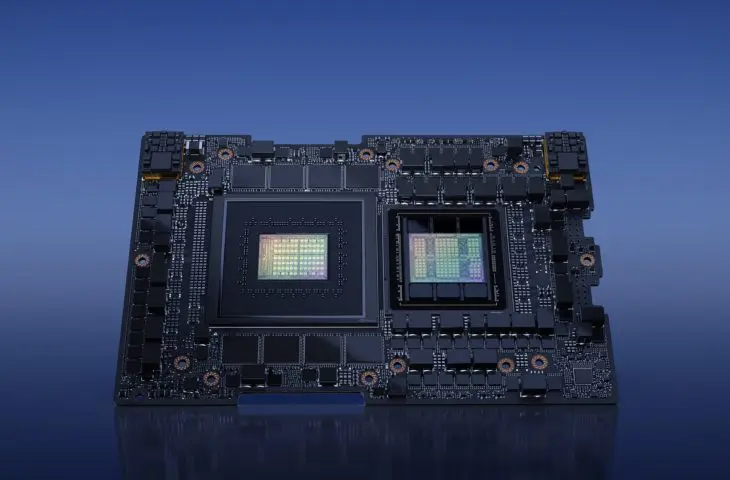

Nu is het concept ook werkelijkheid geworden. Nvidia bevestigt dat Grace Hopper in volume van de band rolt. De chip combineert de ARM-gebaseerde Grace-CPU met de Hopper-GPU-architectuur die ook de krachtige H100-accelerator ondersteunt. Het resultaat is een in theorie extreem krachtige System-on-a-Chip (SoC). Grace Hopper heeft volgende specificaties:

- 72 Arm Neoverse V2 CPU-kernen

- 528 GPU Tensor-kernen (Hopper)

- 132 GPU streaming multiprocessors (Hopper)

- 900 GB/sec NVLink 4 CPU-GPU-interconnect

- Tot 96 GB GB HBM3-geheugen

- 4TB/sec GPU-geheugenbandbreedte

- Tot 480 GB LPDDR5X ECC-geheugen

- 512 GB/sec CPU-geheugenbandbreedte

- TDP van 450 watt tot 1.000 watt

Nvidia laat nog weten dat het vertrouwt op TSMC’s 4 nm-proces om de chip te bouwen. Bovenstaande specificaties gelden voor de huidige maximale configuratie, die slechts in beperkte oplage van de band rolt. Het gros van de chips moet het met een nog steeds straffe 80 GB HBM3-geheugen stellen.

Het geheugen voor de CPU komt niet van klassieke DIMM’s, maar zit mee op de superchip. Dat laat een hogere kloksnelheid en een lager verbruik toe, al boet je natuurlijk in op het vlak van flexibiliteit. Het hoge TDP valt op, maar is moeilijk te vergelijken met het TDP van een klassieke CPU of GPU. De superchip, die Nvidia GH200 doopt, omvat immers bijna het hele computersysteem.

Supercomputer

De GH200 zal later dit jaar ook effectief beschikbaar zijn. In afwachting kondigt Nvidia alvast een nieuw eigen DGX-systeem aan. De DGX GH200 AI Supercomputer is geen doetje, en bestaat meteen uit 24 racks. Daarin passen zo’n 256 GH200-chips. Nvidia voorspelt een FP8-rekenkracht van ongeveer een exaflops. Het ding is in alle betekenissen van het woord een volwaardige supercomputer. Let wel: dit is geen exascale-computer, aangezien HPC-systemen in de Top 500 gemeten worden op basis van een FP64-benchmark.

De superchips in de DGX-supercomputer krijgen de volle 96 GB aan HBM3-geheugen mee en zullen de beste exemplaren zijn die van de TSMC-productieband rollen. De GH200 als onderdeel van andere servers zal in de regel met de 80 GB aan HBM3 komen. Nvidia lijkt een HBM-cluster uit te schakelen op die exemplaren, vermoedelijk om de yield te verhogen. De supercomputer is vanaf het einde van dit jaar beschikbaar, al betwijfelen we dat ons land veel bedrijven of instanties telt die onder de niche van verwachtte klanten vallen. ‘Klassiekere’ GH200-servers zullen door andere fabrikanten zoals Asus en Gigabyte gebouwd worden.

Concurrentie

Met de Grace Hopper-superchip geeft Nvidia het startschot voor een nieuwe hardware-race. AMD plant binnenkort een gelijkaardige chip te lanceren, gebaseerd op de eigen Zen 4-CPU’s en CDNA3-GPU-architectuur. Die superchip krijgt de naam AMD Instinct MI300. Bij TSMC zien ze dat graag gebeuren, want de fabrikant zal ook die computerchips bakken.

Intel van zijn kant heeft even gedacht dat het mee aan de startlijn wilde verschijnen met een Falcon Shores-XPU, maar heeft intussen al preventief opgegeven. Als Nvidia en AMD gelijk hebben, worden de superchips echter belangrijke componenten om de explosie aan AI-training en inferentie te ondersteunen.