Het CERN onderzoekt samen met IBM de impact van kwantumcomputers op de verwerking van data afkomstig van de LHC. De eerste resultaten zijn veelbelovend en wijzen op een weg naar kwantumsuprematie.

Onderzoek naar kwantumcomputers vordert langzaam maar zeker. Toch blijft kwantumsuprematie, waarbij een kwantumcomputer onbetwistbaar een bepaalde opdracht sneller uitvoert dan een traditionele computer, vooralsnog buiten bereik. We weten al wel dat kwantumcomputers zich in theorie heel erg goed zullen kwijten van bepaalde workloads, maar niet noodzakelijk geschikt zijn voor andere. Windows of Linux draai je bijvoorbeeld liefst op een traditionele processor. Waar zijn kwantumcomputers en hun qubits dan wel goed voor?

Large Hadron Collider

Een mogelijk antwoord op die vraag vinden we 175 meter onder de grond nabij Genève. Daar genereren de experimenten in de Large Hardon Collider (LHC) van het CERN ongeveer één petabyte aan data per seconde. Dat volume aan gegevens wordt verwerkt op 170 locaties over de hele wereld, waar bijna een miljoen rekenkernen filteren en analyseren. Dicht bij huis houdt het Nederlandse onderzoeksinstituut Nikhef zich daarmee bezig.

We ontdekten eerder al dat de analyse van LHC-data een stiel apart is. Traditionele supercomputers kunnen niet overweg met al de gegevens: een speciale datagerichte architectuur is noodzakelijk. Dan nog is het een waanzinnig werk om inzichten te halen uit alle data die de LHC genereert.

lees ook

Waarom een supercomputer stuk zou gaan bij het onderzoek van Nikhef

Eén van de voornaamste doelen van ’s werelds grootste machine is onderzoek naar het Higgs boson: een elementair deeltje dat massa geeft aan alle andere deeltjes. Dat voorspelde deeltje werd in 2012 eindelijk ontdekt. Peter Higgs en de Belgische François Englert kregen er de Nobelprijs voor, maar daarmee is de kous niet af. De studie van het nieuw waargenomen deeltje moet nog beginnen.

Het kaf van het koren scheiden

De LHC accelereert deeltjes (protonen) naar bijna de lichtsnelheid, om ze daarna tegen elkaar te laten botsen en te zien wat er uit komt. Niet alle botsingen zijn even succesvol en genereren even interessante data, maar het is niet eenvoudig om boeiende events van saaie te onderscheiden. Om het Higgs boson verder te bestuderen, moeten onderzoekers weten bij welke botsingen het deeltje verschijnt.

Vandaag is dat de job van krachtige computers. Zij analyseren de data op zoek naar verbanden in verschillende dimensies. Dimensies zijn hierbij eigenschappen gekoppeld aan deeltjes. Een voorbeeld verduidelijkt deze stelling. Stel je een vlak voor met daarop rode en groene stippen. Staan alle rode stippen links en alle groene rechts, dan kan je een interessante lijn doorheen het midden trekken. Die zegt ongetwijfeld iets over de eigenschappen van de rode en groene stippen en is een goed begin voor verder onderzoek.

Stippen, lijnen en dimensies

Stel je nu voor dat alle stippen door elkaar staan. Een lijn trekken is niet meer mogelijk. De stippen leven chaotisch door elkaar en lijken niet onderhevig aan één of andere onontdekte wetmatigheid die het onderzoeken waard is. Wat nu als we een derde dimensie toevoegen aan ons onderzoek. Op de X- en de Y-as staan de stippen misschien door elkaar, maar wat met de Z-as? Als alle rode stippen bovenaan blijken te plakken en alle groene onderaan, ontdek je opnieuw een interessante lijn. Die had je nooit gevonden wanneer je beperkt was tot de eerste twee dimensies.

Voor onderzoek naar LHC-data is niet alleen ruimtelijke data belangrijk. Tal van factoren of dimensies kunnen verbanden tussen partikels naar boven brengen. Hoe meer je er gelijktijdig onderzoekt, hoe warmer een traditionele computer het krijgt. De bits en bytes beginnen te zweten en resultaten blijven uit.

Bredere feature space en QSVM

De qubits in een kwantumcomputer kunnen veel meer zijn dan 0 en 1 alleen. Zij bevatten zo veel meer informatie, waardoor wel mogelijk is om extra onderzoeksdimensies toe te voegen. De hoeveelheid dimensies of factoren waarop een algoritme data zal onderzoeken, heet de feature space. Een kwantumcomputer kan overweg met een veel grotere feature space dan een traditioneel systeem. Het CERN werd lid van de IBM Quantum Hub om die mogelijkheden te onderzoeken. In theorie zorgt een grotere feature space er immers voor dat het eenvoudiger is om interessante botsingen met bijvoorbeeld het Higgs boson te detecteren, maar ook om relevante verbanden tussen deeltjes te vinden.

De qubits in een kwantumcomputer kunnen veel meer zijn dan 0 en 1 alleen.

Vandaag bestaan er al algoritmes gebouwd om patronen te herkennen met de hulp van kwantumcomputers. Eén dergelijk algoritme heet quantum support vector machine of QSVM voor de vrienden. QSVM is niet geoptimaliseerd om overweg te kunnen met data van het CERN, maar leek volgens onderzoekers wel toepasbaar.

Eerst simuleerden onderzoekers van het CERN en IBM het QSVM-algoritme via Google Tensorflow Quantum, IBM Quantum en Amazon Bracket. Simulaties met tot 20 virtuele qubits en 50.000 events leverden boeiende resultaten op: ze presteerden minstens even goed dan de zwaar geoptimaliseerde algoritmes die het CERN zelf gebruikt in de analyse van zijn LHC-data.

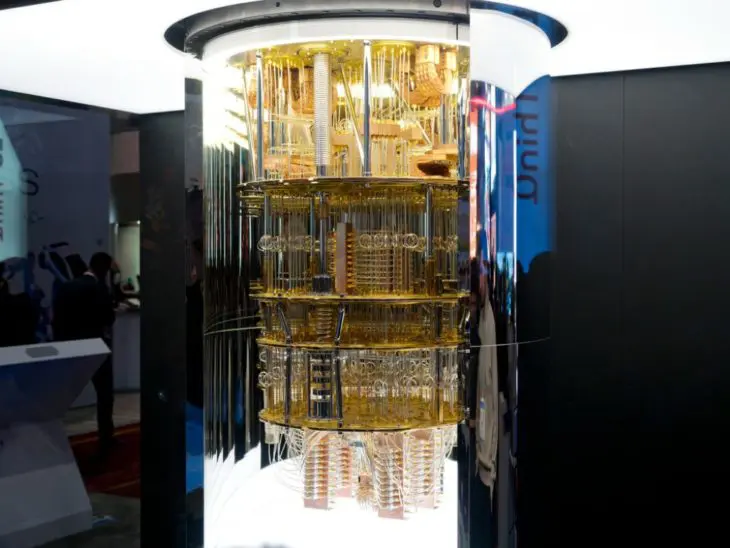

Voor de echte test haalde IBM een 27 qubit tellende Falcon-processor van eigen makelij boven. Dat is de CPU die Big Blue gebruikt in zijn IBM Quantum System One-hardware. Daarvan gebruikten ze 15 qubits om de data te analyseren. De resultaten volgden de simulatie: het QSVM-algoritme op een echte 15 qubit-kwantumcomputer presteerde even goed tot beter dan de gespecialiseerde CERN-software op een supercomputer.

Suprematie?

De resultaten suggereren dat kwantumcomputers exact zijn wat het CERN nodig heeft om het alsmaar toenemende datavolume te analyseren. Jaar na jaar en upgrade na upgrade worden de experimenten immers complexer en gedetailleerder. De kwantumcomputer kan veel meer parameters van data tegelijkertijd bevatten vergeleken met een systeem gebaseerd op 0 en 1, en vindt zo efficiënter nieuwe verbanden. Toch mogen we nog niet van kwantumsuprematie spreken.

lees ook

Kwantumcomputers: verre droom of actueel gevaar?

Het QSVM-algoritme op een kwantumcomputer kan de algoritmes en systemen van het CERN evenaren, maar daarmee tonen de huidige systemen zich niet krachtiger dan traditionele computers. Het is immers perfect mogelijk om meer rekenkracht naar het CERN te smijten en superioriteit van x86-hardware te garanderen. De uitkomst van het experiment toont aan dat kwantumcomputers goed zijn in dit type probleem maar vooralsnog zijn ze niet beter dan gewone systemen. Een supercomputer kan je bovendien vandaag bestellen, installeren en in gebruik nemen zonder al te veel gedoe. Een kwantumcomputer blijft in contrast een experimenteel toestel waarvoor experts nog toepassingen en software moeten uitvinden.

Pad naar de toekomst

De data suggereren wel een pad naar de felbegeerde kwantumsuprematie. Kwantumcomputers vandaag zijn nog redelijk slordig, met een relatief grote foutmarge (noise of ruis) op de prestaties van de qubits. Bovendien is het erg moeilijk om qubits in leven te houden. De hoeveelheid qubits in een gegeven systeem verbetert de kracht ervan, maar ook de complexiteit. Onderzoekers hebben met andere woorden hun handen vol met onderzoek naar significant krachtigere kwantumcomputers, al lijkt iedereen er zeker van dat die voor de deur staan.

Een meer geavanceerd systeem met meer qubits en minder ruis zal naar alle waarschijnlijkheid wel beter presteren. Bovendien is er nog ruimte om het QSVM-algoritme te optimaliseren voor de analyse van experimentele data en onderzoek naar het Higgs boson.

Het hele experiment toont aan waar kwantumcomputers morgen een plaats zullen hebben. Europa bouwt momenteel geen eigen systemen en is afhankelijk van hardware van IBM voor zijn kwantum-onderzoek. Pas verwelkomde de EU nog zijn eerste kwantumcomputer op eigen boden met de installatie van een IBM Q System One bij de Fraunhofer-Gesellschaft in Duitsland.