De krachtigste producten, de scherpste prijs en de beste achterliggende technologie: AMD toont met voldoende redenen aan waarom het een grote speler in de CPU- en AI-markt is. Aan aankondigingen is er in San Francisco evenmin een gebrek. Zal de ambitie haar vruchten afwerpen?

We verdrinken haast in de kernen en het HMB3-geheugen op de Datacenter- en AI-technologie-première in San Francisco in de VS. CEO Lisa Su commandeert de spotlights terwijl ze hoogstpersoonlijk AMD’s ambitie voor de toekomst aan de verzamelde internationale pers uit de doeken doet. “Vandaag is een belangrijke dag voor ons, waarop we een grote stap zetten om AMD de voorkeurspartner te maken voor datacenter en AI.” Het bedrijf is hongerig, en ziet geen enkele reden waarom het niet bovenaan de voedselketen mag staan met zijn CPU’s én GPU’s.

Oorlog op alle fronten

Dat is eenvoudiger gezegd dan gedaan. Waar Intel-CEO Pat Gelsinger divisies links en rechts sluit in een poging het bedrijf opnieuw gefocust te krijgen op zijn core-business (pun), kiest AMD in San Francisco voor de totale oorlog. Su en haar kompanen dingen naar leiderschap met CPU’s, GPU’s, FPGA’s én DPU’s. Kan het rekenen en bevat het een microtransistor, dan is het de ambitie van AMD om de beste variant op de markt te hebben.

De definitie van ‘beste’ is best subjectief, maar bij AMD zien we een duidelijke lijn. Hoewel de fabrikant steevast uitpakt met torenhoge prestaties voor alle nieuwe componenten is het eigenlijk de total cost of ownership (TCO) voor de klant die centraal staat. AMD wil zoveel mogelijk pk’s in de handen van klanten duwen en dat aan een zo scherp mogelijke prijs en met een zo laag mogelijk energieverbruik.

Bergamo

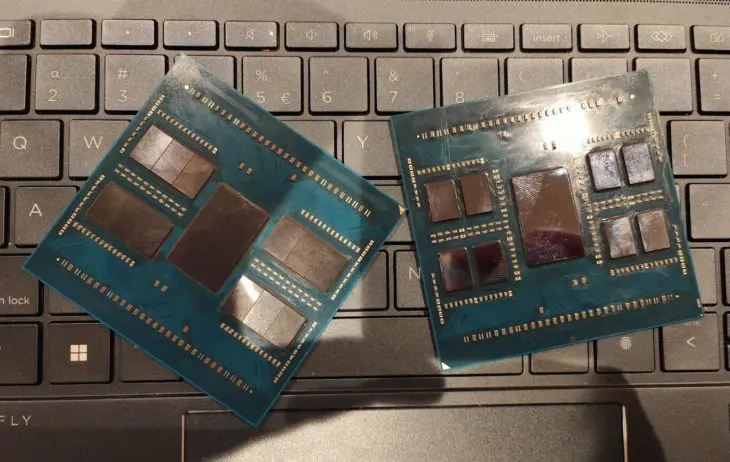

Daartoe heeft de fabrikant een niet zo geheim wapen: chiplets. Su verwijst tijdens haar presentatie meermaals naar het belang van de chiplettechnologie in de snelle uitbouw van AMD’s portfolio. De aankondigingen op de première zijn haast allemaal te danken aan chiplets als kernfilosofie binnen het design.

lees ook

AMD lanceert Bergamo: 128 cloud native Zen 4c-kernen als concurrent voor ARM

Zo toont AMD zijn eerste datacenter-GPU’s speciaal gebouwd voor cloud native-workloads: Epyc Bergamo. Bergamo gebruikt een variant van de Zen 4-kernen in de algemene Epyc-processors van de vierde generatie: Zen 4c. Zen-architect Mike Clark hamert er echter op dat Bergamo met Zen 4c nauwelijks verschilt van Genoa met Zen 4.

De kracht van de chiplet

“We hebben beschikbare cache per kern en de klokfrequentie voor Zen 4c verminderd, zodat de kern zelf kleiner wordt”, zegt hij. “Daardoor passen er dubbel zo veel kernen op een CCD (Core Chiplet Die).” Voor Bergamo neemt AMD een Genoa-chip en vervangt het de Zen 4-CCD’s door Zen 4c-CCD’s. Al de rest, inclusief het I/O-deel, blijft hetzelfde waardoor platform-compatibiliteit behouden blijft. En wat misschien nog belangrijker is: de R&D-kost bleef relatief beperkt voor AMD.

Wij hebben geen volledig nieuwe architectuur nodig om een zuinige kern te maken.

Mike Clark, Zen-architect

“Wij hebben geen volledig nieuwe architectuur nodig om een zuinige kern te maken”, lacht Clark. Op het podium kan Su intussen uitpakken met mooie benchmarkcijfers waarin Bergamo niet enkel de equivalente chips van Intel aftroeft, maar ook de cloud native Altra-CPU van Ampere, gebouwd op ARM.

lees ook

AMD toont Epyc Genoa-X: zelfde chip, meer cache

Terloops verschijnt Dan McNamara, SVP van AMD’s Server Business Unit, even op het hoofdpodium om Genoa-X te lanceren. Die variant van Epyc heeft tot 1,1 GB aan cache aan boord, maar verschilt opnieuw niet fundamenteel van Epyc Genoa. De cache werd vervangen door de tweede generatie van AMD’s 3D V-Cache, maar daar was het raamwerk voor de modulaire Epyc-chip van het begin af aan op voorzien. Ingenieurs konden de cache-component gewoon vervangen et voilà: een nieuwe chip voor nieuwe workloads.

Meer dan één MI300

Op naar AI-land dan. “AI is de grote megatrend van dit tijdperk”, veronderstelt Su. De honger naar rekenkracht voor AI-training en inferentie is in ieder geval groter dan AMD niet zo lang geleden had voorspeld toen het de Instinct MI300 voorstelde. Die chip zou een APU zijn waarop GPU en CPU tot een geheel worden gecombineerd.

Vandaag heet dat ding MI300A, en volstaat de accelerator-kracht ervan niet voor de zwaarste taken. De oplossing was niet zo complex volgens Brad McCredie, VP van Datacenter en Accelerated Processing. “Het was best eenvoudig om de MI300X te maken. De optie zat altijd al in ons achterhoofd. We hebben de Zen 4-kernen uit de Instinct MI300A verwijderd en extra CDNA 3-kernen in de plaats gestopt.”

lees ook

AMD opent vuur op Nvidia H100 met Instinct MI300X: 192 GB HBM3 op één chip

Dankzij de chiplet-aanpak had AMD zo in geen tijd een klassieke AI-accelerator klaar. Vervolgens stopte de chipdesigner 192 GB aan HBM 3 mee op de chip met. Su glundert wanneer ze toont wat dat betekent tijdens een demo. “Het hele Falcon-40B-AI-model past in het geheugen van de chip, zodat één Instinct MI300X volstaat voor inferentie.”

Goed genoeg voor Frontier

Krachtige chips blijven natuurlijk waardeloos wanneer niemand ze omarmt. Dat beseft AMD ook. Su en kompanen nemen daarom uitgebreid de tijd om te hameren op de volwassen software-omkadering. De ROCm-software van AMD is intussen aan versie vijf toe, en als het goed genoeg is voor de exascale-supercomputer Frontier, is het misschien ook goed genoeg voor jou, klinkt het tussen de lijnen door.

AMD gaat resoluut voor samenwerkingen met de opensource-wereld in zijn AI-software-aanbod en probeert zich zo te onderscheiden van Nvidia. Clement Delangue, CEO van Hugging Face, tekent present om het belang daarvan in de verf te zetten. “Hugging Face is een beetje de GitHub voor open AI-modellen”, vertelt hij. “We werken voortaan samen met AMD om ervoor te zorgen dat de modellen op Hugging Face ook naadloos werken op AMD-hardware.”

AI in de laptop

Integratie met de opensource-wereld moet AMD’s accelerator-hardware interessant maken voor een groter publiek. Daar is wel werk aan de winkel, aangezien Nvidia de markt domineert met een aandeel van om en bij de 80 procent.

Wat Nvidia niet heeft, zijn computerchips voor laptops. AMD heeft die met Ryzen en Ryzen Pro wel en neemt de vlucht vooruit om er een Ryzen AI Engine in te stoppen. Dat is een chiplet die dient doet als ingebouwde NPU (Neural Processing Unit) en zo AI op de laptop kan accelereren. Aan de eerste implementaties daarvan wordt momenteel gesleuteld.

lees ook

AMD stelt Ryzen Pro 7040 Mobile voor: ingebouwde AI voor enterprise-laptops

De architectuur van de NPU is niet toevallig gelijkaardig aan die van de Instinct MI300-reeks. Chiplets en eenheid van architectuur moeten de markt verleiden. “De engine zal ons toelaten sneller te innoveren”, zegt David McAfee van de Ryzen Product Group. “We hanteren dezelfde AI-architectuur van endpoint tot de cloud.”

Programmeerbare DPU

Op naar de DPU dan. Daarover heeft AMD in San Francisco minder te zeggen, al krijgt AMD Pensando wel zijn moment in de spotlights. Pensando is een acquisitie van AMD, waarmee de chipdesigner zich in één klap inkocht aan de bovenkant van de DPU-markt.

Tal van grote klanten passeren over het podium voor een lofzang over Pensando. De programmeerbaarheid van de DPU’s maakt nieuwe manieren van beveiliging mogelijk en is eigenhandig verantwoordelijk voor miljoenenbesparingen, klinkt het.

lees ook

AMD toont volgende generatie Pensando-DPU’s en omarmt ontwikkelaars

AMD houdt er zelf een voorspelbare klokfrequentie op na. Het bedrijf brengt zijn innovaties consequent volgens zijn voorgestelde roadmap naar de markt. Het geavanceerde chiplet-design speelt daarin een belangrijke rol.

Topcomponenten over de hele lijn

Het resultaat mag er zijn. Langs de CPU-kant is er Epyc. Epyc Genoa is de krachtigste processor voor algemene workloads, Genoa-X ondersteunt technische workloads en Bergamo omarmt cloud native.

Voor AI hebben we dan de Instinct MI300A-APU en de MI300X-accelerator, gekoppeld aan een open ecosysteem van software. De Ryzen AI-engine brengt de AI-architectuur van cloud naar endpoint: een eenheid die geen enkele andere partij op dit moment kan evenaren.

Ook het netwerk is AMD niet uit het oog verloren. AMD Pensando combineert DPU en ASIC tot een geheel dat beveiligings- en virtualisatieworkloads kan overnemen van server-CPU’s. Met de Giglio-architectuur staat de opvolger al aan de deur te wachten, maar Giglio-DPU’s zullen geen compatibiliteitsproblemen met zich meebrengen ten opzichte van bestaande Pensando-DPU’s.

Zelfvertrouwen in de benchmarks

AMD’s topgeneraals lanceren benchmarkslide na benchmarkslide om de superioriteit van al hun hardware tegenover de equivalenten van Intel en Nvidia in de verf te zetten, maar het zijn niet de hoge prestaties die op termijn de markt moeten veroveren. Naast chiplets komt nog een ander woord de hele tijd terug: TCO. Al AMD’s componenten bieden doorgaans de beste prestaties voor hun geld en doorgaans ook per watt. “We hebben een TCO-voordeel”, benadrukt McCredie. “En al zeker wat inferentie per dollar betreft.”

We hebben een TCO voordeel, zeker wat inferentie per dollar betreft.

Brad McCredie, VP Datacenter en Accelerated Processing

In San Francisco voelen we het resultaat. AMD barst van het zelfvertrouwen. Alle producten staan klaar om klanten te bedienen over het hele spectrum en wie intekent krijgt hoge prestaties voor een lage(re) totale kost over de levensduur van een component. Het marktaandeel dikt niet verwonderlijk aan, al eet AMD nog steeds veel minder taart dan Intel of Nvidia.

Volgen de klanten?

Misschien verdient AMD het nu al om tot processorkoning en AI-keizer gekroond te worden, maar zo ver is het nog lang niet. Op dit moment vertelt CEO Lisa Su een beklijvend verhaal. Steeds meer servers en instances met AMD aan de binnenkant verschijnen op het strijdtoneel en de opmars zal niet meteen stoppen. Toch is de Datacenter- en AI-technologie-première in San Francisco het event van een underdog, hoe onterecht dat ook mag zijn.