Nvidia CEO Jensen Huang vindt dat we meer datacenters moeten bouwen op locaties die vandaag nog niet worden benut, om AI-modellen te trainen.

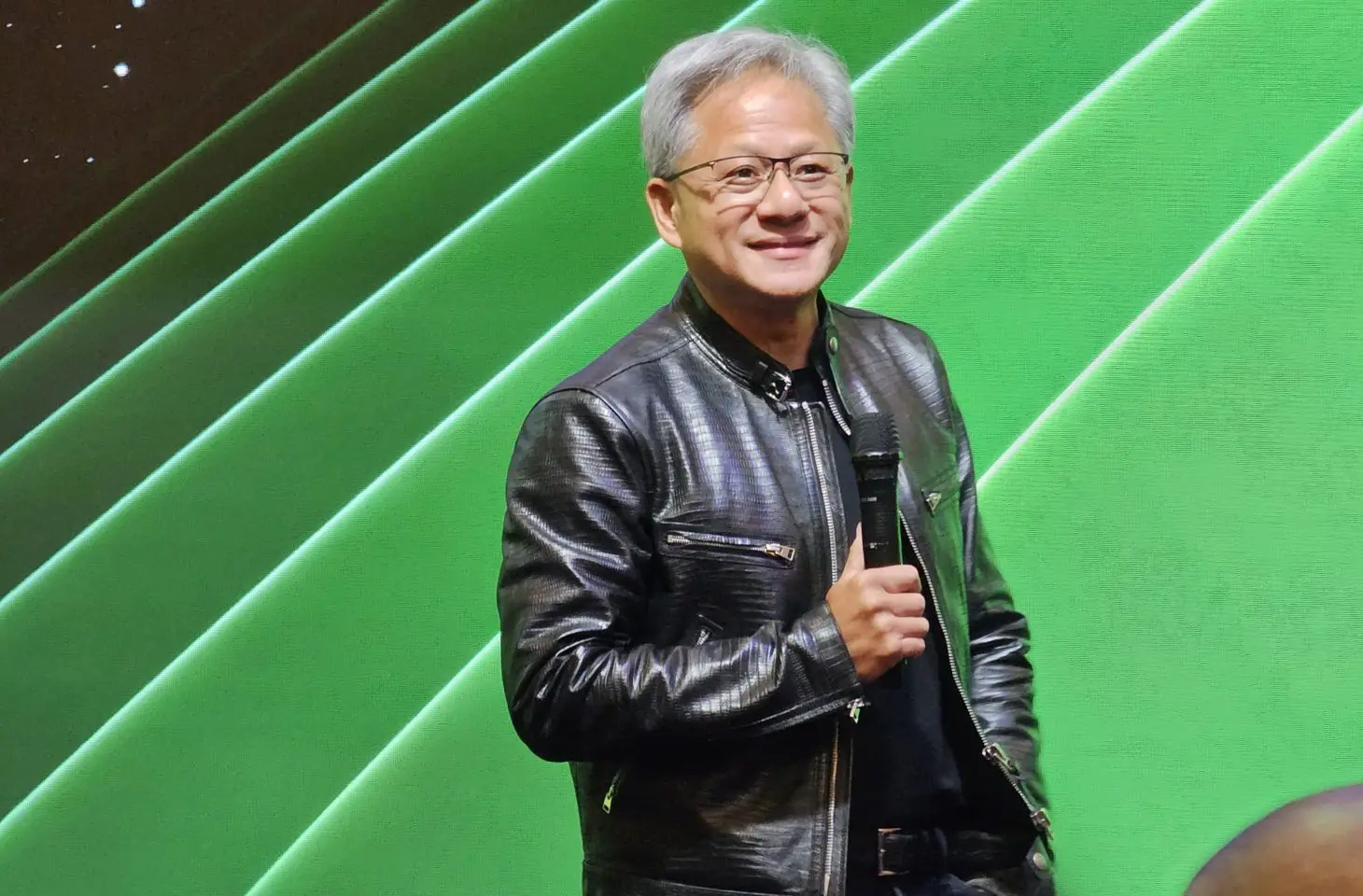

Tijdens Computex is het al Nvidia wat de klok slaat met Nvidia CEO Jensen Huang die als een rockster wordt ontvangen. Tijdens een vragenronde roept er zelfs een van de journalisten ‘we love you’ richting hem, wat met een lachje wordt ontvangen.

Wanneer er een vraag rond duurzaamheid wordt gesteld, merken we dat Huang duidelijkheid wil scheppen. Hij weet goed genoeg dat zijn nieuwe chips almaar meer energie vragen. De nieuwste Blackwell B200-chip vereist maar liefst 1.200 watt aan stroom. Toch komt hij met een duidelijk antwoord naar voor.

“AI geeft er niet om waar het naar school gaat. De wereld heeft niet genoeg energie beschikbaar dicht bij de bevolking.” Hij wijst hier naar de steeds kleinere energie-overschotten in grote steden zoals Amsterdam of Taipei waar nieuwe bedrijven geen energieaansluiting meer kunnen krijgen.

“Tegelijk heeft de wereld heel wat energie op overschot. De zon kan ontzettend veel energie afleveren. Enig nadeel: dat gebeurt op plaatsen waar geen mensen leven. We moeten datacenters en energiecentrales bouwen om AI te trainen op die plaatsen.”

Geaccelereerd werken

Een AI-model trainen via deep learning, vraagt het meeste energie. Terwijl dat die training bezig is, heb je amper externe connectiviteit nodig en is latency van geen belang. Eens de data aanwezig is, kan de training starten. Dit wordt continu herhaald, tot het model slim genoeg is.

Het uiteindelijke resultaat is een LLM (Large Language Model) zoals GPT-4, LLaMA 2, Claude of Gemini.

“Die training verloopt vandaag geaccelereerd via GPU’s, wat veel energie-efficiënter is dan via een traditionele CPU. Een GPU kan geaccelereerd tot 99 procent efficiënter werken dan een CPU. Dat is op zich al een enorme besparing in energiekosten. Daarom dat je vandaag tools als ChatGPT hebt. Een CPU kan die modellen niet tijdig en efficiënt genoeg trainen.”

Inference moet beter

Naast nieuwe locaties voor datacenters, specifiek om AI-modellen te trainen, ziet de Nvidia CEO veel progressiemarge aan de inference-kant. Dat is de kant waar het model in de praktijk wordt gebruikt, nadat de training achter de rug is. Elke vraag die je bijvoorbeeld aan ChatGPT stelt, vraagt inference.

“Generatieve AI gaat niet om training, maar om inference. Heel wat zaken gebeuren vandaag nog niet geoptimaliseerd genoeg. Neem nu onze eigen ontwikkelde tool voor weersimulaties in Taiwan. Die draait met onze hardware aan de inference-kant 3.000 keer efficiënter dan vroeger. Rekenkracht accelereren is hier het sleutelwoord”

“Denk niet aan training, maar aan inference. Daar valt de grote energiewinst uit te halen, wat het geheel duurzamer maakt.”

Dat die extra rekenkracht betekent dat je meer kan doen geaccelereerd, en daarmee opnieuw de limieten opzoekt met een hoger energieverbruik als gevolg, daarover spreekt hij met geen woord.