Artificiële intelligentie (AI) zorgt, net als elke nieuwe revolutionaire technologie, voor heel wat innovaties om ons leven gemakkelijker te maken. Deze technologie kan echter ook een negatieve invloed op ons leven hebben wanneer deze onzorgvuldig is of met verkeerde bedoelingen wordt ontwikkeld. Als deze digitale revolutie wil slagen om zoveel mogelijk mensen ten goede te komen, is het hanteren van een vorm van ethiek by design een must. Wat is ethische AI? En hoe vermijden we dat algoritmen ontsporen?

AI wordt enthousiast onthaald, vooral voor beslissingsalgoritmen waarvan wordt verondersteld dat ze vooroordelen en fouten in het menselijk oordelen ondervangen. Die beslissingsalgoritmen worden in de Verenigde Staten door openbare instanties gebruikt in onder andere gerechtshoven, de toewijzing van een school en heel wat andere beslissingen. Ze blijken echter ook nadelig te zijn voor zogenaamde gevoelige groepen, zoals geïllustreerd in de bestseller ‘Weapons of Math Destruction‘.

Dergelijke algoritmen worden voor het merendeel gebaseerd op automatisch leren (of machine learning). Beslissingsregels worden niet formeel in de code beschreven. Het beslissingsmodel wordt autonoom door het systeem aangeleerd op basis van historische gegevens, wat een indruk van objectiviteit wekt.

Het algoritme repliceert echter de vooroordelen die impliciet in de gegevens of in de door de mens gemaakte designkeuzes aanwezig zijn. Denk bijvoorbeeld aan gezichtsherkenningsalgoritmen die veel minder goed werken op gezichten van vrouwen met een donkere huidskleur dan op gezichten van mannen met een lichte huidskleur (zie Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification). Er zijn ook gendervooroordelen in word embedding die door algoritmen wordt toegepast om tekstgegevens te verwerken (zie Man is to Computer Programmer as Woman is to Homemaker?).

Word embedding maakt het mogelijk om een woord in een bepaalde context als numerieke vector voor te stellen zodat twee woorden met een vergelijkbare betekenis op een vergelijkbare manier zouden worden voorgesteld.

Wat is ethische AI?

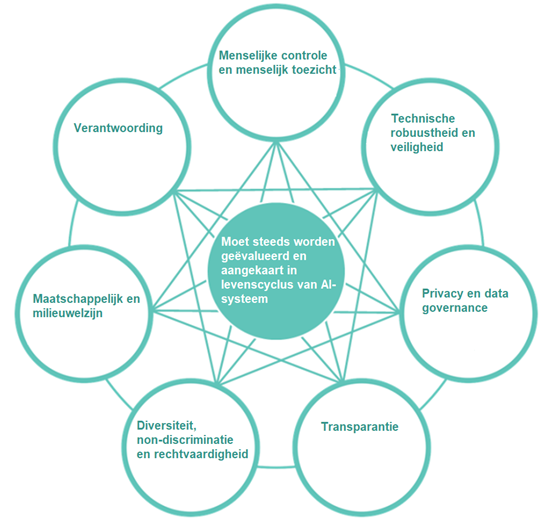

De Europese Unie wil haar stempel drukken op het AI-domein door van ethiek een essentieel onderdeel te maken van de ontwikkeling van een geavanceerde AI. De EU heeft daartoe een kader uitgewerkt in de vorm van ethische richtlijnen voor een betrouwbare AI (Ethics Guidelines for Trustworthy AI), die berusten op de volgende pijlers:

- Voldoen aan de toepasselijke wet- en regelgeving – wettig

- Naleving van ethische beginselen en waarden – ethisch

- AI mag geen onbedoelde schade aanrichten – robuust, zowel technisch als sociaal

Ethische AI wordt daarin gedefinieerd als AI die is ontwikkeld met respect voor de grondrechten en die de volgende beginselen in acht neemt:

- Respect voor de menselijke autonomie. Mensen die met AI-systemen werken, moeten hun volledige en effectieve zelfbeschikking kunnen behouden.

- Preventie van schade. AI-systemen mogen geen schade veroorzaken voor mensen.

- Rechtvaardigheid. Enerzijds moeten onrechtvaardige vertekening, discriminatie en stigmatisering van bepaalde personen of groepen worden voorkomen. Anderzijds moeten er procedures worden ingevoerd om beslissingen die door AI-systemen worden genomen aan te vechten om ertegen in beroep te kunnen gaan.

- Verantwoording. AI-systemen moeten transparant zijn en de beslissingen die met behulp van deze systemen worden genomen, moeten verklaarbaar zijn.

Hoe ontstaan vooroordelen in een algoritme?

Een (negatief) vooroordeel is een verstoring in de werking van het algoritme die leidt tot het systematisch benadelen van een groep personen die worden geïdentificeerd op basis van “gevoelige” kenmerken zoals bijvoorbeeld geslacht, politieke overtuiging of etniciteit.

Vooroordelen zitten voornamelijk vervat in de gegevens die worden gebruikt om een model op te stellen en/of in het ontwerp van het model. Ze zijn het gevolg van:

- Een niet correcte methode om gegevens te verzamelen. De gegevens weerspiegelen niet de werkelijkheid, er is sprake van een ondervertegenwoordiging van een groep van personen, objecten…

- De gegevens worden correct verzameld, maar bevatten structurele vooroordelen. Denk bijvoorbeeld aan een verzameling van tewerkstellingsgegevens waar historisch gezien bepaalde jobs systematisch aan mannen in plaats van aan vrouwen worden toegewezen.

- Het verkeerd categoriseren door mensen van de gegevens die nodig zijn voor de ontwikkeling van een classificatiemodel bij begeleid leren (of supervised learning).

- Een slecht ontwerp van de algoritmen. De algoritmen zijn niet neutraal en weerspiegelen de waarden van de personen die ze hebben ontworpen. Menselijke vooroordelen komen niet alleen tot uiting in de keuze van het soort gegevens dat in het model wordt gevoerd. Ze komen ook naar boven bij de bewerking die op deze gegevens wordt uitgevoerd, het gewicht dat eraan wordt toegekend, en nog veel meer.

- Het feit dat het beslissingsalgoritme halfautomatisch is. De uiteindelijke beslissing wordt door een mens genomen, maar die persoon kan de door het algoritme geproduceerde resultaten verkeerd interpreteren en vooroordelen introduceren.

Hoe kunnen we vooroordelen uitschakelen?

Er bestaan verschillende technieken om vooroordelen in algoritmen te meten en te voorkomen, maar techniek alleen is niet voldoende. Ethiek kan in de ontwikkeling en uitrol van een AI-systeem worden geïntegreerd door een aantal regels in acht te nemen:

- Beoordeel vóór de start van een AI-project de risico’s en de impact van het algoritme dat je wilt inzetten. Betrek de technische actoren, de personen die rechtstreeks met het algoritme te maken krijgen, en de personen die het algoritme gebruiken. Die risicobeoordeling moet gedurende de volledige levenscyclus van het AI-systeem doorlopend worden uitgevoerd.

- Zorg voor een diverse groep van personen die betrokken is bij de ontwikkeling en uitrol van het algoritme.

- Stel duidelijke doelen voorop wat betreft de vooroordelen die je binnen een bepaalde wettelijke context wilt temperen/uitschakelen.

- Stel (samen met de technische teams) parameters vast om die vooroordelen te kunnen meten.

- Zorg voor transparantie: de beslissingen die door een algoritme worden genomen, moeten verklaarbaar zijn. Het is belangrijk om te weten wat er in de beslissing allemaal wordt meegewogen, vooral wanneer het misloopt. Dit beperkt het gebruik van algoritmen zoals neurale netwerken of algoritmen van derden waarvan de intellectuele eigendom beschermd is.

- Zie toe op de robuustheid van de algoritmen, door bijvoorbeeld na te gaan of het algoritme gepast reageert op kleine veranderingen in de invoergegevens. Bovendien moet het algoritme in twee gelijkaardige situaties een vergelijkbare beslissing nemen. In de overheidssector zorgt dit ervoor dat elke burger gelijk behandeld wordt.

- Monitor de algoritmen, train ze regelmatig opnieuw op nieuwe gegevens en zie er dan op toe dat eventuele vooroordelen niet worden versterkt door een feedback loop. Hiermee bedoelen we de beslissingen die met behulp van een algoritme worden genomen en hun gevolgen voor de nieuwe gegevens. Die worden op hun beurt weer gebruikt om een nieuwe versie van dit algoritme te genereren.

- Laat een auditcontrole uitvoeren op de algoritmen; er bestaan echter nog geen duidelijke regels over hoe dit precies moet gebeuren.

Het is ook mogelijk om algoritmen van derden te gebruiken. De manier waarop deze technologieën werken en de risico’s die eraan verbonden zijn, zijn niet meteen duidelijk. Bovendien stemmen de waarden van de personen die deze algoritmen hebben ontwikkeld niet noodzakelijk overeen met de waarden die worden uitgedragen door degenen die ze gaan gebruiken.

Bestaat er een wettelijk kader?

Er bestaat een Europese non-discriminatiewet die een gelijke behandeling van alle personen waarborgt, maar die wet is moeilijk toepasbaar op AI. Het is immers niet gemakkelijk om aan te tonen dat het algoritme discrimineert. Bovendien is die non-discriminatiewet niet homogeen genoeg om in een geautomatiseerd systeem te worden geïntegreerd. De contextuele benadering laat ruimte voor een open juridische interpretatie die sterk op intuïtie berust (Why fairness cannot be automated: bridging the gap between EU non-discrimination law and AI).

De EU is evenwel behoorlijk ambitieus wat de bescherming van personen betreft. Na de invoering van de Algemene Verordening Gegevensbescherming (GDPR), een van de grootste verwezenlijkingen op het gebied van gegevensbescherming, heeft de Europese Commissie in april een voorstel gepubliceerd voor een regelgevingskader voor AI dat inzoomt op de risico’s. In dat voorstel worden verschillende categorieën van risico’s beschreven, met verschillende wettelijke verplichtingen voor elke categorie. Zo zal een AI-sorteersysteem voor rekrutering als “hoog risico” worden aangemerkt, met (onder meer) verplichtingen inzake risicobeoordeling, gedetailleerde documentatie en traceerbaarheid van de resultaten.

AI en ethiek: conclusie

We kunnen stellen dat de toepassing van AI zowel bij de overheid als in de privésector onvermijdelijk is. Gezien de impact van AI op de samenleving is het belangrijk om van meet af aan een echte ethische AI-strategie uit te tekenen. De algoritmen moeten eerlijk zijn en ook als zodanig gepercipieerd worden.

We moeten burgers daarom zo goed mogelijk informeren, hen helpen het effect van algoritmen te begrijpen en het gemakkelijker maken om beslissingen die hen aanbelangen aan te vechten. Een ethische AI is dan een eerste, onmisbare stap om een evenwicht te vinden tussen compleet wantrouwen en overdreven optimisme.

Dit is een ingezonden bijdrage van Katy Fokou van Smals Research. Via deze link vind je meer informatie over de het onderzoek van de organisatie. Dit artikel werd geschreven in eigen naam en neemt geen standpunt in namens Smals.