Het Nederlandse onderzoeksinstituut Nikhef verwerkt data van verschillende internationale experimenten zoals de LHC van het CERN. Hoewel het instituut naast een supercomputer staat, voldoet die HPC-installatie niet aan de specifieke noden van de wetenschappers.

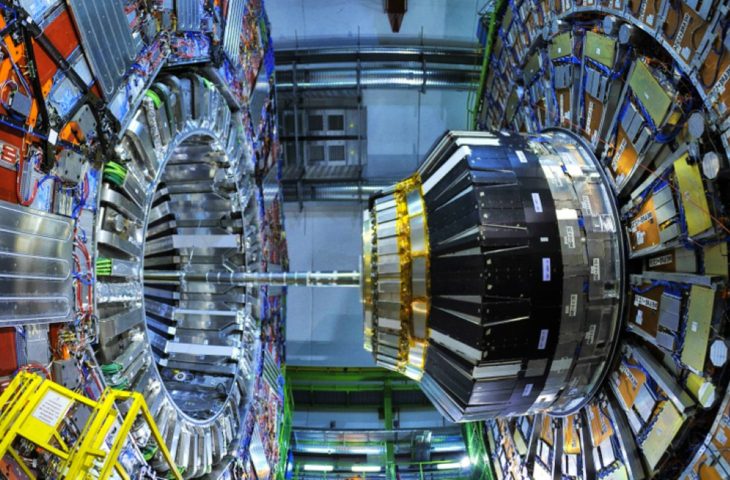

Bij onze Noorderburen houdt het Nederlandse Nationaal Instituut voor Subatomaire Fysica (Nikhef) zich bezig met onderzoek naar de meest elementaire deeltjes van het universum. Wetenschappers bij Nikhef analyseren onder andere data afkomstig van drie van de vier experimenten bij de Large Hadron Collider (LHC) van het CERN. Die data zijn talrijk en laten zich niet zomaar onderzoeken.

Datavloedgolf

“Wanneer de LHC aanstaat, ontvangen we ongeveer 10 petabytes per jaar”, weet Tristan Suerink, IT-architect bij Nikhef. “Binnen zes jaar zal dat volume nog vertienvoudigen. Het gaat daarbij niet om alle data die de LHC genereert, maar opgeschoonde en gefilterde gegevens voor verzending.” Naarmate de sensoren van experimenten zoals die bij de LHC nauwkeuriger worden, vergroot ook het datavolume waarmee een onderzoekscentrum als Nikhef wordt geconfronteerd.

Het instituut is aangesloten bij het Nederlandse Surfnet en ontvangt de data van de LHC via een 400 Gbit-glasvezelverbinding tussen Genève en Amsterdam. Eens aangekomen bij Nikhef, is het tijd voor de verwerking.

Supercomputer? Nee bedankt.

Dat lijkt op papier een peulenschil. Niet omdat de data bevatbaar zijn, wel omdat de buren van Nikhef een stevige computer huisvesten: de 1,3 PFlops Cartesius-supercomputer. Die machine wordt dit jaar zelfs vervangen door een nieuw exemplaar dat tien keer sneller is. Toch heeft Nikhef daar niet veel aan.

“Als je ons een supercomputer geeft, dan maken we die vrij snel stuk”, lacht Suerink. Dat komt omdat de dataverwerking bij Nikhef niet onder High Performance Computing valt. “In ons geval gaat het om High Throughput Computing.”

Grote foto’s analyseren

Suerink verduidelijkt. “De data die we krijgen van de experimenten kan je vergelijken met foto’s. Die foto’s zijn vele gigabytes groot. Het is aan ons om de foto’s te vergelijken en dat is op zich niet zo’n rekenintensief werk. Iedere dataset staat op zichzelf en het aantal berekeningen dat we er op loslaten is vrij beperkt. Het is het formaat van de datasets en de hoeveelheid getransporteerde data die voor ons de flessenhals vormt. Dergelijke bewerkingen uitvoeren met een supercomputer is een beetje als met een Ferrari door de woestijn rijden.”

Dergelijke bewerkingen uitvoeren met een supercomputer is een beetje als met een Ferrari door de woestijn rijden.

Tristan Suerink, IT-architect Nikhef

Nikhef heeft dus geen snelle auto nodig, maar een robuuste terreinwagen. Daarvoor klopte Suerink aan bij Rick Koopman, EMEA Technical Leader bij Lenovo. Lenovo voorziet de IT-hardware voor Nikhef en daar is een goede reden voor.

Suerink: “Voor onze workloads merkten we dat dual socket-systemen geen meerwaarde bieden. Sterker nog: met een CPU minder per server haalden we soms betere prestaties. Onze berekeningen werken het best op een single socket-systeem met zoveel mogelijk rekenkernen. Bovendien moet de CPU snel kunnen communiceren met de opslag en moeten verschillende servernodes vlot met elkaar praten.”

Unieke vereisten

Wie twee jaar geleden met dat boodschappenlijstje naar de winkel stapte, had niet veel keuze. Intel zwaaide historisch gezien nog steeds de plak, en maakte geen prioriteit van CPU’s met veel rekenkernen. Wilde je veel kernen en threads, dan moest je maar voor een dual socket-oplossing kiezen. AMD had net zijn tweede generatie van Epyc-chips gelanceerd: Rome. Epyc Rome en de Zen 2-architectuur ondersteunden in 2019 al PCIe 4.0. Bovendien combineerde de chip wel 64 rekenkernen op één CPU. Intel had daar geen antwoord op.

Suerink zocht natuurlijk niet alleen een processor, maar een totale server voor een rekencluster. De fabrikanten die Epyc Rome omarmden, bleken schaars. “De meeste OEM’s hadden hun servers met de eerste generatie AMD Epyc-chips verfrist met Rome, zonder het hele binnenwerk te vernieuwen”, weet de IT-expert.

Flexibele hardware

Dat was een probleem, aangezien die beperkte vernieuwing geen PCIe 4.0 met zich meebracht. De Lenovo Thinksystem SR655-servers waren de eerste toestellen volledig gebouwd voor Epyc Rome en PCIe 4.0. Bovendien ondersteunde de servers een veelvoud van configuraties waaronder een uit de kluiten gewassen single socket-oplossing.

“De noden van Nikhef zijn redelijk uniek”, bevestigt Koopman. “Bandbreedte is essentieel voor de workloads zodat minder of tragere PCIe-lanes een directe negatieve impact hebben. De single socket SR655-reeks was in eerste instantie bedoeld voor serviceproviders die met gelijkaardige uitdagingen kampen, maar bleek uitermate geschikt voor Nikhef.”

Lenovo heeft een groot testlab waar het de noden van HPC-klanten kan analyseren, maar dat kwam niet aanbod. “Stuur mij liever een testsysteem waar ik zelf mee aan de slag kan”, zegt Suerink. “Het eerste labo dat onze infrastructuur helemaal kan nabootsen moet ik nog tegenkomen. Bovendien is het testwerk veel te leuk.”

Het eerste labo dat onze infrastructuur helemaal kan nabootsen moet ik nog tegenkomen.

Tristan Suerink, IT-architect Nikhef

De grote flexibiliteit van Lenovo is een ander pluspunt voor Nikhef, dat als de dood is voor vendor lock-in. “Als instituut houden we van open standaarden en opensource. We zitten niet graag vast aan één fabrikant.” Suerink vind Nvidia’s houdgreep op de GPU-markt te sterk, en verkiest alleen al daarom AMD-accelerators. Dergelijke configuraties waren eveneens een zeldzaamheid bij andere fabrikanten, terwijl Lenovo er wel in kon voorzien.

Single socket-maatwerk

Uiteindelijk verwerkt Nikhef de experimentele data in een cluster bestaande uit vier racks en 64 servers in totaal. Iedere server heeft een AMD Epyc 7702 aan boord met 64 rekenkernen. De toestellen hebben verder 512 GB RAM en 4 TB NVMe SSD’s voor tijdelijke opslag van werkdata. Zeven machines zijn al uitgerust met telkens twee AMD Radeon Instinct MI50-accelerators, met de mogelijkheid dat uit te breiden wanneer de werklast daarom vraagt. “De MI50 is trager in pure rekenkracht dan de Nvidia Tesla V100 die destijds het alternatief was, maar kost maar de helft. Zo komen we voor hetzelfde geld toch bij meer rekenkracht uit”, verduidelijkt Suerink.

Twee jaar geleden was de keuze voor AMD haast vanzelfsprekend. Intel kon gewoon niet dezelfde single socket-prestaties bieden. “Intel moest anderhalve keer meer machines leveren dan AMD voor dezelfde rekenkracht”, herinnert Seurink zich.

lees ook

AMD EPYC Rome verhoogt de druk op Intel met 7nm 64-core serverchips

Vandaag is de concurrentiepositie van Intel wel opnieuw sterker volgens Koopman. “AMD had de afgelopen twee jaar dankzij PCIe 4.0 en de hogere core count een duidelijk voordeel. Daarmee haalde de fabrikant veel HPC-installaties binnen. Met de introductie van Ice Lake heeft Intel AMD wel bijgebeend. Soms is Intel beter, soms AMD. Je moet echt nauwkeurig workloads onderzoeken om te ontdekken wel fabrikant de beste prestaties kan leveren.”

Uiteindelijk zijn Nikhef en Seurink heel tevreden van hun AMD-gebaseerd High Throughput-cluster. Zowel AMD als Lenovo konden op het juiste moment met de juiste hardware inspelen op de noden van Nikhef, terwijl die niet zo vanzelfsprekend waren. De supercomputer naast de deur wordt intussen zoals gepland vervangen door een nieuw exemplaar. Binnenin zit toch ook daar AMD Epyc.