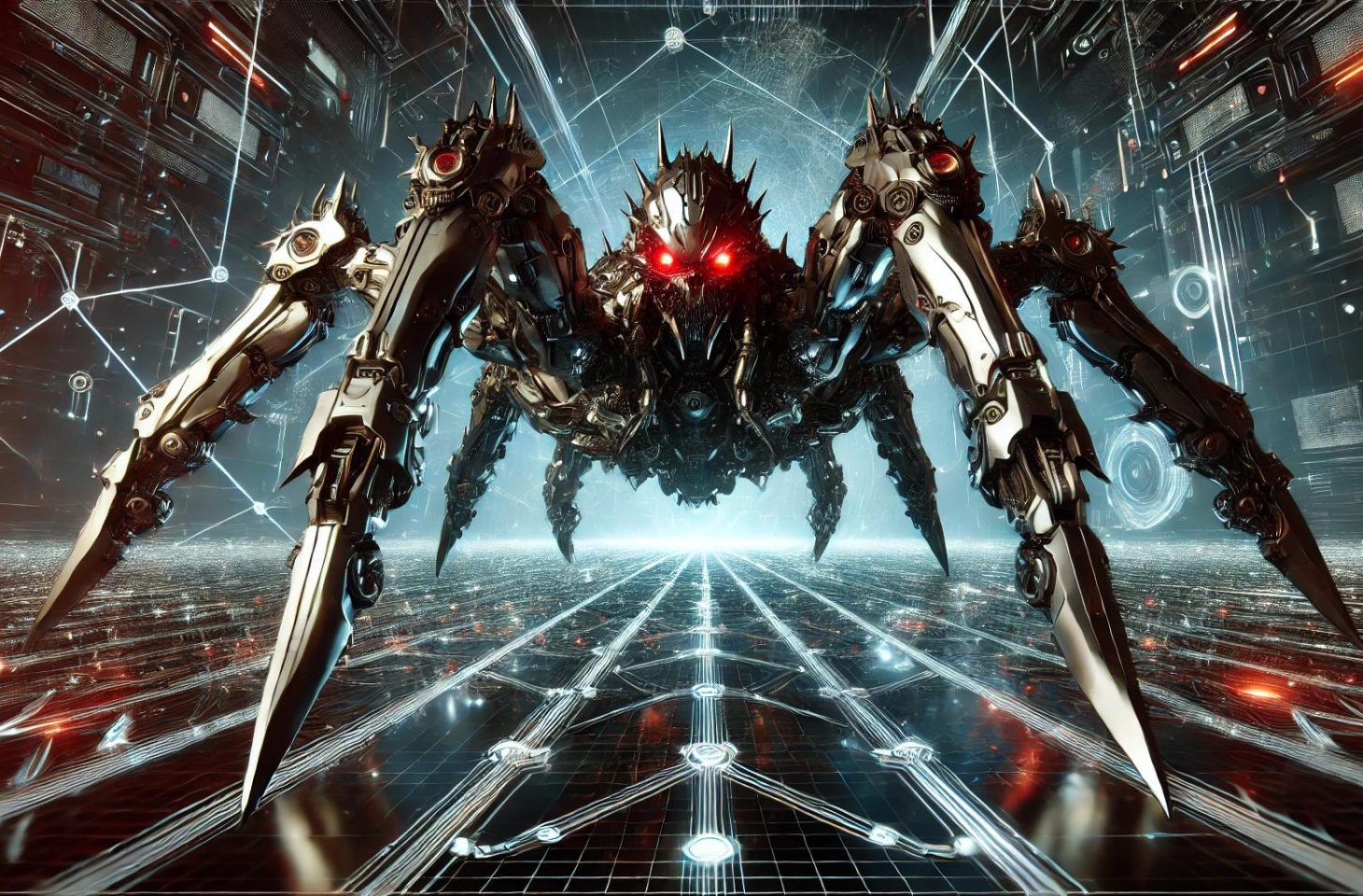

Verschillende bedrijven stellen het ‘agressieve’ gedrag van Anthropic’s webcrawler aan de kaak, die websites tot miljoenen keren per dag bezoekt om data te verzamelen.

Om AI-modellen slim te maken, zijn grote hoeveelheden data nodig. Het is inmiddels een publiek geheim dat die data van het internet afkomstig zijn. AI-bedrijven zoals OpenAI en Anthropic beschikken over ‘webcrawlers’ die het internet afschuimen en publiek beschikbare informatie verzamelen. Deze praktijk is in theorie niet illegaal, al blijkt Anthropic hier nogal ver in te gaan.

Kyle Wens, CEO van iFixit, tikt Anthropic in een post op X op de vingers. De webcrawler van Anthropic zou de website binnen een tijdspanne van 24 uur één miljoen keer bezocht hebben. Het kan nog straffer: de website Freelancer.com kreeg Anthropic in amper vier uur tijd 3,5 miljoen keer over de vloer.

Regels van het internet

Zowel iFixit als Freelancer.com hekelen de ‘agressieve’ manier waarop Anthropic het web afschraapt. Naast het gegeven dat Anthropic met hun content gaat lopen, kan overmatige activiteit van webcrawlers de servers overbelasten.

Het ging op Freelancer.com zo ver dat de webbeheerders zelfs Anthropic op hun zwarte lijst moesten zetten. “Ze schenden de regels van het internet”, zegt CEO Matt Barrie aan Financial Times. Anthropic reageert dat het de klachten onderzoekt en het niet de bedoeling heeft om intrusief te werk te gaan.

Makers van grote AI-modellen liggen al een tijdje onder vuur omwille van de manier waarop ze met publieke data op het internet zijn omgegaan. Spelers uit de sector redeneren dat wat openbaar is, gebruikt mag worden om modellen te trainen, al klopt die redenering ook niet helemaal. Op het internet is het auteursrecht evengoed van tel.

lees ook

Microsofts AI-baas ontkent bestaan auteursrechten op het internet

Intussen zijn er licentieovereenkomstne gesloten tussen AI-bedrijven en nieuwsmedia of grote internetplatformen zoals Reddit, die veel content beheren en bezitten. Zo hopen AI-bedrijven toekomstige rechtszaken te voorkomen. Anthropic heeft dergelijke akkoorden nog niet gesloten.

Robot.txt

Als webbeheerder kan je webcrawlers de toegang tot je website te ontzeggen. Het robot.txt-bestand injecteren in de directory van je website plaatst een stopbord voor webcrawlers. Het systeem is echter verre van waterdicht. Door webcrawlers te ‘vermommen’ als een legitieme websitebezoeker, is het zelfs vrij eenvoudig te omzeilen.