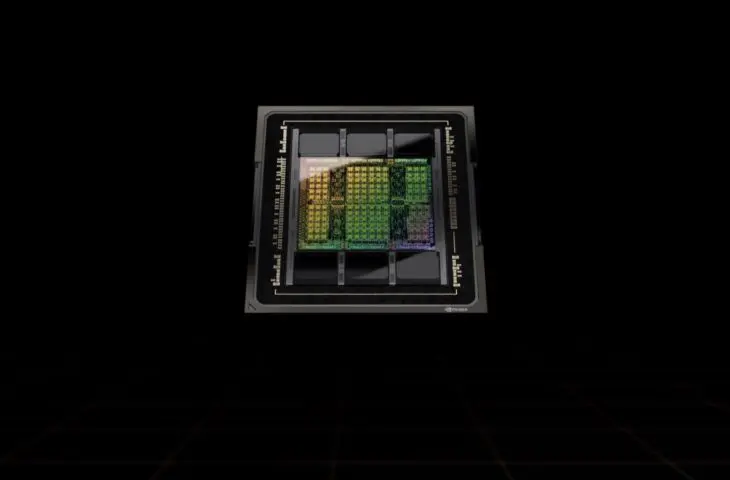

Nvidia kondigt de krachtige H100-GPU aan. De AI-accelerator is gebouwd met de splinternieuwe Nvidia Hopper-architectuur die Ampere opvolgt.

Op zijn GTC-conferentie lanceert Nvidia de H100-GPU. Dat is een krachtige accelerator voor AI-workloads in datacenters. De Nvidia H100 volgt de A100 op. Zoals de H in de naam doet vermoeden, is de nieuwe chip niet meer gebaseerd op de Ampere-architectuur. De Nvidia H100 is de eerste telg van een nieuwe generatie van Nvidia-chips gebaseerd op de Hopper-architectuur. Die is vernoemd naar computerwetenschapper Grace Hopper, wiens voornaam Nvidia gebruikt voor een toekomstige CPU.

Monsterchip

De Nvidia Hopper H100 moet opnieuw ’s werelds krachtigste accelerator zijn. Nvidia perst 80 miljard transistors op de chip met de hulp van TSMC’s ultramoderne 4 nm-bakproces. De GPU ondersteunt PCIe Gen 5 en gebruikt als allereerste chip ter wereld HBM3-geheugen, goed voor een geheugenbandbreedte van 3 TB/s. Nvidia voorziet 80 GB per chip. Wat klassieke rekenkracht betreft is de Nvidia H100 drie keer sneller dan de Nvidia A100. De chip heeft een rekenkracht van 2.000 TFlops (FP16). Voor al die rekenkracht heeft de H100 een TDP van 700 watt.

Om machine learning met transformer-modellen zoals Megatron te faciliteren, heeft de H100 een nieuwe transformer-engine aan boord. Die verhoogt de efficiëntie en snelheid van de training van natural language-modellen met factor zes zonder in te boeten op nauwkeurigheid.

MIG 2

MIG, kort voor Multi-Instance GPU maakt opnieuw zijn intrede. Nvidia introduceerde MIG met de A100 in 2020. Met MIG kan je de H100 opsplitsen in zeven geïsoleerde partities die onafhankelijk van elkaar kunnen werken.

lees ook

Nvidia presenteert Grace superchip met 144 ARM-kernen

Nvidia introduceert daarin een nieuw niveau van vertrouwelijkheid op maat van cloudproviders. Tot zeven gebruikers kunnen ieders een stukje van de capaciteit van de H100 gebruiken, zonder dat ze daarbij toegang kunnen krijgen tot data van de andere partijen. Vergelijk de technologie met de manier waarop een klassieke processor met veel rekenkernen wordt opgesplitst in een datacenter om verschillende virtuele machines aan te drijven.

Meer is beter

Nvidia combineert acht H100-GPU’s in een Nvidia DGX H100. Het systeem komt met 640 GB aan HBM3-geheugen. Nvidia introduceerde de DGX-systemen met de A100. De kleine en compacte supercomputers zijn ideaal voor AI-workloads in enterprises of onderwijsinstellingen. De Universiteit Antwerpen had zich bijvoorbeeld in 2019 zo’n systeem aangeschaft. De nieuwe DGX H100 heeft een halve petaflops aan FP64-rekenkracht en is zo opnieuw drie keer sneller dan zijn voorganger.

Volstaat dat niet, dan is er de DGX SuperPOD met DGX H100. Voor dat toestel combineert Nvidia 32 DGX H100’s met ieders 8 GPU’s voor een HPC-installatie met 256 GPU’s. Die lijmt de chipspecialist aan elkaar met zijn nieuw NVLink Switch-systeem. Het geheel heeft één exaflops aan AI-rekenkracht ter beschikking.

Nog gulziger? Dan is er het Nvidia Eos-systeem. Dat is een blauwdruk voor een AI-supercomputer met 9 exaflops aan FP16-rekenkracht. Het systeem is een uit de kluiten gewassen SuperPod met 576 DGX H100’s en 360 NVLink-switches. De MIG-functionaliteit zorgt er hier voor dat meerdere gebruikers de rekenkracht simultaan veilig kunnen benutten.

Beschikbaarheid

De Nvidia H100 komt naar datacenters en cloudproviders. De Hopper-GPU is beschikbaar als PCIe- of CNX-kaart voor mainstream-servers, in een DGX-systeem of in een SuperPod. In de toekomst komen daar eventueel Eos-supercomputerconfiguraties bij.

Net als bij Ampere kan je er vanop aan dat de H100 slechts het openingssalvo is voor Hopper. Instapmodellen voor accelerators zullen ongetwijfeld volgen. Daarna mag je uitkijken naar meer traditionele kaarten gebouwd op de architectuur, onder andere voor workstations.