Training van generatieve AI vereist rekenkracht, en Meta laat weten een heleboel extra pk’s in huis gehaald te hebben. Zo hoopt het bedrijf concurrentiële LLM’s te bouwen.

Om modellen zoals GPT-4 achter ChatGPT te trainen, hebben organisaties enorm veel rekenkracht nodig. Meta wil met Llama 3 een Large language Model ontwikkelen dat het beste van OpenAI en Google kan evenaren. Daarom heeft het bedrijf het grove geschut bovengehaald.

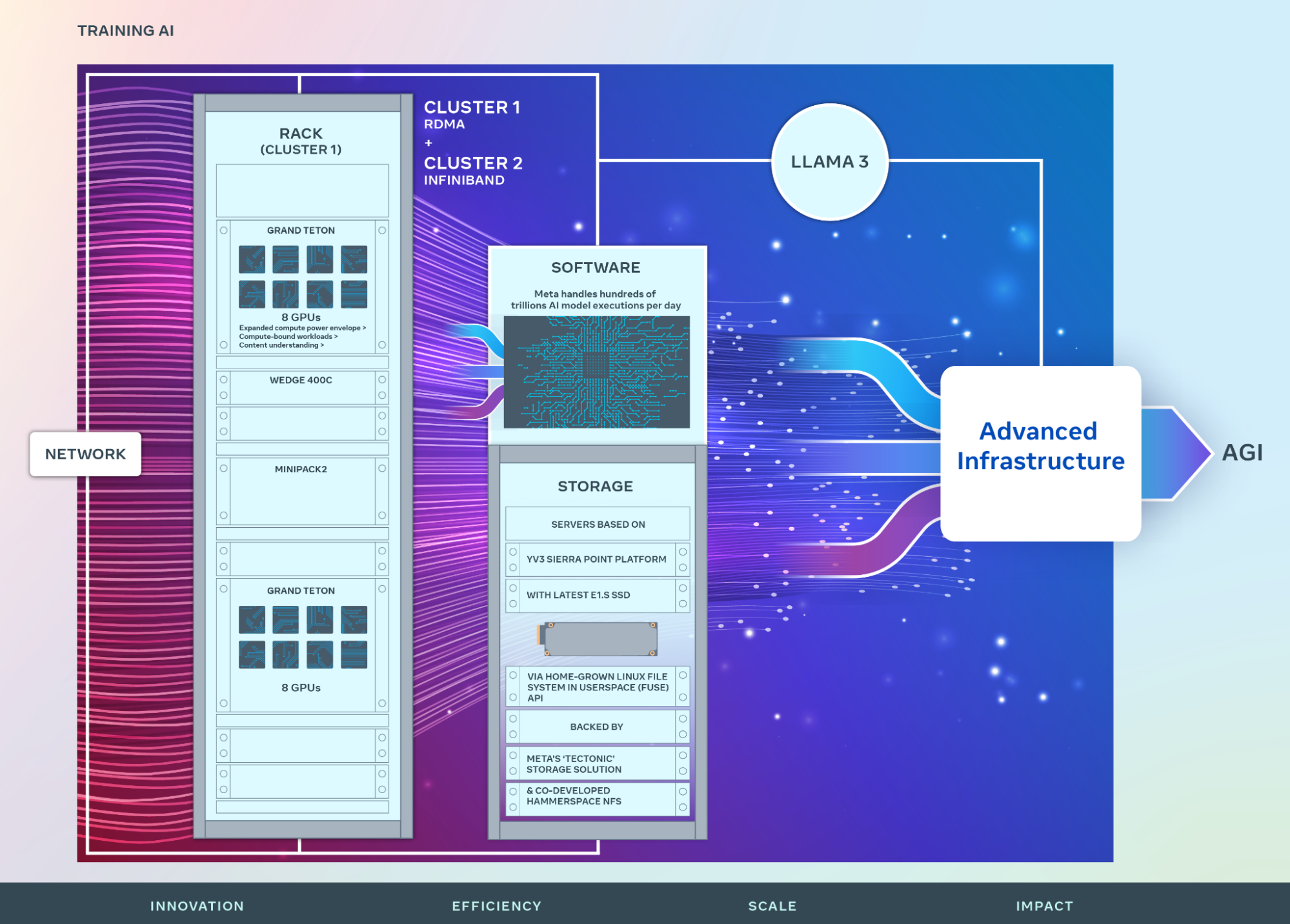

Meta laat weten dat het in zijn eigen datacenter twee enorme GPU-clusters heeft gebouwd met telkens 24.576 GPU’s onder de motorkap. Bovendien heeft Meta de krachtigste chips van Nvidia bemachtigd: de AI-supercomputers hebben H100-accelerators aan boord. De clusters zijn een ware sprong voorwaarts komende van een systeem met ongeveer 16.000 oudere Nvidia A100-accelerators.

Meta heeft een eigen open GPU-hardwareplatform dat het gebruikt om grote AI-workloads te ondersteunen. Dat heet Grand Teton. Meta combineert het met zijn eveneens zelf ontwikkelde Open Rack-architectuur, die meer flexibiliteit biedt in de installatie van de hardware.

Steeds meer

De twee nieuwe clusters zijn geen eindpunt. Meta wil zoveel Nvidia H100-chips inlijven als het kan en hoopt tegen het einde van het jaar 350.000 accelerators aan het werk te zetten.

Wanneer Meta Llama 3 wil klaar hebben, is onduidelijk. De clusters zullen in de nabije toekomst voldoende om handen hebben. Wanneer het model klaar is, wil Meta ook bestaande modellen verbeteren. Op lange termijn moeten de de facto supercomputers de ontwikkeling van meer menselijke AI bijstaan.