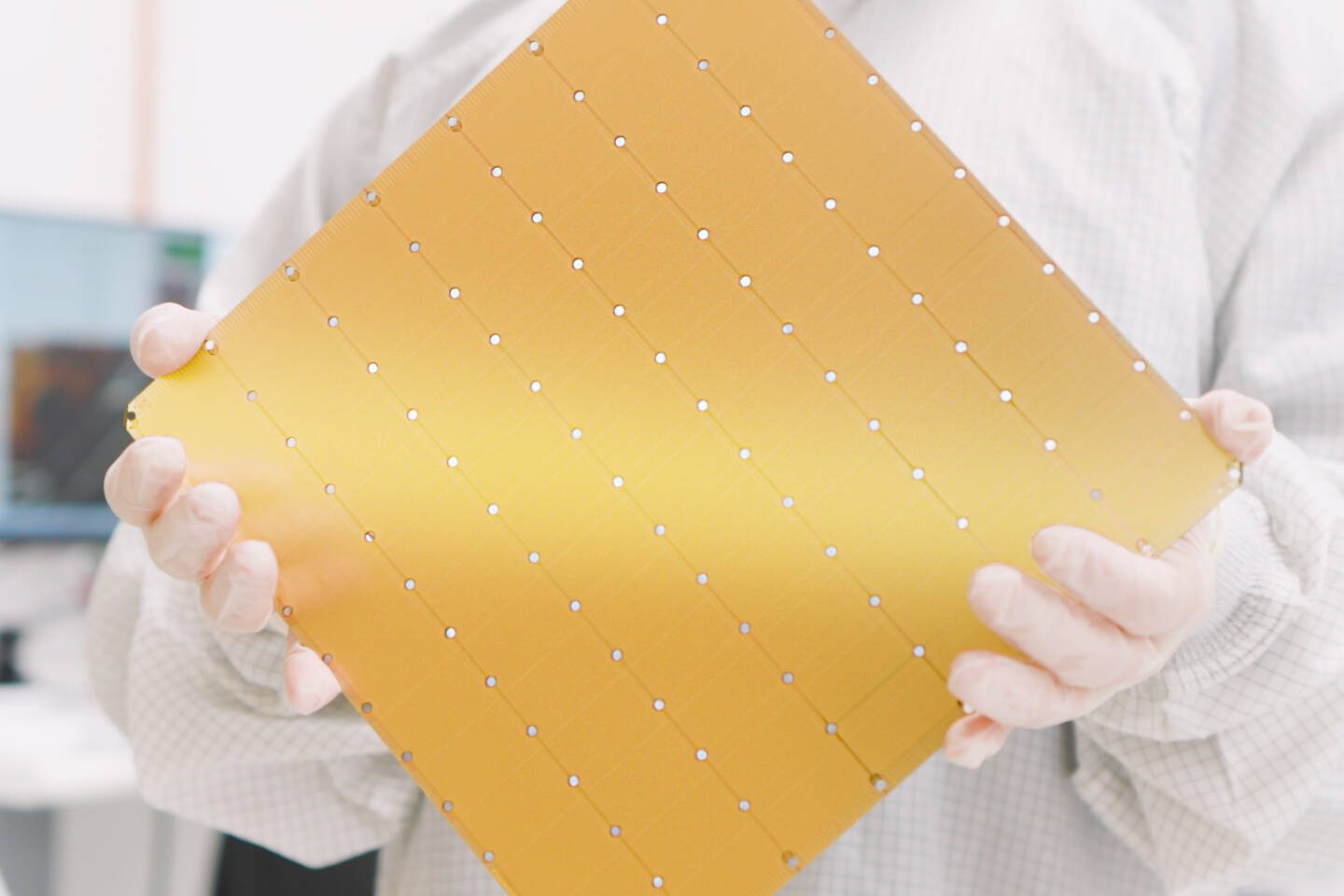

Chipdesigner Cerebras Systems stelt zijn Wafer Scale Engine 3 voor: een AI-processor met het formaat van een volledige wafer, goed voor 900.000 kernen.

Van chipdesigner Cerebras Systems mag het allemaal wat groter zijn. Het bedrijf pakt uit met zijn Wafer Scale Engine 3 (WSE-3): een immense chip die even groot is als een volledige wafer. Dat biedt ruimte voor vier biljoen transistors, goed voor 900.000 AI-kernen en 44 GB SRAM op de chip zelf. Cerebras claimt 125 PetaFlops aan FP16-prestaties.

De chip meet 46.225 mm², vergeleken met ‘slechts’ 814 mm² voor de nochtans ook lijvige Nvidia H100. Cerebras stelt dat zijn oplossing zo’n acht keer sneller complexe AI-modellen kan trainen. Dat is niet zo veel, aangezien de chip meer dan vijftig keer groter is, maar er zijn meer voordelen. Zo kan een cluster van chips 1,2 PB aan geheugen slikken en modellen van 24 biljoen parameters verwerken, tegenover 40 miljard parameters voor de DGX H100. De vergelijking spreekt tot de verbeelding, maar is natuurlijk een beetje appelen tegenover peren zetten.

Eigen supercomputer

Cerebras stopt de chip in zijn eigen CS-3supercomputer die met clusters van tot 2.048 nodes overweg kan. Het zou CS-3 maar een dag duren om Llama 70B te trainen. Bovendien zou het eenvoudiger zijn om dergelijke modellen te trainen op de infrastructuur. Cerebras is niet aan zijn proefstuk toe: de WSE-3 en CS-3 zijn zoals de namen suggereren de derde iteraties van de architectuur.

Cerebras Systems ervaart interesse vanuit verschillende sectoren voor zijn enorme chip en bijhorende HPC-oplossing. Het maatwerk lijkt interessant voor de training van steeds grotere fundamentele LLM’s, waarvoor steeds krachtigere en efficiëntere systemen nodig zijn.