AMD stelt de MI300X voor. Dat is geen APU zoals de MI300A, maar een volbloed-GPU die haast overloopt met RAM. Het overvloedige geheugen met de accelerator een streepje voor geven vergeleken met concurrent Nvidia en de H100.

Eerst was er gewoon de AMD Instinct MI300: een APU die Zen 4-kernen combineert met CDNA 3-gebaseerde grafische chiplets en gedeeld HBM 3-geheugen. Begin dit jaar heette de chip plots AMD Instinct MI300A, al veranderde de toevoeging van de ‘A’ weinig aan het concept.

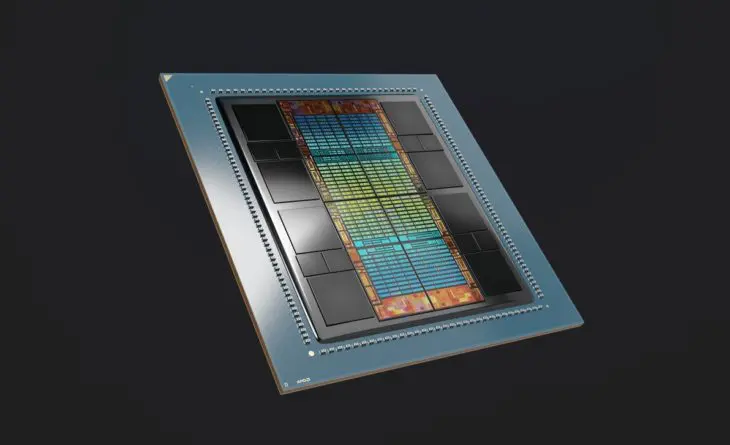

AMD Instinct MI300X

Op de Datacenter- en AI-technologie-première in San Francisco in de VS horen we nu plots dat Instinct MI300 een familie is en de MI300A een broertje heeft: de AMD Instinct MI300X.

Met de X-versie profiteert AMD van het flexibele modulaire chiplet-design van de accelerator door de 24 Zen-kernen van de chip te rukken en extra CDNA 3-GPU-kernen in de plaats te stoppen. De MI300X is met andere woorden geen APU, maar een relatief klassieke accelerator die je in een server dient te koppelen met een processor.

Volledig model in één chip

De MI300X krijgt 192 GB aan HBM 3-geheugen mee met een bandbreedte van 5,2 TB/s. “De chip is geoptimaliseerd voor generatieve AI”, zegt CEO Lisa Su op het podium en tijdens een demo zien we heel concreet wat dat betekent. Het volledige Falcon 40B-model past in één keer in de enorme hoeveelheid ingebouwd geheugen. Zo kan de chip met de vingers in de neus voor inferentie zorgen bij zelfs erg uitgebreide AI-modellen.

“De MI300X heeft 2,4 keer meer geheugen en 1,6 keer meer HBM-bandbreedte dan de Nvidia H100”, horen we nog op het podium. Of de chip ook krachtiger is, betwijfelen we. Op het evenement in San Francisco is de MI300X te gast als teaser. De echte lancering zal later volgen, dus voelt AMD zich niet genoodzaakt om specificaties zoals TDP of rekenkracht in Flops meteen te delen.

Die specificaties zijn bovendien een beetje naast de kwestie voor AMD’s marktpositionering van de Instinct MI300X. “We hebben een TCO-voordeel”, verduidelijkt Brad McCredie, VP Datacenter en Accelerated Processing bij AMD. “Zeker voor inferentie gaan we een voordeel hebben wat inferentie per dollar betreft.”

Ingespeeld op evoluerende workloads

McCredie geeft nog toe dat de opsplitsing van Instinct MI300 in MI300A en MI300X niet van het begin op de planning stond. “Maar het was wel altijd een optie.” Vanwaar dan de evolutie van product naar productfamilie? “AI-workloads zijn snel geëvolueerd en meer compute-intensief geworden. Daarom hebben we beslist om de MI300X te maken, wat dankzij het modulaire design niet zo moeilijk was.”

Zoek je een functionele analogie bij de concurrentie, kijk dan naar de Nvidia H100 als tegenhanger voor de MI300X en de Nvidia Grace-Hopper-superchip als equivalent voor de MI300A.

Platform

Op het hoofdpodium toont Su intussen nog een platformdesign met acht MI300X-chips in een standaard serverdesign. Dat zal volgens haar snel en eenvoudig te implementeren zijn in bestaande infrastructuur. De Instinct MI300A die op CES werd aangekondigd, wordt vandaag al gesampled bij klanten. Met de Instict MI300X kunnen partners in het derde kwartaal van dit jaar aan de slag gaan. Tegen het einde van het jaar moeten beide Instict MI300-varianten in volumeproductie gaan.