De nieuwste versie van GPT-4 in ChatGPT kan voortaan documenten analyseren, het web doorsnuffelen en beelden genereren in één enkel gesprek, waar context bewaard blijft. Zo wordt de chatbot plots een stuk veelzijdiger.

OpenAI combineert alle functionaliteit die het de voorbije weken voor ChatGPT aankondigde in één geheel. In oktober lanceerde het bedrijf bijvoorbeeld Dall-E 3. Met die beeldengenerator kan je gedetailleerde afbeeldingen genereren aan de hand van een beschrijving. Om Dall-E 3 te gebruiken, moest je in ChatGPT een nieuw gesprek starten en vooraf aanduiden dat je met Dall-E wilde praten, en niet het standaard GPT-4-model.

Hetzelfde gold voor de later geïntroduceerde analytics-capaciteit. Selecteerde je GPT-4 voor analytics, dan kon ChatGPT plots hele PDF-documenten lezen en analyseren. In die analytics-modus lukte het echter niet om Dall-E 3-beelden te genereren. Verder kon ChatGPT al geruime tijd via Bing op het web surfen, maar die functionaliteit hoorde niet bij Dall-E 3 of de Analytics-versie van de bot. Wie bijvoorbeeld een document of een website liet analyseren, kon op basis van het resultaat niet meteen vragen om een relevante afbeelding te creëren.

Dat kan voortaan wel. Bing, Analytics en Dall-E zijn geen drie verschillende GPT-4-gebaseerde specialisten meer. GPT-4 in ChatGPT slorpt al hun capaciteiten op. Omdat die nu in één gesprek toegankelijk zijn, blijft de context van dat gesprek in je vraag behouden.

Aan de slag

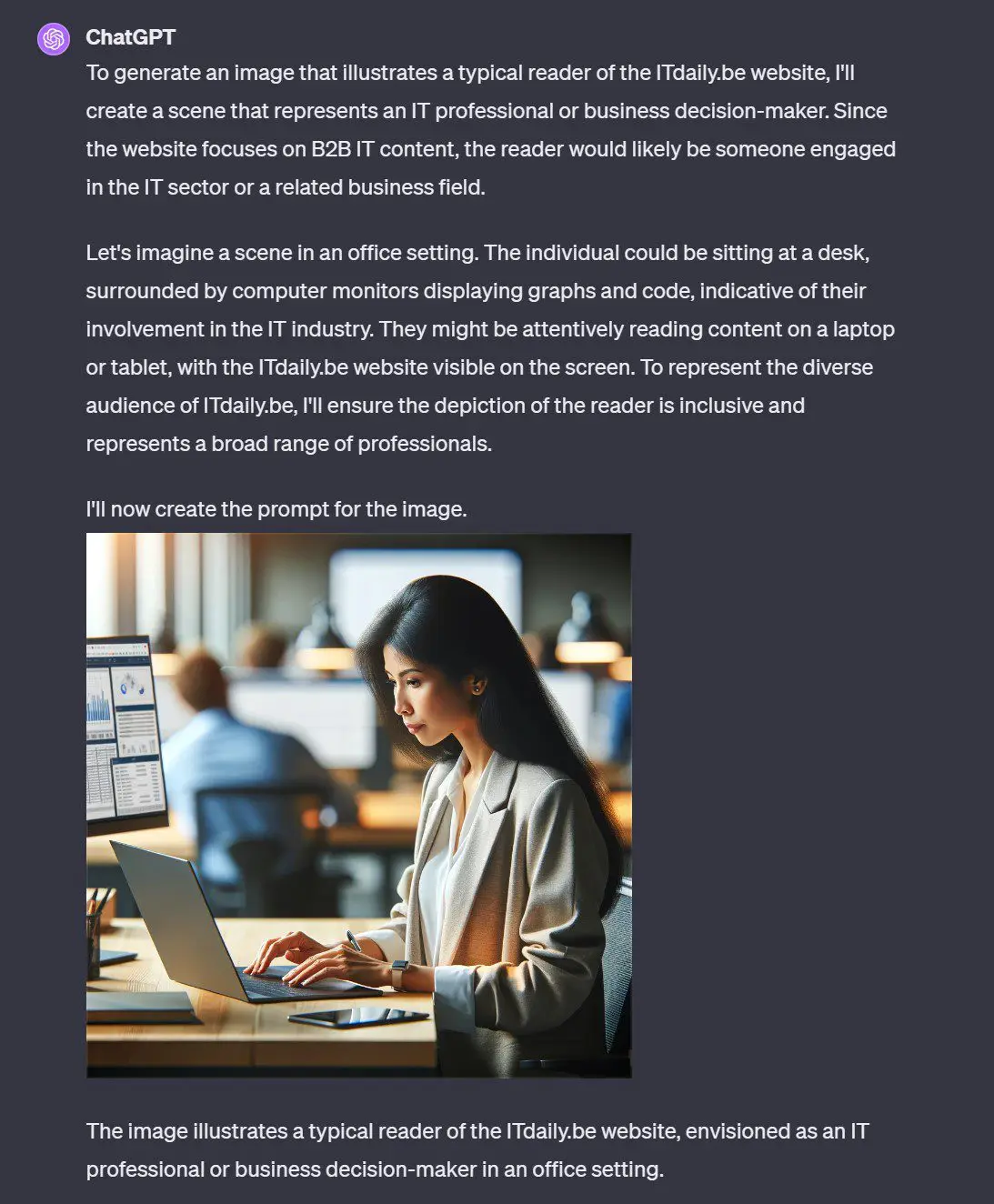

We experimenteerden met een aantal prompts. Zo vroegen we ChatGPT naar een omschrijving van ITdaily, waarna die via Bing naar onze site surfte, maar ook de relevante Wikipediapagina bekeek. Vervolgens vroegen we naar een omschrijving van jou, de typische lezer. Die genereerde de chatbot aan de hand van de resultaten. Tot slot gaven we de opdracht om een beeld te genereren van zo’n lezer. Rekening houdend met de context kregen we een passend beeld. Zoiets ging tot voor vandaag niet: we zouden eerst een conversatie over ITdaily moeten voeren, om vervolgens zelf een prompt voor Dall-E te genereren.

Een tweede test maakt de nieuwe capaciteiten nog duidelijker. Tot voor vandaag kon je:

- Een beeld uploaden en een beschrijving vragen in GPT-4

- Dat beeld uploaden in Analytics, voor de analyse van de kleuren en een historgram

- Dat beeld omschrijven bij Dall-E in een poging een gelijkaardige foto te genereren

GPT-4 kon de kleuren niet analyseren, Analytics begreep de inhoud van de afbeelding niet, en Dall-E kon de originele prent niet bekijken, maar enkel de omschrijving lezen. Vandaag kan je één afbeelding delen, een beschrijving vragen, de analyse van de kleuren verkrijgen en tot slot een nieuwe prent vragen die gelijkaardig is, zonder dat je zelf bijkomende beschrijvingen moet delen of kopiëren.

Je kan natuurlijk ook nog sneller gaan, een afbeelding uploaden en meteen vragen voor een gelijkaardig beeld. ChatGPT is nu slim genoeg om op de achtergrond de nodige analyses uit te voeren. In onderstaand voorbeeld vroegen we meteen bij het uploaden om een vergelijkbare prent te maken.

1+1=3

De samenvoeging van de verschillende generatieve AI-capaciteiten die OpenAI de afgelopen weken en maanden uitbouwde, is een belangrijke stap. Eén plus één is in dit geval minstens drie, aangezien de diverse capaciteiten elkaar versterken en op elkaar kunnen inspelen. Als gebruiker is de AI-tool bovendien plots een stuk handiger geworden: je hoeft niet meer na te denken over welke subversie van GPT-4 het geschiktst is om een probleem op te lossen. Stel een vraag, en ChatGPT doet de rest. De nieuwe capaciteit is om dit moment enkel beschikbaar voor betalende gebruikers.