Vorig jaar stelde Google zijn nieuwste TPU 3.0-chips voor aan het grote publiek. Na een jaar van puur intern gebruik stelt het de Cloud TPU Pods beschikbaar in béta voor geïnteresseerde testers. De focus van de pods ligt op machine learning (ML).

De beschikbaarheid van Cloud TPU Pods door Google biedt ML-wetenschappers een extra infrastructuuroptie voor AI-projecten op grote schaal. Een Cloud TPU Pod is in feite een set van server racks die in een datacenter staan van Google. Elke rack zit vol met Googles eigen Tensor Processor Units (TPU) die specifiek werden ontwikkeld voor AI-toepassingen.

Google heeft sinds de lancering vorig jaar de chips voornamelijk zelf gebruikt voor onder andere zijn zoekmachine en Google Translate. TPU’s waren tot op vandaag enkel individueel beschikbaar. Nu elimineert de zoekgigant die limiet en kan je bepaalde slices of een hele TPU Pod huren.

Twee TPU-versies

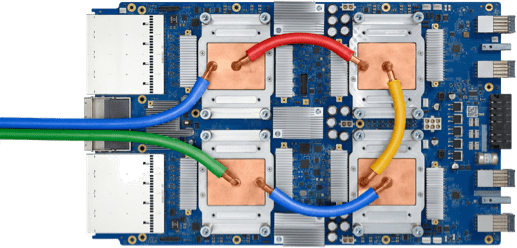

Google stelt zowel TPU 2.0- als TPU 3.0-configuraties beschikbaar. De tweede generatie TPU’s heeft Google in 2017 aangekondigd en is beschikbaar in een 256-chipversie met een totale pieksnelheid van 11,5 petaflops. De TPU 3.0-chips kan je raadplegen in een 1.024-chipconfiguratie die in totaal 107,5 petaflops aan rekenkracht kan leveren. Ter vergelijking: de snelste supercomputer van dit moment in de Top 500-lijst heeft een pieksnelheid van 200,8 petaflops. De Cloud Pods met TPU 3.0-chips worden watergekoeld.

Cloud TPU Pods kunnen echter enkel hun topsnelheid halen wanneer ze minder complexe data moeten verwerken. Daarin zit het grote verschil vergeleken met configuraties zoals de IBM Summit in de VS. Google stelt de hardware beschikbaar via een programming interfaces applicatie waar AI-teams kunnen werken met de TPU’s alsof ze een enkele logical unit zijn.

Schaalbaar

Zak Stone, Senior Product Manager for Cloud TPU bij Google benadrukt dat het ook mogelijk is om kleine secties van Cloud TPU Pods te gebruiken. “We zien dikwijls dat ML-teams hun initiële modellen ontwikkelen op individuele Cloud TPU toestellen die algemeen beschikbaar zijn. Daarna kunnen ze die progressief uitbreiden naar grotere Cloud TPU Pod slices via zowel data parallelism als model parallelism.”

De Cloud TPU Pods zijn vandaag beschikbaar in béta. Google benadrukt dat de Pods het best functioneren wanneer je heel snel een model moet trainen met een hoge accuraatheid over grote datasets met miljoenen gelabelde voorbeelden. Daarnaast kan je de Cloud TPU Pods ook altijd gebruiken om snel nieuwe modellen te prototypen.

Ontdek al het nieuws vanop Google I/O 2019

Gerelateerd: Google TPU 3.0: snellere AI dankzij waterkoeling