Google stelt als eerste grote publieke cloudprovider instances met de nieuwe Ampére A100 gpu’s van Nvidia ter beschikking. Die moeten machine learning-gerelateerde taken drastisch versnellen.

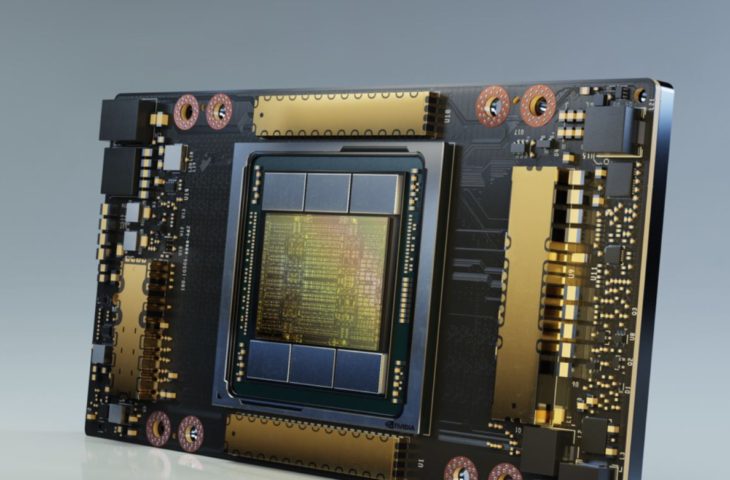

Midden mei lanceerde Nvidia de Ampére A100-gpu. Die zakelijke accelerator is bedoeld om machine learning-taken drastisch te versnellen en werd door Nvidia op maat van het datacenter ontwikkeld. Het Google Cloud Platform kondigt nu als eerste grote provider de beschikbaarheid van A100-instances aan.

Met de A100 claimt Nvidia een verbetering van training en inferentie met factor 20 vergeleken met de vorige generatie van gpu, al is dat slechts in selecte gevallen waar. In de regel mag je eerder een verbetering van tussen de 5x en 10x verwachten, al is dat nog altijd stevig. De kaart komt met 19,5 Tflops aan single precision-rekenkracht.

Specificaties

De gpu’s komen terecht in nieuwe A2 VM-instances van GCP. Manish Sainani, Director of Product Management bij Google Cloud, benadrukt dat Google AWS en Azure ook te snel af was bij de introductie van de T4-gpu’s van Nvidia. Instances komen in verschillende smaakjes met tot 16 A100’s aan boord, vergezeld van 640 GB aan gpu-geheugen, 96 cpu-rekenkernen en 1,3 TB aan systeemgeheugen. Natuurlijk zijn er ook meer bescheiden configuraties beschikbaar. Instappen kan vanaf één A100 met een 12 core-cpu.

De instances zijn per direct beschikbaar in een alpha-testfase. Brede publieke beschikbaarheid en bijhorende prijzen volgen later dit jaar.