De vraag naar steeds meer rekenkracht, en vooral de bijhorende stijging van TDP-waardes en wattages, zet druk op datacenters. Luchtkoeling kan tot op een bepaald niveau, maar waterkoeling is onvermijdelijk de toekomst als de huidige trend zich voortzet.

Wie vandaag naar het serverlandschap kijkt, ziet dat de TDP-waarden (Thermal Design Power) van cpu’s en gpu’s enorm toenemen. De krachtigste chips verbruiken 300 watt (cpu) tot 500 watt (gpu), wat ontzettend belastend is in een serverrack met beperkte ruimte voor luchtkoeling. Door de densiteit van de huidige servers zijn de luchtstromen nauwelijks verder te optimaliseren.

De volgende stap lijkt waterkoeling, maar daar heerst nog de nodige scepsis rond. Logisch ook: waterkoeling in een datacenterrack staat gelijk aan vloeken in de kerk omdat één lek genoeg is om alles te beschadigen.

Kettingreactie

De Wet van Moore wordt echter door Intel en in een kettingreactie door AMD gevolgd, wat de hand van beide forceert om steeds hogere prestaties te leveren. Deze stap gaat gepaard met een hogere TDP-waarde en bijhorende koelvereisten.

In een HPC-omgeving (High Performance Computing) kunnen aansluit- en koelingswaarden per rack al behoorlijk snel tientallen kilowatts bedragen. Daar is een compacte en performante koeling essentieel om het maximale uit de architectuur te halen. Rick Koopman, EMEA Technical Leader HPC bij Lenovo: “Toevallig heb ik twee weken geleden een systeemarchitectuur uitgetekend met een verbruik van 70 kilowatt per rack, met een combinatie van cpu’s en gpu’s. Dan moet je naar waterkoeling grijpen.”

De Wet van Moore gaat hand in hand met een hogere TDP-waarde en bijhorende koelvereisten.

Volgens hem kan je 16 tot 20 kilowatt per rack koelen met klassieke luchtkoeling. Wie met gekoelde deuren werkt achteraan, kan tot 35 kilowatt koelen. Alles daarboven heeft nood aan waterkoeling. Je mag echter geen vergelijking maken met de DIY-waterkoelingkits die beschikbaar zijn voor desktoppc’s. In watergekoelde datacenters of HPC-omgevingen zal je nergens een druppel water kunnen zien.

Watervrij

Koopman benadrukt dat geen enkele technieker ooit water moet laten aflopen wanneer er onderhoud nodig is aan een server. “Wij werken met zogenaamde US Defense Grade Drip Free-koppelingen. Zo kan je ondanks de waterdruk perfect aan- en afkoppelen zonder dat er een druppel water lekt. Het Amerikaanse leger gebruikt dezelfde koppelingen voor brandstoftoepassingen, waarbij één druppel een ontploffing kan veroorzaken. Veilig genoeg dus…”

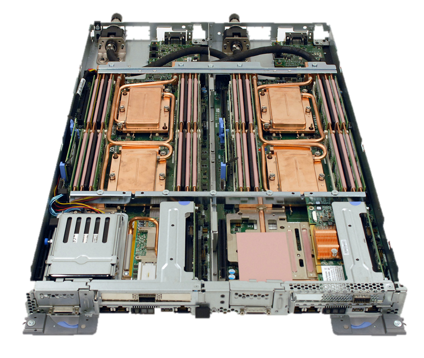

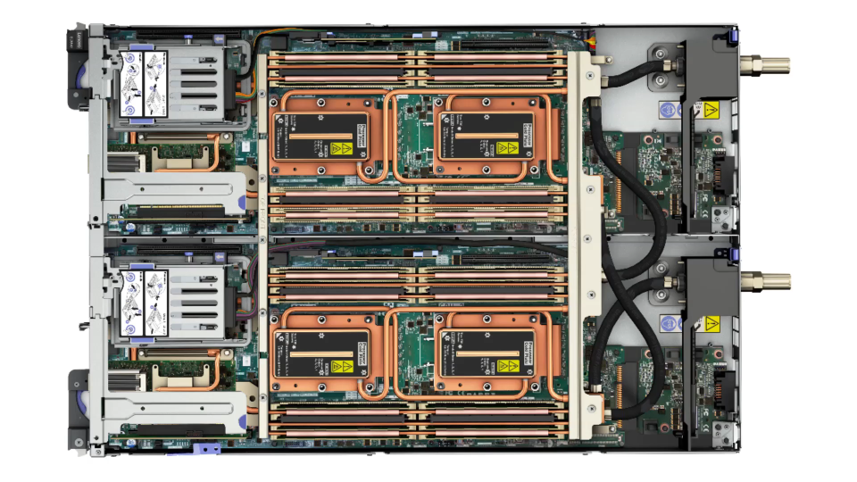

Bij onderhoud kan je gewoon twee nodes eruit trekken, terwijl alles blijft draaien. Lenovo maakt ook enkel gebruik van koperen leidingen met stalen koppelingen. De reden hierachter is de betere thermische eigenschap van koper vergeleken met pvc. Ook de hoeveelheid water in de buis is altijd continu volgens Koopman, terwijl dat bij pvc-buizen kan variëren. “Je kan de koelefficiëntie veel beter voorspellen en beheren met koper. Bovendien is het ook veel duurzamer.”

Ondanks dat de hardware wordt gekoeld met water, voorziet men geen speciale behandeling van de hardware. Elk systeembord heeft al een coating tegen oxidatie en condens. Het enige wat verschilt, is dat de klassieke koelvinnen en ventilatoren plaats maken voor koper en koelelementen waar water door vloeit.

Koperconnecties

De fabricage van de koelmodules wordt met waterkoeling wel delicater dan luchtkoeling. Ieder heeft zijn eigen methodes volgens Koopman. “Wij gebruiken één vaste template waar alle koelelementen apart van de node in elkaar worden gesoldeerd. We proberen het aantal koperconnecties tot het minimum te beperken. Het resultaat is één stuk waarbij we de flow rate van het water voorspelbaar kunnen berekenen. Die cool loop wordt samen met de koelelementen in elkaar gezet los van de server.”

“Wij gebruiken één vaste template waar alle koelelementen apart van de node in elkaar worden gesoldeerd.”

“Van zodra de server klaar is, kunnen we het waterkoelingelement plaatsen. Het raamwerk van tubes valt over de twee cpu’s en het aanwezige interne geheugen. Het gaat om één mal. Wanneer je niet alle geheugenslots gebruikt, worden de bijhorende koelelementen ook niet gebruikt.”

Het koperen frame bevat ook coolplates voor NVMe-opslag en de (low latency) netwerkadapter (Intel Omni Path, Mellanox EDR/HDR of 100Gb Ethernet). Waarom? Binnen een Mellanox Infiniband-netwerk gebeurt heel wat processing (offloading van rekenwerk naar de netwerkkaart) aan de netwerkstekker. Koeling is daar essentieel voor betere prestaties.

Voor gpu’s heeft Lenovo nog geen oplossing, maar daar komt volgend jaar verandering in. Volgens Koopman komt er in 2020 ondersteuning voor het SXM3 gpu-formaat (opvolger van de huidige Nvidia Tesla SXM2 V100). Vandaag gebeurt de koeling van de gpu’s nog met lucht en koeldeuren achteraan.

Warmwaterkoeling

Koopman benadrukt dat de temperatuur van het koelwater ook belangrijk is. “Wij waren de eerste in de sector die met warm water gingen koelen. Dat klinkt tegenstrijdig, maar water heeft de goede eigenschap om warmte af te voeren. In onze koeling vertrekt het water aan 50 graden Celsius en komt het toe aan 60 graden Celsius bij de koelunit (zes rackslots hoog). Daar wordt het water gekoeld tot 50 graden en is de cyclus rond.”

Je kan dat warme water bovendien ook flexibel inzetten in andere projecten. Zo kan je de restwarmte gebruiken om een ruimte of campus ergens te verwarmen. De restwarmte kan je door een warmtewisselaar (adsorptiekoeler) sturen voor gekoelde deuren achteraan een serverrack.

Adsorptiekoelen is een procss waarbij een gel-achtige substantie gebruikt wordt om warmte uit warm water te onttrekken en het vervolgens te verdampen, en dus gekoeld water te produceren. Dat kan worden gebruikt voor het koelen van aparatuur die nog gekoeld water nodig heeft en koeldeuren achter op het rack.

“In onze koeling vertrekt het water aan 50 graden Celsius en komt het toe aan 60 graden Celsius bij de koelunit.”

De hoge temperatuur van het water is geen probleem voor de computerhardware. Alles onder de 80 graden Celcius is prima voor de levensduur van de componenten. Warmwaterkoeling is duurder dan klassieke luchtkoeling voor een bestaand rekencentrum, omdat daar vaak de chillers al aanwezig zijn, maar veel hangt af of er al een waterlus/voorziening aanwezig is in het datacenter. Wanneer dat in orde is, schat Koopman dat een rack met waterkoeling ongeveer twee tot drie procent meer kost dan eenzelfde variant met luchtkoeling.

Waarom springt niet iedereen op de kar van waterkoeling in datacenters en HPC-installaties? Volgens Koopman ligt dit aan de investeringen die datacenters moeten doen. “Wanneer je net twee jaar geleden zwaar hebt geïnvesteerd als datacenter in een vernieuwde infrastructuur zonder waterlussen, ga je die aanpak niet opeens veranderen. Ik schat dat vandaag 10 tot 15 procent van de datacenters voorzien zijn van waterlussen en eenvoudig aan de slag kunnen. De meeste centra die vier jaar of ouder zijn, hebben het niet en lopen tegen dat probleem aan.”

Wet van Moore

Koopman is alvast zeker dat waterkoeling de enige manier is om de komende twintig jaar te overbruggen. “De Wet van Moore dicteert partijen als Intel, Nvidia en AMD. Meer rekenkracht betekent meer energie. Bovendien plant Intel een verkleining naar 10 nanometer voor Xeon-chips in 2020. Een chip met een hogere densiteit betekent meer prestaties, maar tegelijk verkleint ook de ruimte om elke component te koelen.”

“Een chip met een hogere densiteit betekent meer prestaties maar tegelijk verkleint ook de ruimte om elke component te koelen.”

Lenovo ziet overigens dat iedereen bezig is met waterkoeling vandaag. Warmwaterkoeling wordt steeds meer de norm. Bovendien kan je de densiteit beperken op een rack met waterkoeling. Zelfs enterprise datacenters en hyperscalers zullen uiteindelijk allemaal overstappen naar waterkoeling om betere en toekomstgerichte prestaties te kunnen leveren. Volgens Koopman is er geen ontkomen aan.

Gerelateerd: Lenovo over supercomputers, eigen chips, AMD en HPC-benchmarks