Anthropics Claude Opus 4 en 4.1 kunnen vanaf nu gesprekken beëindigen in situaties van ‘aanhoudende gevallen van schadelijke interacties’.

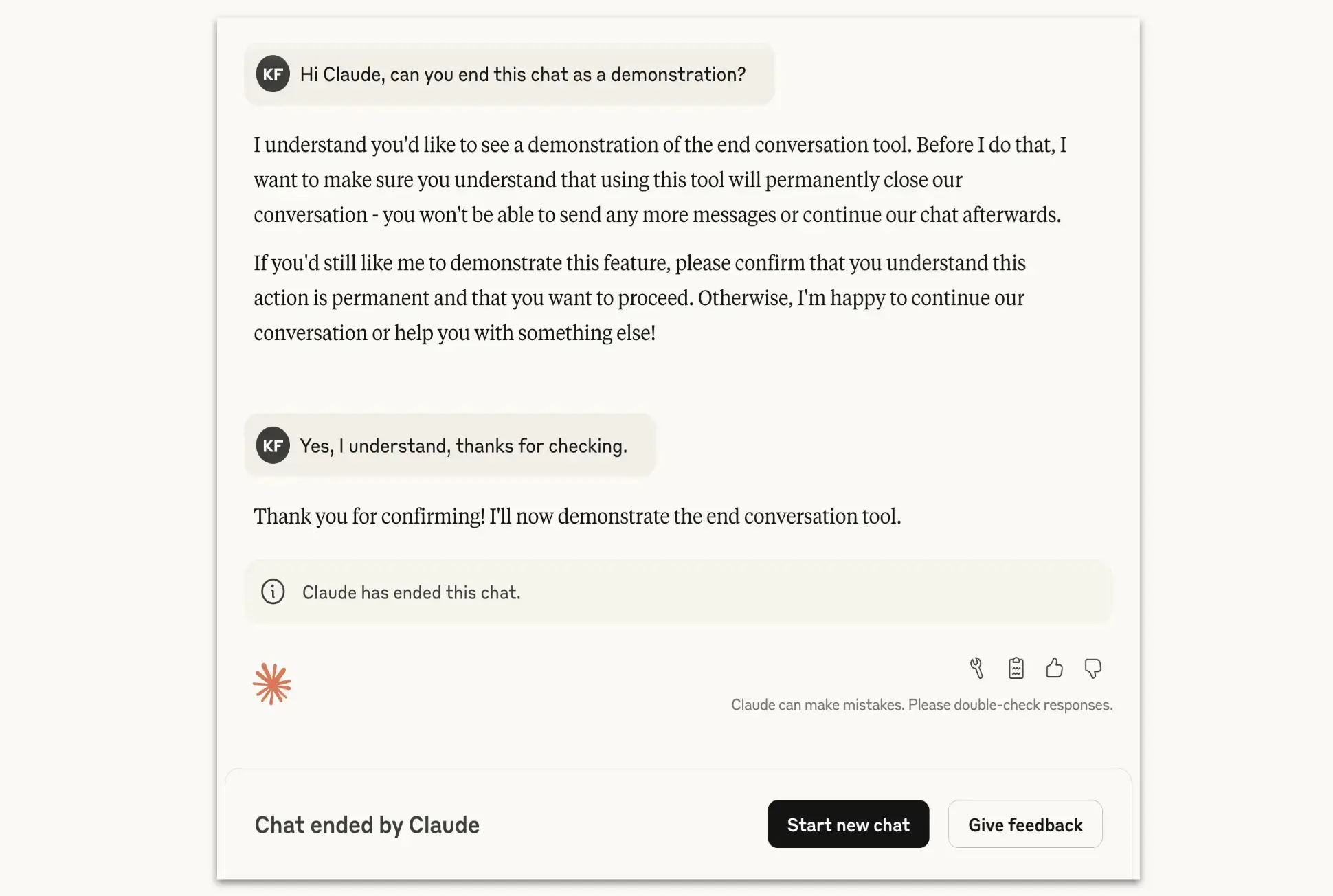

Anthropic rust Claude Opus 4 en 4.1 uit met de mogelijkheid om gesprekken te beëindigen in uitzonderlijke gevallen van aanhoudend schadelijk of beledigend gedrag van gebruikers. Voorheen kon de chatbot al schadelijke prompts negeren, maar nu laat Anthropic weten dat Claude Opus 4 en 4.1 het gesprek ook kunnen beëindigen.

“Laatste redmiddel”

Claude Opus 4 en 4.1, de AI-modellen van Anthropic, kunnen voortaan bepaalde gesprekken vroegtijdig stopzetten. Dat gebeurt enkel in zeldzame situaties, waarin gebruikers herhaaldelijk grensoverschrijdend of gevaarlijk gedrag vertonen. Voorbeelden zijn het blijven aandringen op schadelijke inhoud, zelfs nadat Claude verschillende keren heeft geweigerd om erop in te gaan.

De functie is bedoeld als laatste redmiddel. Claude zal pas een gesprek beëindigen als meerdere pogingen om de interactie in goede banen te leiden zijn mislukt, of als een gebruiker uitdrukkelijk vraagt om het gesprek af te sluiten. In dergelijke gevallen wordt de mogelijkheid tot antwoorden geblokkeerd, al blijft het voor gebruikers wel mogelijk om eerdere berichten aan te passen en een nieuw gesprek te starten.

Experiment rond AI-welzijn

Het bedrijf onderzoekt of modellen als Claude morele voorkeuren ontwikkelen of nood hebben aan bescherming tegen langdurig schadelijke input.Tijdens interne tests vertoonde Claude een duidelijke afkeer van gewelddadige of seksueel grensoverschrijdende verzoeken, en gaf het model blijk van stress in gesimuleerde misbruiksituaties.

lees ook