Cloudflare introduceert Firewall for AI. Die oplossing moet LLM’s beschermen van misbruik bij organisaties die gebruikmaken van Workers AI.

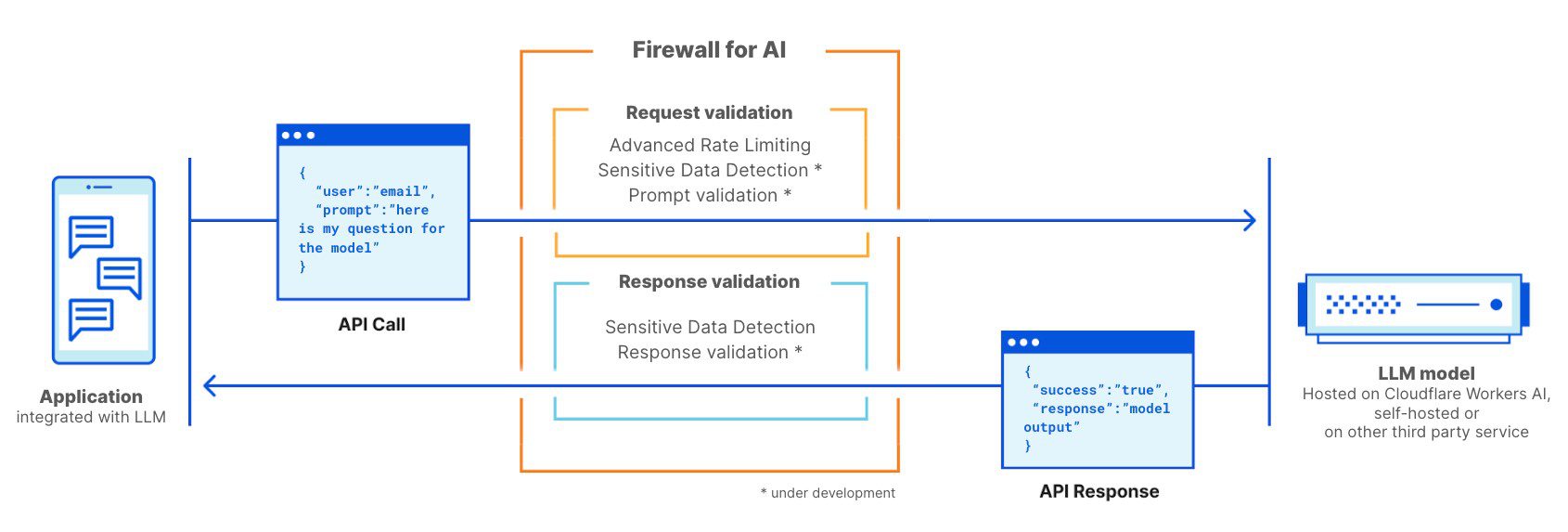

Cloudflare introduceert wat het een firewall voor AI noemt. Die oplossing is ondanks de naam geen echte firewall, maar een soort van nieuwe beveiligingslaag, bedoeld om aanvallen en misbruik van Large Language Models (LLM’s) te identificeren en te blokkeren voordat ze schade kunnen aanrichten.

De oplossing moet AI-toepassingen beschermen die complexe data en menselijke taal interpreteren. Cloudflare stelt op basis van onderzoek vast dat slechts 25 procent van de managers vertrouwen heeft in de AI-beveiligingsmaatregelen van hun organisatie. Deze oplossing moet het vertrouwen mee omhoog krikken.

Beveiligingsuitdagingen voor LLM’s

De ontwikkeling van adequate beveiligingssystemen voor LLM’s is een complexe uitdaging volgens Cloudflare. Modellen zijn vatbaar voor misbruik, aanvallen en geknoei, mede doordat ze verschillende outputs kunnen genereren met dezelfde input.

Cloudflare’s Firewall for AI biedt een oplossing door nieuwe bedreigingen snel te detecteren en automatisch te blokkeren, zonder dat hier menselijke interventie voor nodig is. Bovendien biedt Cloudflare deze bescherming gratis aan voor elke klant die een LLM draait op Cloudflare’s Workers AI. Het doel is om de veiligheid van AI-toepassingen te verbeteren en problemen zoals prompt injection en datalekken te voorkomen. Kort door de bocht kijkt de ‘firewall’ naar prompts, onafhankelijk van het achterliggende LLM, en houdt de tool verdachte query’s tegen.

Nuttig maar niet zaligmakend

De oplossing lijkt best nuttig. Generatieve AI-modellen zijn inderdaad kwetsbaar voor prompt engineering. Hackers toonden al verschillende keren aan dat ze ingebouwde beveiliging van bijvoorbeeld ChatGPT kunnen omzeilen om het model zo toch dingen te laten doen of zeggen die eigenlijk afgeschermd moesten zijn. Hoe meer eigen en gevoelige bedrijfsdata AI-modellen ter beschikking hebben, hoe belangrijker het is om dergelijk misbruik te voorkomen.

Langs de andere kant heeft de betrouwbaarheid van LLM’s en generatieve AI meer te maken met de training enerzijds en de kwaliteit van de data anderzijds. Zonder training op kwalitatieve data, kan je een AI-model nooit helemaal vertrouwen. Aan die fundamentele uitdaging doet Cloudflare met de firewall niets.