ChatGPT vereist een verbinding met het internet om zijn AI-assistent te gebruiken. Nvidia doet dat nu lokaal met Chat with RTX, zolang je een compatibele grafische kaart hebt.

Iedereen kent ondertussen ChatGPT en wat je ermee kan doen. Het enige wat je daarvoor nodig hebt, is een internetverbinding. Je kan aan de slimme assistent alles vragen, maar je boet automatisch in aan privacy. Nvidia wil dat oplossen met Chat with RTX, een tool waarmee je een eigen AI-chatbot bouwt die lokaal op je pc draait.

De technologie gebruikt retrieval-augmented generation (RAG), Nvidia TensorRT-LLM software en Nvidia RTX-acceleratie. Je hebt daarvoor wel een recente GPU voor nodig. Wie vandaag een Nvidia GeForce 30- of 40-serie grafische kaart heeft in zijn of haar laptop of desktop, kan met de gratis tool aan de slag op Windows 10 en Windows 11. Klik hier om te downloaden. De grafische kaart heeft wel minimaal 8 GB VRAM nodig.

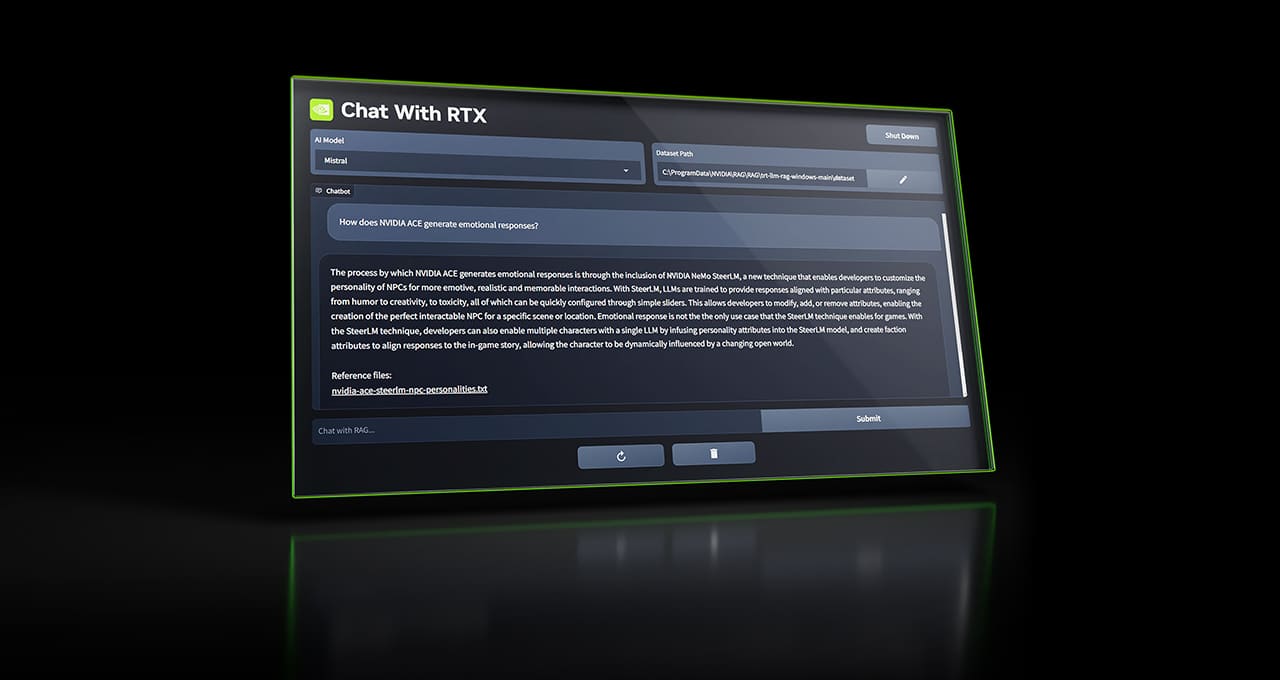

In de demo zien we dat je telkens een dataset moet inladen, waarna de tool de rest doet en antwoorden zoekt op je vragen. Alles blijft lokaal op je pc staan. Het enige wat wel een internetconnectie vraagt, is de analyse van een YouTube-video. De vraag die je daarrond stelt en het antwoord dat wordt gegenereerd, blijft wel lokaal op je pc staan.

Nvidia ondersteunt met Chat with RTX vandaag verschillende bestandstypes waaronder .txt, .pdf, .doc/.docx and .xml. Het enige wat je moet doen, is naar de map navigeren waar de data in staat. De tool doet de rest.

De fabrikant moedigt ook ontwikkelaars aan om met Chat with RTX te spelen. Er is een basisproject op GitHub beschikbaar waarop je kan verder bouwen. Wie een AI-aangestuurde applicatie bouwt of een plug-in op basis van TensorRT-LLM RAG voor 23 februari, kan onder andere een Nvidia GeForce RTX 4090 winnen. Meer details daarover vind je hier.