Amerikaanse onderzoekers hebben een enorm LLM getraind met de Frontier-supercomputer. Daarvoor gebruikten ze slechts acht procent van de beschikbare accelerator-kracht.

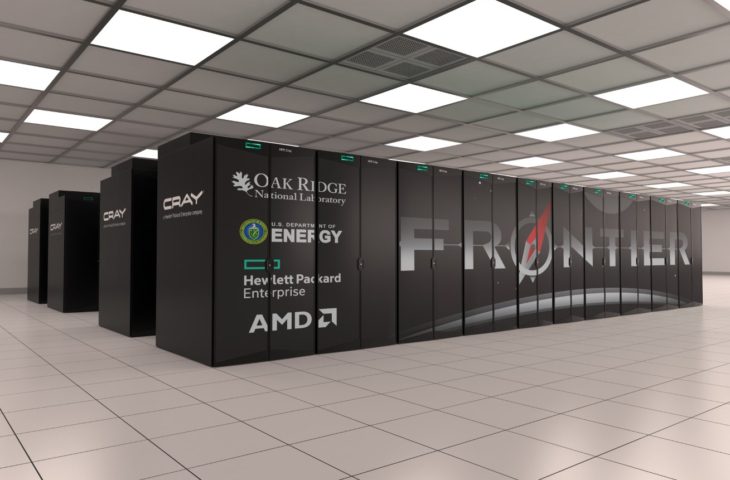

’s Werelds krachtigste supercomputer en eerste exascale-systeem Frontier weet wel raad met de training van Large Language Models (LLM’s). Dat blijkt uit een onderzoek van het Oak Ridge National Laboratory in de VS, waar die supercomputer staat. De researchers trainden twee LLM’s, één met een biljoen parameters en een ander met 175 miljard parameters. Daarvoor gebruikten ze slechts een fractie van de rekenkracht die Frontier ter beschikking heeft.

Geheugen

Frontier heeft 7.472 AMD Epyc 7A53-processors ter beschikking, bijgestaan door 37.888 AMD Instinct MI250X-accelerators. Geheugen is de voornaamste flessenhals voor de training van een LLM en de onderzoekers hadden zo’n 14 TB nodig. Iedere MI250X heeft 64 GB ter beschikking. GPU’s combineren is de oplossing, maar dergelijke immense parallellisering van de trainingsworkloads brengt op zichzelf complicaties met zich mee. De GPU’s moeten immers heel snel en nauwkeurig met elkaar communiceren.

Uiteindelijk gebruikten de onderzoekers 3.072 van de 37.888 GPU’s om de modellen te trainen. Schalen was een probleem, aangezien dergelijk werk doorgaans met Nvidia-hardware binnen het CUDA-ecosysteem gebeurt. De onderzoekers merkten op dat het concurrerende ROCm-platform van AMD toch wat meer spartaans is in vergelijking. Door hun werk geven de wetenschappers het AMD-ecosysteem een mooie boost.