De rekenkracht van de supercomputer Lumi, waar ook ons land in investeerde, wordt door academici gebruikt om zelf snel nieuwe maar ook open LLM’s te bouwen gericht op onderzoek.

Microsoft moest een supercomputer in de cloud bouwen om de GPT-3- en GPT-4-modellen te bouwen die ChatGPT aandrijven. De large language models (LLM’s) zijn echter niet open en transparant, en blijven eigendom van OpenAI. Onderzoekers van de universiteit van Turku in Finland willen daarom eigen LLM’s ontwikkelen voor gebruik in de academische wereld, die bovendien niet gebaseerd zijn op het Engels.

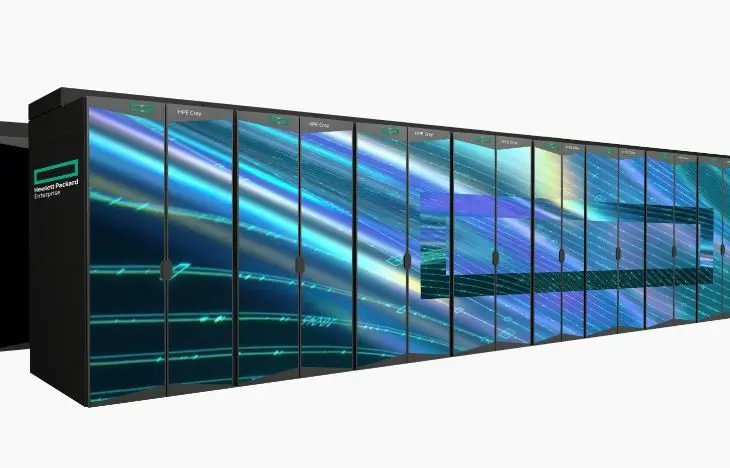

Lumi

Ook daar is een supercomputer voor nodig. Gelukkig staat er een echte vlakbij: Lumi. Lumi staat in Finland en heeft een rekenkracht van 309 petaflops. Het systeem, gebouwd door een consortium waar ook ons land deel van uitmaakt, is op dit moment het op twee na krachtigste ter wereld. De onderzoekers gebruiken die rekenkracht om zelf complexe modellen te trainen binnen een werkbare tijdspanne.

lees ook

LUMI-supercomputer met deels Belgisch DNA is klaar voor gebruik

Met 192 nodes duurt het twee weken om een model met 176 miljard parameters te trainen. Ter vergelijking: GPT-4 zou een amalgaam van vier modellen zijn met iedere 220 miljard parameters.

Samen met AMD

De onderzoekers werken voor de nieuwe LLM’s samen met Hugging Face, dat zich intussen heeft opgeworpen als een soort GitHub voor AI-modellen. De inzet van Lumi is opvallend aangezien de meeste AI-modellen getraind worden met de hulp van Nvidia-hardware.

Vooral de krachtige Nvidia Hopper H100 is een populaire accelerator om training te ondersteunen. Lumi is echter helemaal gebaseerd op AMD-componenten, met een combinatie van Epyc-processors en Instinct MI250X-GPU’s. AMD werkte samen met de onderzoekers om de software te integreren met het complexe hardwareplatform.

Afstuderen in een EU-taal

De samenwerking is belangrijk omdat ze toont hoe de EU ook zonder Microsoft of AWS de nodige infrastructuur heeft om competitief te zijn in de ontwikkeling van AI. Bij de universiteit van Turku lag de prioriteit op de ontwikkeling van een Fins LLM, maar het is de ambitie om zogenaamde funderingsmodellen te bouwen voor alle officiële Europese talen.

Zo’n funderingsmodel is een vooraf getraind model waarmee je aan de slag kan voor concrete toepassingen. Nvidia-CEO Jensen Huang vergeleek het met een pas afgestudeerde werkkracht, die veel kennis heeft maar natuurlijk nog wel een beetje opleiding binnen z’n specifieke eerste job nodig heeft. De universiteit werkt dus aan een soort Europese AI-school waar modellen afstuderen getraind in Europese talen. Het is de ambitie om ’s werelds grootste open model met uitgebreide ondersteuning voor Europese talen te bouwen.