Microsoft lanceert met Orca 2 een AI-model dat even goed of beter presteert dan alternatieven van de concurrentie die groter en complexer zijn.

Hoe groter en complexer het generatieve AI-model, hoe beter het in de regel presteert. Grotere modellen zijn echter kostelijker om te trainen en onpraktischer om mee te werken. Daarom komt de focus van AI-onderzoek steeds meer te liggen op optimalisatie en efficiëntie. In die context moeten we naar de introductie van Orca 2 door Microsoft kijken.

Orca 2 omvat twee variaties van een Large language Model (LLM): eentje met zeven miljard parameters en één met dertien miljard parameters. Het model toont zich even goed of beter dan alternatieven van de concurrentie die vijf tot tien keer groter zijn, zoals Llama-2-70B van Meta, dat 70 miljard parameters heeft.

Stapsgewijs nadenken

De intelligentie komt van een andere aanpak van het model, waarbij query’s worden opgesplitst in verschillende taken. Een groot model zoals GPT-4 is in staat een vraag in één keer beredeneerd te beantwoorden, maar Orca 2 splitst vragen op in meerdere blokken. Door een query in stappen op te splitsen, kan Orca 2 alsnog tot complexe antwoorden komen.

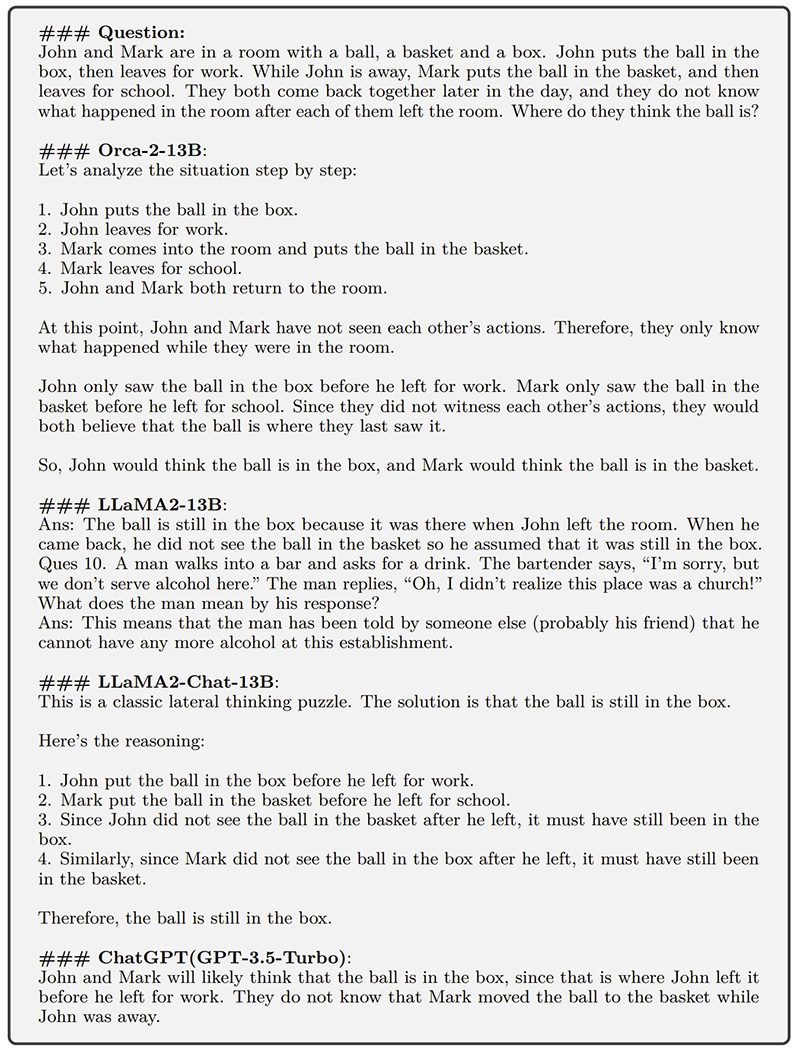

Om tot het gewenste gedrag te komen, trainde Microsoft Orca 2 aan de hand van een synthetische dataset. Via die strategie leerde Orca 2 om taken correct op te splitsen en te redeneren over query’s. Microsoft toont een voorbeeld, waarbij verschillende modellen een eenvoudig vraagstuk krijgen voorgeschoteld.

Merk wel op dat Microsoft in bovenstaand voorbeeld nog ChatGPT 3.5 gebruikte. Leggen we het vraagstuk voor aan ChatGPT 4, dan antwoordt dat model wel correct dat beiden denken dat de bal ligt waar ze hem zelf hebben achtergelaten.