Google Research heeft een nieuw AI-model ontwikkeld dat veel minder kans heeft om gevoelige trainingsdata letterlijk te herhalen.

Het model, VaultGemma, is het eerste LLM van Google dat is getraind met een techniek genaamd differentiële privacy. Die voegt ruis toe tijdens training om te voorkomen dat modellen gevoelige informatie ‘onthouden’.

Balans tussen privacy en prestatie

Het herhalen van trainingsdata is een bekend risico bij LLM’s. Ze hebben niet-deterministische outputs, wat wil zeggen dat je niet kunt voorspellen wat ze exact gaan antwoorden. Als ze gevoelige info verwerken in hun antwoorden kan dat tot privacyschendingen of juridische problemen leiden. Differentiële privacy voorkomt dat, maar verlaagt tegelijk de nauwkeurigheid en verhoogt de nodige rekenkracht.

Google onderzocht daarom hoe de hoeveelheid ruis zich verhoudt tot de benodigde data en rekenkracht. De techgigant stelde schaalwetten op om een ideale balans te vinden.

VaultGemma als testmodel van schaalwetten

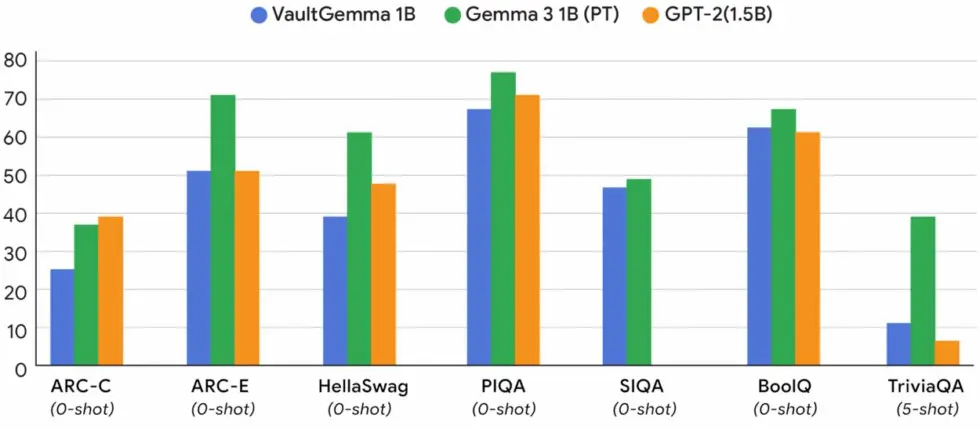

Dankzij de onderzoeken naar differentiële privacy kon Google op basis daarvan VaultGemma trainen. Dat is een compacte versie van de Gemma 2-modellenfamilie met 1 miljard parameters. Het model is niet erg groot, maar levert wel gelijkaardige prestaties als niet-private modellen van dezelfde grootte.

Volgens Google is dit een belangrijke stap in de ontwikkeling van AI die zowel krachtig als privé is. VaultGemma is nu beschikbaar met open gewichten op Hugging Face en Kaggle.