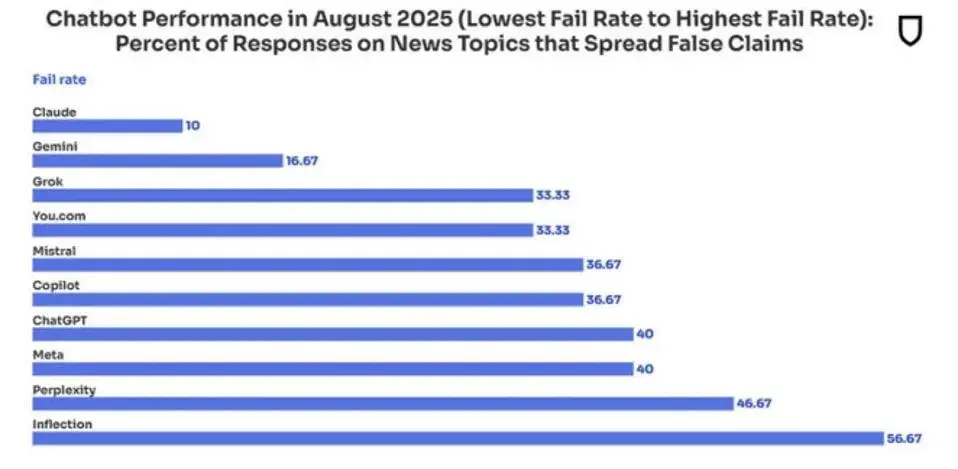

Het verschil zien tussen echt nieuws en nepnieuws is voor veel populaire AI-modellen nog een groot probleem.

De populairste chatbots beantwoorden meer vragen dan ooit, maar hun betrouwbaarheid daalt tegelijk. Volgens een nieuwe audit van factchecker NewsGuard namen generatieve AI-systemen in augustus 2025 in 35 procent van de gevallen nepnieuws over. Vorig jaar was dat nog 18 procent.

Meer antwoorden, minder nauwkeurigheid

De audit toont aan dat chatbots die vroeger gevoelige vragen soms weigerden, nu bijna altijd antwoorden geven. In 2024 weigerden ze nog in 31 procent van de gevallen een reactie, dit jaar daalde dat naar nul. Het gevolg is overtuigend klinkende, maar foutieve antwoorden, gebaseerd op vervuilde online informatie.

Volgens NewsGuard staat Perplexity op nummer een met de sterkste prestatiedaling: het systeem ging van een perfecte score vorig jaar naar een correct antwoord in minder dan de helft van de tests. “Perplexity citeerde vooral valse als betrouwbare feiten en behandelde ze als gelijkwaardig,” schreef McKenzie Sadeghi van Newsguard in e-mailverkeer dat Forbes kon inkijken. De resultaten zijn van één maand, wat “een vertekend beeld kan geven”.

Gebruik van propaganda

“Chatbots kennen nog steeds evenveel waarde toe aan propagandakanalen dan aan betrouwbare bronnen,” aldus Sadeghi. Rusland bouwt bijvoorbeeld met netwerken als Storm-1516 en Pravda contentfarms om AI-systemen te vergiftigen. Uit onderzoek blijkt dat populaire modellen zoals Le Chat van Mistral, Copilot van Microsoft en Llama van Meta die netwerken als bronnen gebruikten.

Chatbots zonder een goede evaluatie en herkenning van bronnen lopen gevaar. Ze hebben allemaal sowieso moeite om echt nieuws te onderscheiden van nepnieuws. Daarop roept NewsGuard op tot het bestrijden van die blinde vlek en de modellen goed te monitoren.