Ruim een jaar na de introductie van ChatGPT is kunstmatige intelligentie (AI) de meest impactvolle technologietrend. Deze staat inmiddels op de bestuursagenda van bijna elk bedrijf. Generatieve AI gaat het dagelijkse werk van veel mensen beïnvloeden en ingrijpende veranderingen veroorzaken.

Sommige AI-toepassingen gaan we dagelijks gebruiken op onze telefoon, laptop, tablet, smartwatch en andere ‘slimme’ apparaten, zoals camera’s. Deze bevinden zich aan de randen of ‘edge’ van het internet en bedrijfsnetwerken. Hoe gaat AI zich daar de komende jaren verder ontwikkelen?

Waar draaien AI-modellen?

Deze vraag kunnen AI-ontwikkelaars het beste zelf beantwoorden. Momenteel spant vooral de datacentermarkt zich in om de verwachte, maar nog niet gegarandeerde, grote toename van de vraag naar generatieve AI-toepassingen te kunnen faciliteren.

Het trainen van AI-modellen gebeurt nu vooral in grote datacenters, die qua ontwerp dichter bij de supercomputers van het afgelopen decennium liggen dan de bedrijfsnetwerken. Die datacenters hebben daarvoor grote hoeveelheden stroom, koeling en tienduizenden GPU’s nodig.

Maar hoe verloopt het daarna? Als het model eenmaal is getraind, waar wordt het dan gebruikt? Elk AI-model zal tijdens de gebruiksfase meer rekenkracht nodig hebben, omdat het maar een korte tijd wordt getraind en daarna door miljoenen mensen jarenlang wordt gebruikt. Dat gebeurt dan merendeels gedistribueerd, op eenvoudigere GPU’s of CPU’s van de dagelijkse gebruikers.

De AI-training kan dus centraal plaatsvinden, omdat het enkele maanden duurt om modellen te maken en latency daarbij een ondergeschikte rol speelt. Zodra het model en de AI-toepassing in de echte wereld beschikbaar zijn en door steeds meer mensen worden gebruikt, kan de tijd die nodig is om te laden en te reageren echter bedrijfskritisch worden.

Om tijdig te anticiperen op de ontwikkeling van AI is het verstandig om na te denken over hoe deze technologie de edge-infrastructuur gaat beïnvloeden. Cloudflare beschikt al in ruim 100 steden over Nvidia GPU’s, die onze ‘Workers AI’-service aanbieden voor generatieve AI. Dit jaar gaan we dat verder in ons wereldwijde netwerk uitbreiden, met datacenters in meer dan 300 steden.

AI-inferentie

Sommige experts verwachten dat AI-inferentie te delegeren is naar de mobiele apparaten van de eindgebruikers die met AI-toepassingen werken. De huidige generatie telefoons hebben weliswaar veel rekenkracht, de A17-chip in de iPhone 15 met zes GPU-kernen kan 4K-video met maximaal 60 fps verwerken, maar dat is nog niet genoeg voor zware AI-toepassingen.

Er zijn zeker enkele AI-toepassingen op mobiele apparaten uit te voeren, maar dat blijft beperkt. Die apparaten hebben namelijk een veel beperkte hoeveelheid processor-, opslag- en tevens batterijcapaciteit, dan de datacenters en servers van bedrijfsnetwerken.

Mensen praten graag over waar hun nieuwste telefoons toe in staat zijn met de krachtige GPU’s, maar als je deze vergelijkt met een Nvidia GPU die op een server draait, zijn er nog ordes van grootte aan verschillen in rekenkracht. Sommige toepassingen kunnen zeker op telefoons en tablets draaien, zoals stemherkenning voor AI-systemen en Google Assistant. Toch verwachten wij dat de beperkte hardware ervoor zal zorgen dat grote en geavanceerde AI-modellen geschikter zijn om aan de edge te verwerken.

Meta’s Llama 2 is ruim 100 gigabyte groot, dus veel te zwaar voor onze mobiele apparaten. Als we dat model op de edge hosten en de AI-inferentie met daar aanwezige GPU’s verwerken, zijn de beperkingen in bandbreedte en performance merendeels weg te nemen. Door zo’n toepassing te combineren met de capaciteit van een mobiel apparaat ontstaat er een krachtige combinatie.

Waar latency belangrijk is

Ons bedrijfsmodel is gebaseerd op dicht bij de gebruikers aanwezige datacenters, sommige spelen een substantiële rol, maar de meeste zijn klein en overal aanwezig. Ze functioneren onder andere bij cloudproviders, telecombedrijven, of in regionale datacenters. Elke geografische regio is anders en elk land heeft zijn eigen uitdagingen. Dat heeft geleid tot een omvangrijke, wereldwijde infrastructuur die zich richt op het verminderen van de latency.

Wij zijn 50 milliseconden verwijderd van 95 procent van de wereldbevolking. Wat kun je daarmee? Beveiliging bieden en content distribueren voegen beide waarde toe. Een logische aanvulling daarop is AI-inferentie, omdat je echt moet nadenken over hoe latency de prestaties beïnvloedt en wat we kunnen doen om (AI-)applicaties een boost te geven.

Dit plan gaan we de komende tijd verder uitrollen: nu generatieve AI zo snel verandert, blijven ook de gebruiksscenario’s zich ontwikkelen. Sommige workloads, zoals het genereren van video’s en afbeeldingen, kost enige tijd, dus heeft het reduceren van de latency maar een beperkte impact.

Nu generatieve AI zo snel verandert, blijven ook de gebruiksscenario’s zich ontwikkelen.

Tony van den Berge

Gebruikers zijn regelmatig gefrustreerd over de snelheid van ChatGPT-gesprekken, maar dit heeft waarschijnlijk meer te maken met de snelheid die het model nodig heeft om te functioneren (naast GPU-tekorten) dan met de fysieke nabijheid van gebruikers. Ook deze toepassing kan profiteren van het decentraal verwerken aan de edge.

Latency wordt belangrijker voor nieuwe generatie AI-toepassingen. Bij de virtuele assistent Siri wil je als gebruiker dat het lijkt op een echt gesprek. Daarvoor is echter een flinke combinatie aan capaciteit nodig van het mobiele apparaat, de cloud en de Edge. Op termijn kunnen bijvoorbeeld ook zelfrijdende auto’s profiteren van generatieve AI om hun omgeving beter waar te nemen.

Hoewel de huidige autonome voertuigen vaardig zijn geworden in beeldherkenning, zou een groot taalmodel kunnen helpen bij de interpretatie van die beelden. De auto kan bijvoorbeeld een man of een kind langs de kant van een weg herkennen, maar als een LLM dat doet kan het waarschijnlijk beter begrijpen dat een kind misschien ineens tegen het tegemoetkomende verkeer in oversteekt. Autonoom rijdende auto’s zullen waarschijnlijk altijd blijven vertrouwen op ingebouwde rekenkracht voor hun realtime beslissingen en reacties, vanwege de noodzakelijke extreem lage latency.

Een andere generatieve AI-toepassing voor de edge is compliance. In sommige regio’s is het gebruik van data streng gereguleerd, maar het mainstream karakter van generatieve AI zou tot veel meer toezicht door de overheid kunnen leiden. Mogelijk gaan landen verschillende versies van modellen eisen die passen bij de eigen visie op vrijheid van informatie, privacy, auteursrecht, en arbeidsbescherming

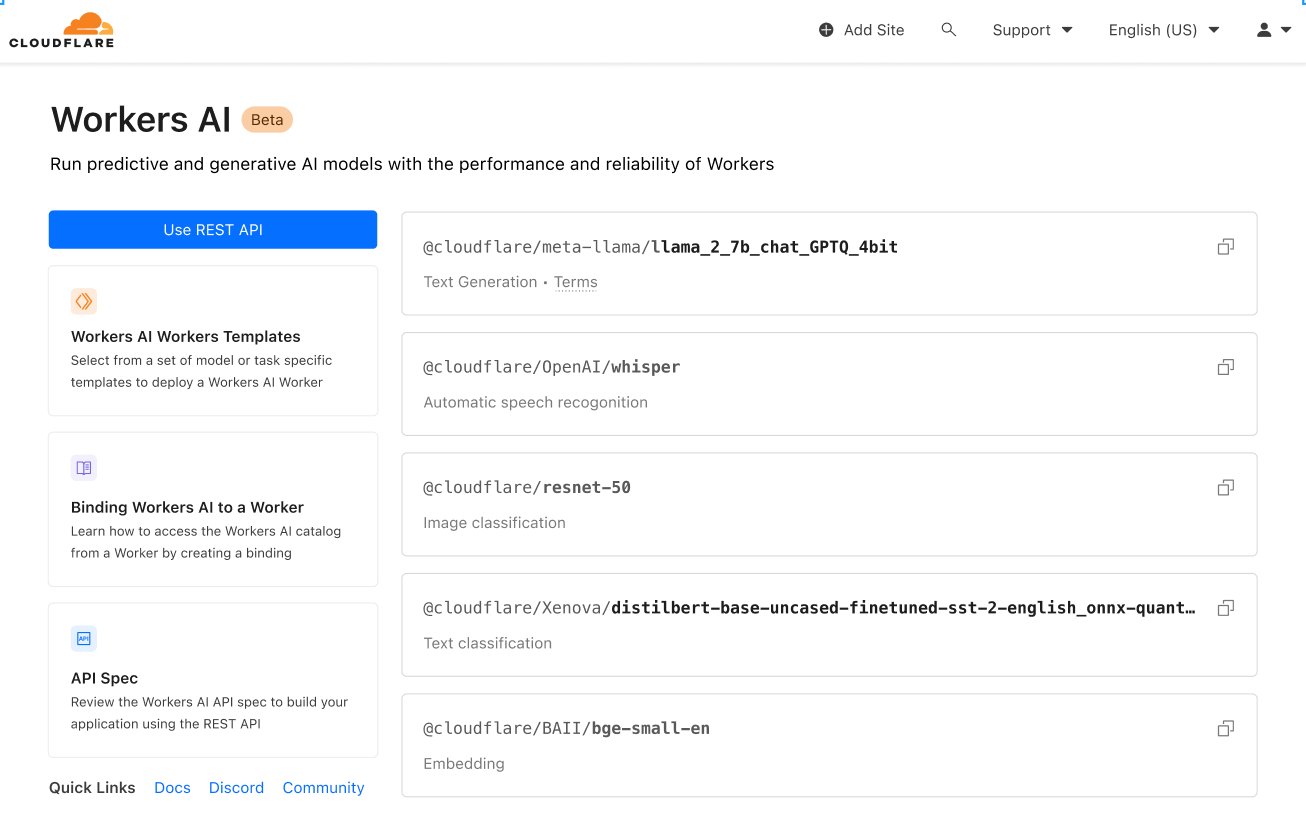

Workers AI

Cloudflare’s Workers AI biedt nu al veel AI-functionaliteit, maar bevat ook nog wat beperkingen. Het ondersteunt momenteel Meta’s Llama 2 7B en M2m100-1.2, OpenAI’s Whisper, Hugging Face’s Distilbert-sst-2-int8, Microsoft’s Resnet-50 en Baai’s bge-base-en-v1.5 modellen. De komende tijd gaan wij echter steeds meer modellen toevoegen, met behulp van Hugging Face.

Onze eerste focus was de meest gangbare gebruiksscenario’s te faciliteren. Tegelijkertijd moeten we oplossingen bedenken om de kosten te beheersen die gepaard gaan met het hosten van eigen modellen en hoe die in onze cloud draaien. Caching is een belangrijke: op hoeveel plaatsen wil je dat hetzelfde model draait en hoe snel moet het beschikbaar zijn op deze verschillende locaties?

Er zijn ook al klanten die om specifieke toepassingen vragen en daarvoor gaan we dan uitzoeken hoe deze het beste te verwerken zijn. De eerste versie van Workers AI is bedoeld om veel mensen te laten zien wat er mogelijk is met zakelijke AI-toepassingen. Sinds de introductie daarvan werkt ons team verder aan de volgende releases.

Voldoende vraag naar AI

Wij zien al veel bedrijven de eerste stappen zetten richting het toepassen van generatieve AI. Sommigen hebben al hun eigen chatbots gebouwd bovenop Cloudflare’s Edge. Ons doel is het voor ontwikkelaars zo eenvoudig mogelijk te maken om applicaties te testen en te implementeren. AI staat nog in de kinderschoenen en veel toepassingen bevinden zich dus nog in de bètamodus.

De komende tijd zullen AI-toepassingen steeds beter worden en veranderen in applicaties waar mensen dagelijks mee werken, met strikte SLA’s voor de uptime en prestaties. Daarvoor is het belangrijk dat mensen ons vertellen wat ze willen bereiken. Die feedback zal dan leiden tot een transformatie, vergelijkbaar met grote technologische transformaties uit het verleden.

De opkomst en ontwikkeling van AI doet me denken aan eerdere keerpunten in de IT-wereld, zoals de opkomst van internet zo’n 40 jaar geleden. Daarna volgden de opkomst van mobiele apparatuur en de cloud. Nu AI er is lijkt deze technologie nog groter en impactvoller dan alle anderen samen. Het benut namelijk al hun voordelen en bouwt erop voort om deze nieuwe technologie te lanceren.

Evoluerend netwerk

Het is nu nog moeilijk te voorspellen hoe diep- en vergaand de AI-transformatie wordt. Er is ook een risico dat de zeepbel barst en wij alle zeilen bij moeten gaan zetten om de GPU’s voor andere toepassingen te hergebruiken. Bijvoorbeeld om met AI ons eigen netwerk nog slimmer te maken.

Dan is er natuurlijk een grote kans dat deze technologie z’n hype waarmaakt. Dat straks elk bedrijf met eigen modellen gaat werken (of een eigen versie van een model), en dat iedereen regelmatig via spraak of zelfs video met een virtuele assistent praat.

Een snelle groei van AI-toepassingen kan al op korte termijn om een verandering vragen van de schaalgrootte waarop wij moeten opereren. Dan is er veel meer capaciteit nodig in de kleine of op telecom gerichte datacenters dan tot nu toe wordt gevraagd, waardoor er meer grootschalige datacenter- en edge-implementaties nodig zijn.

Binnen Cloudflare zijn er verschillende versies van wat wij als edge beschouwen. Zo is er een edge die zich ergens in een patchkast in het datacenter van een partner bevindt, versus onze grotere eigen infrastructuur in steden als Amsterdam en New York met veel inwoners.

Cloudflare’s netwerk blijft in de loop van de tijd evolueren en veranderen, het is net een levend iets. Tegelijkertijd investeren wij in mensen die de hyperscale-markt echt goed begrijpen, zodat onze teams groeien in termen van het kunnen innoveren in die context. Bottomline hebben wij al een robuuste fundering gecreëerd als basis voor alle AI-toepassingen die nog op ons pad komen.

Dit is een ingezonden bijdrage van Tony van den Berge, VP European Regional Markets bij Cloudflare. Klik hier voor meer informatie over het bedrijf.